Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Seth Ginns

Managing Partner @coinfund_io. fost investitor în acțiuni la Jennison Associates; IBD la Credit Suisse

Opinii personale. Nu consultanță de investiții

Convergența se accelerează

@HyperliquidX DAT a anunțat acest lucru, condus de Atlas Merchant Capital (Bob Diamond, Fmr, CEO, Barclays), cu participarea D1 Capital (Dan Sundheim, Fmr, CIO, Viking). Președintele Fed din Boston, Eric Rosengren, se așteaptă să se alăture consiliului de administrație

Seth Ginns13 iul., 19:19

Da, companiile de trezorerie ar trebui să se tranzacționeze la o primă față de VAN

Ce?

🧵

10,41K

Seth Ginns a repostat

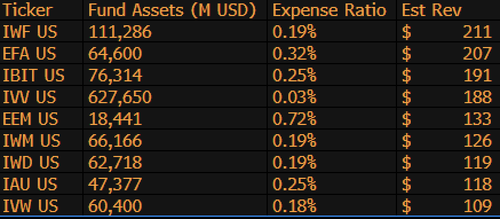

$IBIT este acum al 3-lea cel mai mare ETF generator de venituri pentru BlackRock din 1.197 de fonduri și este la doar 9 miliarde de dolari distanță de a fi #1. Doar o altă statistică nebună pentru un ETF vechi de 1,5 ani (literalmente un copil). Iată lista Top 10 pentru BLK (deoparte, ce zici de $IWF de uitat pe primul loc, cine ar fi știut?)

107,99K

Seth Ginns a repostat

Stablecoin-urile vor schimba drastic modul în care instituțiile financiare abordează criptomonedele, iar șeful CoinFund pentru investiții lichide s-@sethginns alăturat recent @thebenkeadyshow pentru a vorbi despre convingerea sa în numărul tot mai mare de cazuri ⬇️ de utilizare

845

Votați proiectul de lege al Senatului astăzi la ora 16:30 ET

Senate Cloakroom17 iun. 2025

La ora 16:30, Senatul este așteptat să procedeze la două voturi prin apel nominal cu privire la următoarele:

1. (Dacă se invocă închiderea) Confirmarea calendarului executiv #98 Olivia Trusty pentru a fi membru al Comisiei Federale de Comunicații pentru restul mandatului care expiră la 30 iunie 2025.

2. Adoptarea Cal. #66, S.1582, Legea GENIUS, astfel cum a fost modificată.

752

Seth Ginns a repostat

Randamentele onchain rămân la îndemâna majorității oamenilor. În ciuda faptului că sunt fără permisiune, complexitatea lor îi descurajează pe mulți să participe.

Prin parteneriatul nostru strâns cu @Veda_labs, aceste complexități ale plasmei vor fi eliminate pentru a aduce randament durabil maselor.

33,71K

Seth Ginns a repostat

Predicții rapide.

2025: Model de parametri 100B+ antrenat pe rețelele d.

2026: Primul model 50B+ *multi-modal* antrenat pe GPU-uri voluntare.

2027-8: Toate celelalte sunt egale, modelul competitiv dens GPT-3 175B a fost reprodus.

2030+: O adevărată "frontieră" descentralizată, 1T params+.

3,66K

Seth Ginns a repostat

Gânduri/predicții în antrenamentul AI descentralizat, 2025.

1. Un lucru de spus este că suntem cu siguranță într-o lume diferită cu antrenamentul AI descentralizat decât eram acum 18 luni. Pe atunci, instruirea descentralizată era imposibilă și acum este pe piață și este un domeniu.

2. Nu vă înșelați, scopul final al d-training este de a antrena modele competitive, de frontieră pe rețelele d. Ca atare, suntem doar la începutul călătoriei noastre competitive, dar ne mișcăm rapid.

3. Acum este un consens că putem pre-antrena și post-antrena modele de mai multe miliarde de parametri (în mare parte LLM-uri, în mare parte arhitecturi de transformatoare) pe rețelele d. Starea actuală a artei este de până la ~100B, al cărei capăt superior este la vedere, dar nu a fost arătat.

4. Acum este consens că putem antrena modele de parametri <10B pe rețelele d destul de fezabil. Au existat, de asemenea, studii de caz specifice (în principal din @gensynai @PrimeIntellect @NousResearch) în care parametrii 10B, 32B, 40B au fost sau sunt antrenați. Roiul post-antrenament al @gensynai funcționează pe modele de până la 72 de miliarde de parametri.

5. Inovația @PluralisHQ a invalidat acum "imposibilitatea" pre-instruirii scalabile pe rețelele D prin eliminarea blocajului de ineficiență a comunicațiilor. Cu toate acestea, FLOP-urile brute, fiabilitatea și verificabilitatea rămân blocaje pentru aceste tipuri de rețele - probleme care sunt foarte rezolvabile, dar vor dura ceva timp pentru a fi rezolvate din punct de vedere tehnic. Cu Protocol Learning from Pluralis așa cum este, cred că ajungem la ~100B modele pe un interval de timp de 6-12 luni.

6. Cum ajungem de la modele de parametri 100B la 300B? Cred că trebuie să găsim modalități de a fragmenta eficient și fluid parametrii și de a menține memoria individuală a dispozitivului relativ scăzută (de exemplu, <32 GB de memorie per dispozitiv). Cred că trebuie să ajungem la 20 de EFlops într-o rețea; asta înseamnă ceva de genul 10-20K dispozitive de consum care rulează timp de 4-6 săptămâni într-un antrenament.

În general, d-training este pregătit să fie un spațiu foarte interesant. Unele dintre inovațiile sale sunt deja luate în considerare pentru aplicații largi de inteligență artificială.

4,14K

Limită superioară

Clasament

Favorite

La modă pe lanț

La modă pe X

Principalele finanțări recente

Cele mai importante