Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Fui uno de los 16 desarrolladores en este estudio. Quería expresar mis opiniones sobre las causas y estrategias de mitigación para la desaceleración del desarrollo.

Diré como un gancho de "¿por qué debería escucharte?" que experimenté una aceleración de -38% en la velocidad de IA en mis problemas asignados. Creo que la transparencia ayuda a la comunidad.

11 jul, 01:23

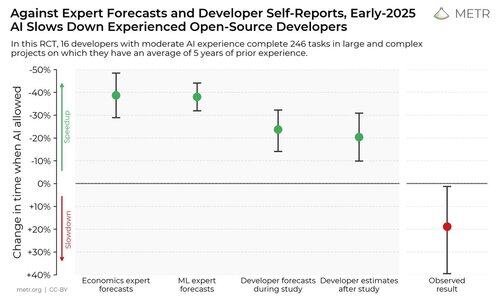

Realizamos un ensayo controlado aleatorizado para ver cuánto aceleran las herramientas de codificación de IA a los desarrolladores experimentados de código abierto.

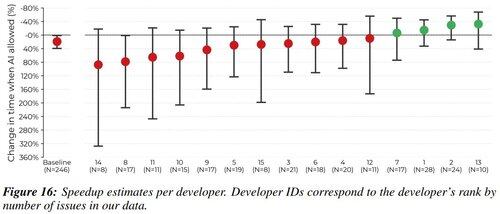

Los resultados nos sorprendieron: los desarrolladores pensaban que eran un 20% más rápidos con las herramientas de IA, pero en realidad eran un 19% más lentos cuando tenían acceso a la IA que cuando no lo tenían.

En primer lugar, creo que la aceleración de la IA está muy débilmente correlacionada con la capacidad de alguien como desarrollador. Todos los desarrolladores en este estudio son muy buenos. Creo que tiene más que ver con caer en modos de fallo, tanto en la capacidad del LLM como en el flujo de trabajo del humano. Trabajo con un montón de increíbles desarrolladores de preentrenamiento, y creo que las personas enfrentan muchos de los mismos problemas.

Nos gusta decir que los LLM son herramientas, pero los tratamos más como una bala mágica.

Literalmente, cualquier desarrollador puede atestiguar la satisfacción de finalmente depurar un problema espinoso. Los LLM son un gran botón de atajo de dopamina que puede resolver tu problema de un solo golpe. ¿Sigues presionando el botón que tiene un 1% de probabilidad de arreglarlo todo? Es mucho más agradable que la alternativa agotadora, al menos para mí.

Creo que pueden ocurrir casos de sobreuso de LLM porque es fácil optimizar para el disfrute percibido en lugar del tiempo hasta la solución mientras se trabaja.

Yo presionando tab en el cursor durante 5 horas en lugar de depurar durante 1:

En tercer lugar, es muy fácil distraerse en el tiempo de inactividad mientras los LLM están generando. La economía de atención en las redes sociales es brutal, y creo que la gente pasa 30 minutos desplazándose mientras "espera" su generación de 30 segundos.

Todo lo que puedo decir sobre esto es que deberíamos conocer nuestras propias trampas y tratar de llenar este tiempo de generación de LLM de manera productiva:

- Si la tarea requiere alta concentración, aprovecha este tiempo para trabajar en una subtarea o pensar en preguntas de seguimiento. Incluso si el modelo responde a tu pregunta de un solo golpe, ¿qué más no entiendo?

- Si la tarea requiere baja concentración, haz otra pequeña tarea mientras tanto (responder correos/slack, leer o editar otro párrafo, etc).

Como siempre, pequeños pasos de higiene digital ayudan con esto (bloqueadores de sitios web, teléfono en modo no molestar, etc). Perdón por ser un poco gruñón, pero me funciona :)

Algunas declaraciones finales:

- METR es una organización maravillosa con la que trabajar, y son científicos excepcionales. He disfrutado tanto participar en este estudio como leer sus resultados.

- No soy un gurú de LLM tratando de predicar. Piensa en esto como si estuviera publicando una entrada de diario personal, y esperando que otros puedan beneficiarse de mi introspección.

1,72M

Parte superior

Clasificación

Favoritos