Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Saya sangat bersemangat tentang potensi kesetiaan rantai pemikiran & interpretabilitas. Ini telah secara signifikan memengaruhi desain model penalaran kami, dimulai dengan pratinjau o1.

Karena sistem AI menghabiskan lebih banyak pekerjaan komputasi misalnya untuk masalah penelitian jangka panjang, sangat penting bagi kita untuk memiliki beberapa cara untuk memantau proses internal mereka. Properti luar biasa dari CoT tersembunyi adalah bahwa meskipun mereka memulai dengan bahasa yang dapat kita tafsirkan, prosedur pengoptimalan yang dapat diskalakan tidak bertentangan dengan kemampuan pengamat untuk memverifikasi maksud model - tidak seperti misalnya pengawasan langsung dengan model hadiah.

Ketegangan di sini adalah bahwa jika CoT tidak disembunyikan secara default, dan kami melihat proses tersebut sebagai bagian dari output AI, ada banyak insentif (dan dalam beberapa kasus, kebutuhan) untuk mengawasinya. Saya percaya kita dapat bekerja menuju yang terbaik dari kedua dunia di sini - melatih model kita untuk menjadi hebat dalam menjelaskan penalaran internal mereka, tetapi pada saat yang sama masih mempertahankan kemampuan untuk memverifikasinya sesekali.

Kesetiaan CoT adalah bagian dari arah penelitian yang lebih luas, yaitu pelatihan untuk interpretabilitas: menetapkan tujuan dengan cara yang melatih setidaknya sebagian dari sistem untuk tetap jujur & dapat dipantau dengan skala. Kami terus meningkatkan investasi kami dalam penelitian ini di OpenAI.

16 Jul, 00.09

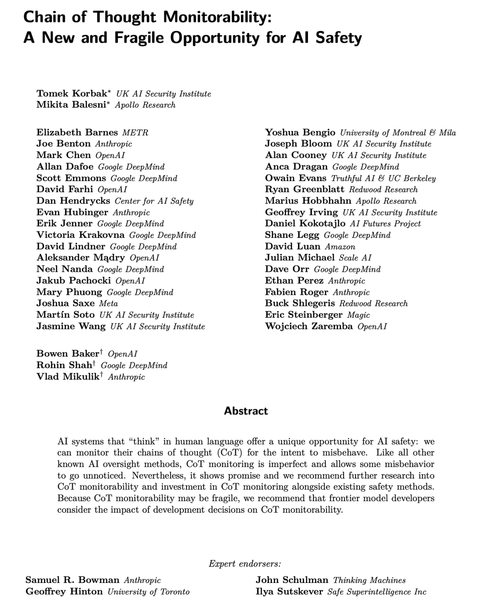

Model penalaran modern berpikir dalam bahasa Inggris sederhana.

Memantau pemikiran mereka bisa menjadi alat yang kuat, namun rapuh, untuk mengawasi sistem AI di masa depan.

Saya dan para peneliti di banyak organisasi berpikir kita harus bekerja untuk mengevaluasi, melestarikan, dan bahkan meningkatkan kemampuan pemantauan CoT.

264,16K

Teratas

Peringkat

Favorit