Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

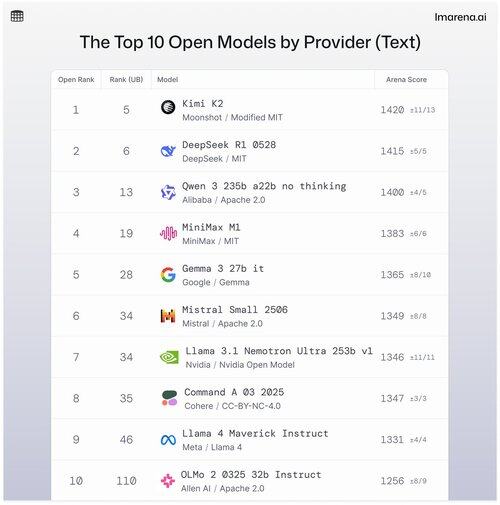

🧵10 Model Terbuka Teratas berdasarkan Penyedia

Meskipun model berpemilik sering menduduki puncak tangga lagu, model terbuka juga dipasangkan dalam mode pertempuran, dan diberi peringkat di papan peringkat publik kami.

Berikut adalah 10 teratas saat ditumpuk oleh model terbuka teratas oleh penyedia.

- #1 Kimi K2 (MIT yang Dimodifikasi) @Kimi_Moonshot

- #2 DeepSeek R1 0528 (MIT) @deepseek_ai

- #3 Qwen 235b a22b tidak berpikir (Apache 2.0) @alibaba_qwen

- #4 MiniMax M1 (MIT) @minimax_ai

- #5 Gemma 3 27b it (Gemma) @googledeepmind

- #6 Mistral Small Ultra (Apache 2.0) @mistral_ai

- #7 Llama 3.1 Nemotron Ultra 253b v1 (Model Terbuka Nvidia) @nvidia

- #8 Perintah A (Cohere) @cohere

- #9 Llama 4 Maverick Instruct (Llama 4) @aiatmeta

- #10 OLMo 2 32b Instruksi (Apache 2.0) @allen_ai

Lihat utas untuk mempelajari lebih lanjut tentang 5 teratas dalam daftar 👇 ini

Kimi K2 - #1 di Open Arena!

Jika Anda telah memperhatikan model open source, model baru dari perusahaan AI yang sedang naik daun, Moonshot AI, ini membuat gelombang sebagai salah satu LLM open-source paling mengesankan hingga saat ini. Komunitas kami memberi tahu kami bahwa mereka juga menyukai cara mereka menanggapi Kimi K2: Kimi lucu tanpa terdengar terlalu robotik.

Kimi K2 dibangun di atas arsitektur Mixture-of-Experts (MoE), dengan total 1 triliun parameter, di mana 32 miliar di antaranya aktif selama inferensi tertentu. Desain ini membantu model menyeimbangkan efisiensi dan kinerja sesuai permintaan.

Model terbuka teratas DeepSeek, DeepSeek R1-0528, peringkat #2

R1-0528 adalah versi R1 yang disetel instruksi yang disempurnakan, dan model obrolan terbuka terbaik #2 menurut komunitas. Kuat dalam dialog multi-giliran dan tugas penalaran.

R1 (baseline) adalah yang asli, masih solid tetapi sekarang sedikit di belakang varian penyetelan yang lebih baru.

V3-0324 adalah model MoE dengan total parameter 236B, tetapi hanya mengaktifkan beberapa ahli per perintah. Ini membuatnya kuat dan efisien. Ini berkinerja baik di seluruh instruksi, penalaran, dan tugas multibahasa, tetapi format prompt lebih penting di sini daripada dengan R1-0528.

Qwen 235b a22b (tidak berpikir) adalah peringkat model terbuka teratas Alibaba di #3

235B-a22b-no-thinking adalah model mentah tanpa penyetelan instruksi (dengan demikian "tidak berpikir").

Ini bagus dalam generasi dan peringkat tinggi di komunitas karena kekuatan penalarannya yang mentah.

Beberapa model terbuka teratas lainnya dengan komunitas kami dari Alibaba meliputi:

Varian 32B dan 30B-a3b adalah alternatif yang lebih kecil dan lebih cepat dengan kinerja yang solid, meskipun mereka tertinggal di belakang model papan atas. Dengan 32B yang lebih padat di antara keduanya, komunitas lebih memilih akurasinya daripada 30B-a3b. 30B-a3b adalah model MoE yang membuatnya sedikit lebih cepat.

qwq-32b dirancang khusus untuk mengatasi masalah penalaran yang kompleks dan bertujuan untuk mencocokkan kinerja model yang lebih besar seperti DeepSeek R1, tetapi tidak cukup membuat tanda itu ketika diuji di dunia nyata.

MiniMax M1 masuk dalam daftar dengan peringkat model teratas mereka di #4

M1 juga menonjol karena pendekatan uniknya dengan arsitektur MoE yang dikombinasikan dengan bentuk perhatian yang disebut "Lightning Attention", mekanisme linier yang dibuat khusus untuk pemrosesan token efisiensi tinggi.

Pendekatan ini pasti menarik perhatian komunitas kami karena sangat pandai dalam dialog, penalaran, dan mengikuti instruksi.

Google DeepMind mendarat di #5 dengan model terbuka teratas mereka, Gemma 3 27b it

Gemma 3 adalah model bahasa multimodal dengan bobot terbuka. Gemma 3 dapat menangani input teks dan gambar, unggul dalam penalaran, tugas konteks panjang, dan aplikasi bahasa visi. Komunitas kami menyukai bagaimana Gemma ini meningkatkan efisiensi memori dan meningkatkan dukungan untuk konteks yang lebih besar dibandingkan versi sebelumnya.

25,27K

Teratas

Peringkat

Favorit