Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

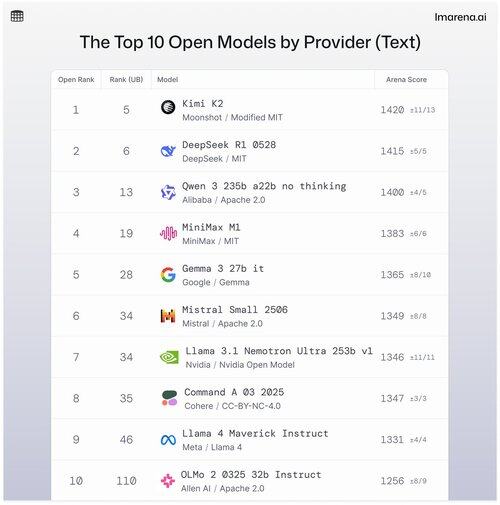

🧵I 10 migliori modelli aperti per fornitore

Sebbene i modelli proprietari spesso dominino le classifiche, i modelli aperti sono anche abbinati in modalità battaglia e classificati nelle nostre classifiche pubbliche.

Ecco i 10 migliori quando sono ordinati per miglior modello aperto per fornitore.

- #1 Kimi K2 (Modified MIT) @Kimi_Moonshot

- #2 DeepSeek R1 0528 (MIT) @deepseek_ai

- #3 Qwen 235b a22b senza pensare (Apache 2.0) @alibaba_qwen

- #4 MiniMax M1 (MIT) @minimax_ai

- #5 Gemma 3 27b it (Gemma) @googledeepmind

- #6 Mistral Small Ultra (Apache 2.0) @mistral_ai

- #7 Llama 3.1 Nemotron Ultra 253b v1 (Nvidia Open Model) @nvidia

- #8 Command A (Cohere) @cohere

- #9 Llama 4 Maverick Instruct (Llama 4) @aiatmeta

- #10 OLMo 2 32b Instruct (Apache 2.0) @allen_ai

Guarda il thread per saperne di più sui primi 5 di questa lista 👇

Kimi K2 - #1 nell'Open Arena!

Se hai prestato attenzione ai modelli open source, questo nuovo modello dell'azienda emergente di intelligenza artificiale, Moonshot AI, sta facendo scalpore come uno dei modelli LLM open-source più impressionanti fino ad oggi. La nostra comunità ci dice che amano anche il modo in cui Kimi K2 risponde: Kimi è umoristico senza sembrare troppo robotico.

Kimi K2 è costruito su un'architettura Mixture-of-Experts (MoE), con un totale di 1 trilione di parametri, di cui 32 miliardi sono attivi durante qualsiasi inferenza. Questo design aiuta il modello a bilanciare efficienza e prestazioni on-demand.

Il miglior modello open di DeepSeek, DeepSeek R1-0528, si classifica al #2

R1-0528 è una versione raffinata e ottimizzata per le istruzioni di R1, ed è il secondo miglior modello di chat open secondo la comunità. È forte nei dialoghi a più turni e nei compiti di ragionamento.

R1 (baseline) è l'originale, ancora solido ma ora leggermente indietro rispetto alle varianti di tuning più recenti.

V3-0324 è un modello MoE con 236 miliardi di parametri totali, ma attiva solo pochi esperti per ogni prompt. Questo lo rende sia potente che efficiente. Si comporta bene in compiti di istruzione, ragionamento e multilingue, ma il formato del prompt è più importante qui rispetto a R1-0528.

Qwen 235b a22b (senza pensare) è il modello open top di Alibaba classificato al #3

235B-a22b-senza-pensare è un modello grezzo senza ottimizzazione delle istruzioni (da qui "senza pensare").

È ottimo nella generazione e ha un'alta valutazione nella comunità grazie al suo potere di ragionamento grezzo.

Altri modelli open top della nostra comunità di Alibaba includono:

Le varianti 32B e 30B-a3b sono alternative più piccole e veloci con prestazioni solide, anche se sono inferiori ai modelli di fascia alta. Con 32B che è più denso tra i due, la comunità preferisce la sua accuratezza rispetto a 30B-a3b. 30B-a3b è un modello MoE che lo rende un po' più veloce.

qwq-32b è specificamente progettato per affrontare problemi di ragionamento complessi e mira a eguagliare le prestazioni di modelli più grandi come DeepSeek R1, ma non riesce a raggiungere quel livello quando viene messo alla prova nel mondo reale.

MiniMax M1 entra nella lista con il loro modello di punta classificato al #4

M1 si distingue anche per il suo approccio unico con l'architettura MoE combinata con una forma di attenzione chiamata "Lightning Attention", un meccanismo linearizzato progettato appositamente per l'elaborazione efficiente dei token.

L'approccio ha sicuramente catturato l'attenzione della nostra comunità per essere davvero efficace nel dialogo, nel ragionamento e nel seguire le istruzioni.

Google DeepMind si posiziona al #5 con il loro miglior modello open, Gemma 3 27b.

Gemma 3 è un modello di linguaggio multimodale a pesi aperti. Gemma 3 può gestire sia input testuali che immagini, eccellendo nel ragionamento, nei compiti a lungo termine e nelle applicazioni visione-linguaggio. La nostra comunità ama come questo Gemma abbia migliorato l'efficienza della memoria e aumentato il supporto per contesti più ampi rispetto alle versioni precedenti.

31,75K

Principali

Ranking

Preferiti