トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

なぜRLの研究をやめて、製品に取り組むべきなのか //

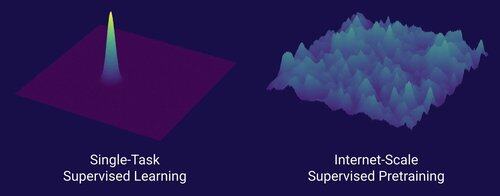

AIの大きなスケーリングシフトを解き放ったテクノロジーは、トランスフォーマーではなくインターネットです

AIにおいてデータが最も重要なことであり、また、研究者がとにかくデータに取り組まないことを選択することはよく知られていると思います。...データに(スケーラブルな方法で)取り組むとはどういう意味ですか?

インターネットは、豊富なデータの豊富なソースを提供し、それは多様で、自然なカリキュラムを提供し、人々が実際に気にかけている能力を表し、大規模に展開するための経済的に実行可能なテクノロジーでした。

トランスフォーマーがなければ、いくつものアプローチが軌道に乗ったかもしれませんし、GPT-4.5のようなレベルのCNNや状態空間モデルもできたでしょう。しかし、GPT-4以降、ベースモデルに劇的な改善は見られませんでした。推論モデルは狭い領域では優れていますが、2023年3月(2年以上前)のGPT-4ほど大きな飛躍ではありません。

強化学習には素晴らしいものがありますが、私が深く恐れているのは、過去(2015-2020年代のRL)の過ちを繰り返して、どうでもいいRL研究をしてしまうことです。

インターネットが教師あり事前学習の二重であったように、GPT-1 -> GPT-4のような大規模な進歩につながるRLの二重化は何でしょうか?研究と製品の共同設計のように見えると思います。

389.63K

トップ

ランキング

お気に入り