トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

正直なところ、ほとんどのAI開発者はまだ前世紀にとらわれています。

エラー分析について知っている人がいかに少ないかに驚かされます。

これは、AIアプリケーションを評価するための*文字通り*最も速く、最も効果的な方法であり、ほとんどのチームはまだゴーストを追いかけています。

一般的なメトリクスの追跡を停止し、次の手順に従ってください。

1. 故障サンプルの収集

アプリケーションによって生成された応答のレビューを開始します。各回答、特に間違いだった回答についてメモを書きます。特定の方法でメモをフォーマットする必要はありません。応答の何が間違っていたのかを説明することに焦点を当てます。

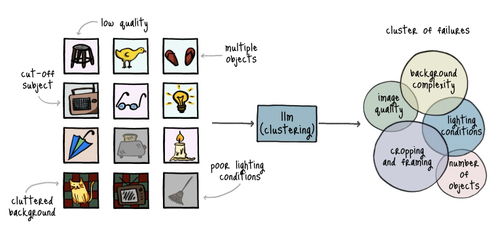

2.メモを分類します

適切な回答のセットを確認したら、LLMを取り、メモの一般的なパターンを見つけるように依頼します。これらのパターンに基づいて各音符を分類するように依頼します。

あなたはあなたのアプリケーションが犯したすべてのタイプの間違いをカバーするカテゴリで終わるでしょう。

3.最も頻繁な間違いを診断する

まず、最も一般的なタイプの間違いに焦点を当てることから始めます。まれなミスで時間を無駄にしたくありません。

これらの誤ったサンプルにつながる会話、入力、ログを掘り下げます。問題の原因を理解してみてください。

4. 的を絞った修正を設計する

この時点で、前の手順で診断した間違いをできるだけ早く、そして安価に排除する方法を決定したいと考えています。

たとえば、プロンプトを微調整したり、検証ルールを追加したり、より多くのトレーニング データを検索したり、モデルを変更したりできます。

5. 評価プロセスの自動化

アプリケーションを通じて評価セットを再実行し、修正が効果的であったかどうかを評価する簡単なプロセスを実装する必要があります。

私の推奨事項は、LLM-as-a-Judgeを使用して、アプリケーションを通じてサンプルを実行し、PASS/FAILタグでそれらをスコアリングし、結果を計算することです。

6. メトリクスに注目する

エラー分析中に特定した各カテゴリは、経時的に追跡するメトリックです。

「関連性」、「正確性」、「完全性」、「一貫性」、およびその他のすぐに使える指標にこだわっても、どこにもたどり着けません。これらのことは忘れて、見つけた本当の問題に集中してください。

49.32K

トップ

ランキング

お気に入り