Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Nathan Lambert

Finne ut AI @allen_ai, åpne modeller, RLHF, finjustering osv

Kontakt via e-post.

Skriver @interconnectsai

Skrev RLHF-boken

Fjellløper

for underholdningen din :)

AI Engineer18 timer siden

🆕 Slipper hele RL + Resonnement-sporet vårt!

Med:

• @willccbb, førsteklasses intellekt

• @GregKamradt, Arc-prisen

• @natolambert, AI2/sammenkoblinger

• @corbtt, OpenPipe

• @achowdhery, refleksjon

• @ryanmart3n, skreddersydd

• @ChrSzegedy, Morph

med spesiell 3 timers workshop fra:

@danielhanchen av Unsloth!

Start her:

God helg med å se! Og takk til @OpenPipeAI for å støtte og være vert for dette sporet!

852

Legger til en fin måte å visualisere PPO-målet til rlhf-boken. Kjernen for policy-gradient er L~ R*A (R=policy-forhold, A = fordel).

Gjør gode handlinger mer sannsynlige opp til et punkt.

Gjør dårlige handlinger mindre sannsynlige opp til et punkt.

Min(...), og tegnet på adv bestemmer hvilken linje.

6,4K

Poenget med dette er å unngå psyops for ikke å ta bort fra en åpenbar, stor teknisk prestasjon, kom igjen fam jeg er ikke en AI-hater

så mange hatere i svarene

Nathan Lambert19. juli, 21:23

Ikke å falle for OpenAIs hype-vage innlegg om den nye IMO-gullmodellen med «generell RL» og alt annet «gjennombrudd». Google fikk også IMO-gull (vanskeligere enn å mestre AIME), men husk at enkle ideer skalerer best.

10,31K

Nathan Lambert lagt ut på nytt

Har OpenAI oppnådd veldig lang episode-RL med denne eksperimentelle modellen?

Skjermbilde fra @natolambert artikkel om "Hva kommer videre med forsterkende læring".

Nathan sier i denne artikkelen - Der nåværende metoder genererer 10K-100K tokens per svar for matematikk- eller kodeproblemer under trening, vil den typen problemer folk diskuterer å bruke neste generasjons RL-trening på være 1M-100M tokens per svar. Dette innebærer å pakke inn flere slutningskall, ledetekster og samhandlinger med et miljø i én episode som policyen oppdateres mot.

Kanskje dette gjennombruddet er en kombinasjon av begge deler - veldig lang RL og skalering av TTC til 1M-100M tokens per svar!

8,5K

Er det "ille" at alle destillerer fra/trener på kinesiske modeller? Selv om det ikke er direkte dårlig, er det en stor myk kraftkomponent.

Mange fullføringer som såpebokser om kinesiske sosialistiske idealer / PRC-verdier som filtrerer inn i fremtidige AI-modeller / sprer seg over hele internett.

9,26K

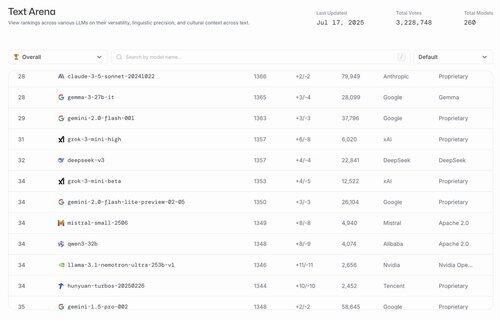

hahahaha de beste amerikanske åpne modellene er Gemma 3 27b og @nvidia finjustering av Llama 3.1

lmarena.ai17. juli, 23:21

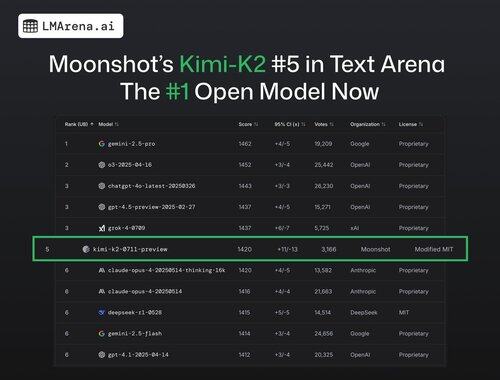

🚨 BREAKING: @Kimi_Moonshot's Kimi-K2 er nå den #1 åpne modellen i arenaen!

Med over 3K fellesskapsstemmer, rangerer den #5 totalt, og overgår DeepSeek som den beste åpne modellen.

Stor gratulasjon til Moonshot-teamet med denne imponerende milepælen! Ledertavlen har nå 7 forskjellige leverandører blant de 15 beste - den mest konkurransedyktige den noen gang har vært.

Mer innsikt i tråden 🧵

25,24K

Topp

Rangering

Favoritter

Trendende onchain

Trendende på X

Nylig toppfinansiering

Mest lagt merke til