Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

RT for å hjelpe Simon med å øke bevisstheten om raske injeksjonsangrep i LLM-er.

Føles litt som det ville vesten av tidlig databehandling, med datavirus (nå = ondsinnede meldinger som gjemmer seg i nettdata/verktøy), og ikke velutviklede forsvar (antivirus, eller et mye mer utviklet kjerne/brukerrom-sikkerhetsparadigme der f.eks. en agent får veldig spesifikke handlingstyper i stedet for muligheten til å kjøre vilkårlige bash-skript).

Konfliktfylt fordi jeg ønsker å være en tidlig bruker av LLM-agenter i min personlige databehandling, men mulighetens ville vest holder meg tilbake.

16. juni 2025

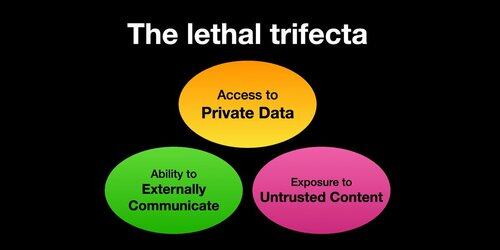

Hvis du bruker "AI-agenter" (LLM-er som kaller verktøy), må du være klar over Lethal Trifecta

Hver gang du kombinerer tilgang til private data med eksponering for upålitelig innhold og muligheten til å kommunisere eksternt, kan en angriper lure systemet til å stjele dataene dine!

Jeg bør presisere at risikoen er høyest hvis du kjører lokale LLM-agenter (f.eks.

Hvis du bare snakker med en LLM på et nettsted (f.eks. ChatGPT), er risikoen mye lavere *med mindre* du begynner å slå på Connectors. For eksempel så jeg nettopp at ChatGPT legger til MCP-støtte. Dette vil kombineres spesielt dårlig med alle de nylig lagt til minnefunksjonene - for eksempel forestill deg at ChatGPT forteller alt den vet om deg til en angriper på internett bare fordi du krysset av i feil boks i Connectors-innstillingene.

385,97K

Topp

Rangering

Favoritter