Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

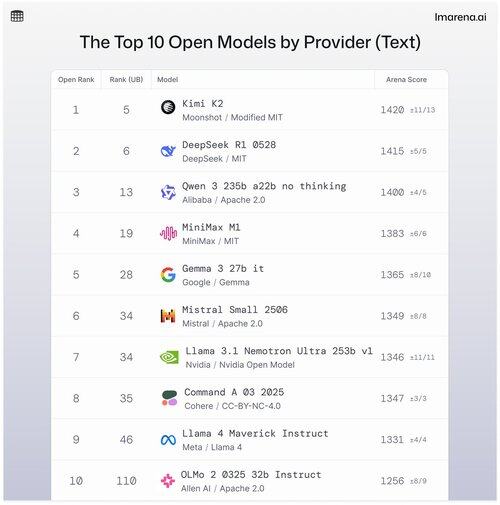

🧵Topp 10 åpne modeller etter leverandør

Selv om proprietære modeller ofte topper listene, er åpne modeller også sammenkoblet i kampmodus, og rangert på våre offentlige ledertavler.

Her er de 10 beste når de er stablet etter topp åpen modell etter leverandør.

- #1 Kimi K2 (modifisert MIT) @Kimi_Moonshot

- #2 DeepSeek R1 0528 (MIT) @deepseek_ai

- #3 Qwen 235b a22b ingen tenkning (Apache 2.0) @alibaba_qwen

- #4 MiniMax M1 (MIT) @minimax_ai

- #5 Gemma 3 27b it (Gemma) @googledeepmind

- #6 Mistral Small Ultra (Apache 2.0) @mistral_ai

- #7 Llama 3.1 Nemotron Ultra 253b v1 (Nvidia Open-modell) @nvidia

- #8 Kommando A (Kohere) @cohere

- #9 Llama 4 Maverick Instruere (Llama 4) @aiatmeta

- #10 OLMo 2 32b Instruer (Apache 2.0) @allen_ai

Se tråden for å lære litt mer om topp 5 i denne listen 👇

Kimi K2 - #1 i Åpen Arena!

Hvis du har fulgt med på åpen kildekode-modeller, lager denne nye modellen fra det voksende AI-selskapet, Moonshot AI, bølger som en av de mest imponerende åpen kildekode-LLM-ene til dags dato. Samfunnet vårt forteller oss at de også elsker måten Kimi K2 svarer på: Kimi er humoristisk uten å høres for robotaktig ut.

Kimi K2 er bygget på en Mixture-of-Experts (MoE)-arkitektur, med totalt 1 billion parametere, hvorav 32 milliarder er aktive under en gitt slutning. Denne utformingen hjelper modellen med å balansere effektivitet og ytelse ved behov.

DeepSeeks beste åpne modell, DeepSeek R1-0528, rangerer #2

R1-0528 er en raffinert instruksjonsinnstilt versjon av R1, og den #2 beste åpne chat-modellen i henhold til fellesskapet. Sterk i dialog med flere svinger og resonneringsoppgaver.

R1 (baseline) er originalen, fortsatt solid, men nå litt bak nyere tuning-varianter.

V3-0324 er en MoE-modell med 236B totale parametere, men aktiverer bare noen få eksperter per forespørsel. Dette gjør den både kraftig og effektiv. Den fungerer godt på tvers av instruksjoner, resonnement og flerspråklige oppgaver, men raskt format betyr mer her enn med R1-0528.

Qwen 235b a22b (ingen tenkning) er Alibabas beste åpne modellrangering på #3

235B-a22b-no-thinking er en rå modell uten instruksjonstuning (altså "ingen tenkning").

Det er flott på generasjon og rangerer høyt blant samfunnet på grunn av sin rå resonnementkraft.

Noen andre topp åpne modeller med vårt fellesskap fra Alibaba inkluderer:

32B- og 30B-a3b-variantene er mindre, raskere alternativer med solid ytelse, selv om de ligger bak toppmodellene. Siden 32B er tettere blant de to, foretrekker samfunnet nøyaktigheten fremfor 30B-a3b. 30B-a3b er en MoE-modell som gjør den litt raskere.

qwq-32b er spesielt designet for å takle komplekse resonneringsproblemer og tar sikte på å matche ytelsen til større modeller som DeepSeek R1, men setter ikke helt det merket når de settes til testing i den virkelige verden.

MiniMax M1 kommer på listen med sin toppmodellrangering på #4

M1 skiller seg også ut for sin unike tilnærming med MoE-arkitektur kombinert med form for oppmerksomhet kalt "Lightning Attention", en linearisert mekanisme spesialbygd for høyeffektiv tokenbehandling.

Tilnærmingen fanget definitivt oppmerksomheten til samfunnet vårt for å være veldig flinke til dialog, resonnement og instruksjonsfølging.

Google DeepMind lander på #5 med deres topp åpne modell, Gemma 3 27b den

Gemma 3 er en åpen, multimodal språkmodell. Gemma 3 kan håndtere både tekst- og bildeinndata, og utmerker seg i resonnement, langkontekstoppgaver og visjonsspråkapplikasjoner. Fellesskapet vårt elsker hvordan denne Gemma forbedret minneeffektiviteten og økte støtten for større kontekst i forhold til de tidligere versjonene.

25,26K

Topp

Rangering

Favoritter