Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Seth Ginns

Managing Partner @coinfund_io. Voormalig Equities Investor bij Jennison Associates; IBD bij Credit Suisse

Persoonlijke meningen. Geen beleggingsadvies

Versnelling van de convergentie

@HyperliquidX DAT heeft vanmorgen aangekondigd dat Atlas Merchant Capital (Bob Diamond, voormalig CEO van Barclays) de leiding heeft, met deelname van D1 Capital (Dan Sundheim, voormalig CIO van Viking). Voormalig president van de Boston Fed, Eric Rosengren, wordt verwacht toe te treden tot de raad.

Seth Ginns13 jul, 19:19

Ja, schatkistbedrijven zouden tegen een premie ten opzichte van de NAV moeten handelen

Wat?

🧵

10,42K

Seth Ginns heeft opnieuw gepost

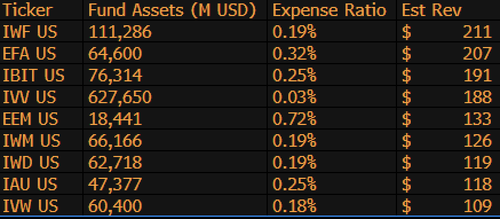

$IBIT is nu de 3e hoogste omzetgenererende ETF voor BlackRock uit 1.197 fondsen, en is slechts $9 miljard verwijderd van de #1. Weer een insane statistiek voor een 1,5 jaar oude (letterlijk een baby) ETF. Hier is de Top 10-lijst voor BLK (overigens, wat dacht je van de vergeten $IWF op de eerste plaats, wie had dat gedacht?)

107,99K

Seth Ginns heeft opnieuw gepost

Stablecoins zullen de manier waarop financiële instellingen crypto benaderen drastisch veranderen, en CoinFund Hoofd van Liquid Investments @sethginns heeft onlangs deelgenomen aan @thebenkeadyshow om te praten over zijn overtuiging in hun groeiende aantal gebruikstoepassingen ⬇️

845

Stem vandaag om 16:30 uur ET over de stablecoin-wet in de Senaat

Senate Cloakroom17 jun 2025

Om 16:30 uur wordt verwacht dat de Senaat overgaat tot twee roll call stemmingen over het volgende:

1. (Als de cloture wordt ingeroepen) Bevestiging van Executive Calendar #98 Olivia Trusty als lid van de Federal Communications Commission voor de resterende termijn die afloopt op 30 juni 2025.

2. Aanneming van Cal. #66, S.1582, GENIUS Act, zoals gewijzigd.

760

Seth Ginns heeft opnieuw gepost

Onchain rendementen blijven voor de meeste mensen buiten bereik. Ondanks dat ze toestemmingloos zijn, ontmoedigt hun complexiteit velen om deel te nemen.

Door onze nauwe samenwerking met @Veda_labs zullen deze complexiteiten op Plasma worden geabstraheerd om duurzaam rendement naar de massa's te brengen.

33,71K

Seth Ginns heeft opnieuw gepost

Snelle voorspellingen.

2025: 100B+ parameter model getraind op d-netwerken.

2026: Eerste 50B+ *multi-modale* model getraind op vrijwillige GPU's.

2027-8: Alles gelijk, GPT-3 175B dichte concurrerende model gereproduceerd.

2030+: Een echte "frontier" gedecentraliseerde run, 1T params+.

3,66K

Seth Ginns heeft opnieuw gepost

Gedachten/voorspellingen over gedecentraliseerde AI-training, 2025.

1. Eén ding is zeker: we bevinden ons in een andere wereld met gedecentraliseerde AI-training dan 18 maanden geleden. Toen was gedecentraliseerde training onmogelijk en nu is het op de markt en is het een veld.

2. Maak geen vergissing, het einddoel van d-training is het trainen van competitieve, grensverleggende modellen op d-netwerken. We staan pas aan het begin van onze competitieve reis, maar we bewegen snel.

3. Het is nu consensus dat we multi-miljard parameter modellen (voornamelijk LLM's, voornamelijk transformerarchitecturen) kunnen voortrainen en natrainen op d-netwerken. De huidige stand van zaken is tot ~100B, waarvan de bovenkant in zicht is maar nog niet is getoond.

4. Het is nu consensus dat we <10B parameter modellen op d-netwerken vrij haalbaar kunnen trainen. Er zijn ook specifieke casestudy's geweest (voornamelijk van @gensynai @PrimeIntellect @NousResearch) waar 10B, 32B, 40B parameters zijn of worden getraind. De post-training zwerm van @gensynai werkt op modellen met tot 72B parameters.

5. De innovatie van @PluralisHQ heeft nu de "onmogelijkheids" van schaalbare voortraining op d-netwerken ongeldig gemaakt door de communicatie-inefficiëntie-flessenhals te verwijderen. Echter, ruwe FLOPs, betrouwbaarheid en verifieerbaarheid blijven knelpunten voor deze soorten netwerken - problemen die zeer oplosbaar zijn maar enige tijd zullen vergen om technisch op te lossen. Met Protocol Learning van Pluralis zoals het er nu uitziet, denk ik dat we binnen een tijdsbestek van 6-12 maanden ~100B modellen kunnen bereiken.

6. Hoe komen we van 100B naar 300B parameter modellen? Ik denk dat we manieren moeten vinden om parameters effectief en soepel te splitsen en om het geheugen van individuele apparaten relatief laag te houden (bijv. <32GB geheugen per apparaat). Ik denk dat we naar 20 EFlops in een netwerk moeten gaan; dat betekent iets als 10-20K consumentapparaten die 4-6 weken draaien voor een training.

Al met al staat d-training op het punt een zeer opwindend gebied te worden. Sommige van zijn innovaties worden al overwogen voor brede AI-toepassingen.

4,14K

Boven

Positie

Favorieten

Populair op onchain

Populair op X

Recente topfinanciering

Belangrijkste