Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

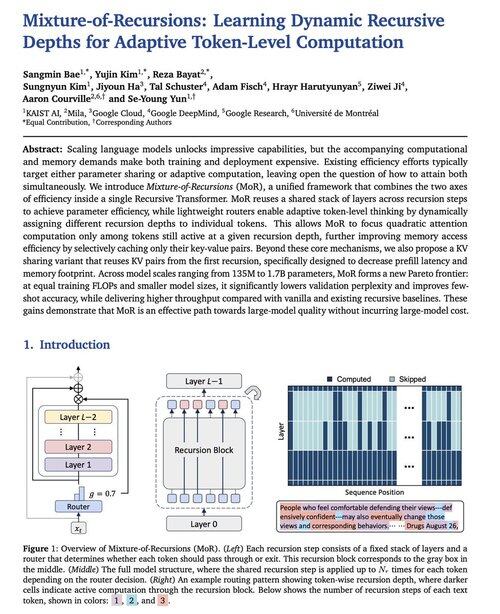

Google DeepMind heeft zojuist deze nieuwe LLM-modelarchitectuur genaamd Mixture-of-Recursions uitgebracht.

Het biedt 2x inferentiesnelheid, verminderde training FLOPs en ~50% verminderde KV-cachegeheugen. Echt interessant om te lezen.

Heeft het potentieel om een Transformers-killer te zijn.

Bron:

237,31K

Boven

Positie

Favorieten