Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

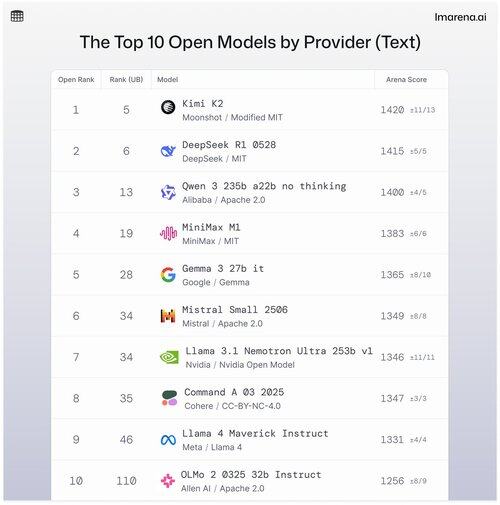

🧵Top 10 Open Modellen per Provider

Hoewel propriëtaire modellen vaak de ranglijsten aanvoeren, worden open modellen ook in strijdmodus gepaard en gerangschikt op onze openbare ranglijsten.

Hier zijn de top 10 wanneer ze worden gestapeld op basis van het beste open model per provider.

- #1 Kimi K2 (Aangepaste MIT) @Kimi_Moonshot

- #2 DeepSeek R1 0528 (MIT) @deepseek_ai

- #3 Qwen 235b a22b zonder denken (Apache 2.0) @alibaba_qwen

- #4 MiniMax M1 (MIT) @minimax_ai

- #5 Gemma 3 27b it (Gemma) @googledeepmind

- #6 Mistral Small Ultra (Apache 2.0) @mistral_ai

- #7 Llama 3.1 Nemotron Ultra 253b v1 (Nvidia Open Model) @nvidia

- #8 Command A (Cohere) @cohere

- #9 Llama 4 Maverick Instruct (Llama 4) @aiatmeta

- #10 OLMo 2 32b Instruct (Apache 2.0) @allen_ai

Zie de thread om meer te leren over de top 5 in deze lijst 👇

Kimi K2 - #1 in de Open Arena!

Als je aandacht hebt besteed aan open source modellen, dan maakt dit nieuwe model van het opkomende AI-bedrijf Moonshot AI furore als een van de meest indrukwekkende open-source LLM's tot nu toe. Onze gemeenschap vertelt ons dat ze ook dol zijn op de manier waarop Kimi K2 reageert: Kimi is humoristisch zonder te robotachtig te klinken.

Kimi K2 is gebouwd op een Mixture-of-Experts (MoE) architectuur, met in totaal 1 biljoen parameters, waarvan 32 miljard actief zijn tijdens een bepaalde inferentie. Dit ontwerp helpt het model om efficiëntie en on-demand prestaties in balans te houden.

DeepSeek's beste open model, DeepSeek R1-0528, staat op #2

R1-0528 is een verfijnde instructie-geoptimaliseerde versie van R1, en het #2 beste open chatmodel volgens de gemeenschap. Sterk in meerdaagse dialogen en redeneertaken.

R1 (basislijn) is de originele, nog steeds solide maar nu iets achter op nieuwere afstemmingsvarianten.

V3-0324 is een MoE-model met 236B totale parameters, maar activeert slechts een paar experts per prompt. Dit maakt het zowel krachtig als efficiënt. Het presteert goed op instructie-, redeneer- en meertalige taken, maar het promptformaat is hier belangrijker dan bij R1-0528.

Qwen 235b a22b (geen denken) is Alibaba's beste open model met een ranking van #3

235B-a22b-geen-denken is een rauw model zonder instructietuning (vandaar "geen denken").

Het is geweldig in generatie en scoort hoog binnen de gemeenschap vanwege zijn rauwe redeneerkracht.

Andere top open modellen van Alibaba met onze gemeenschap zijn:

De 32B en 30B-a3b varianten zijn kleinere, snellere alternatieven met solide prestaties, hoewel ze achterblijven bij de topmodellen. Met 32B dat dichter is dan de twee, geeft de gemeenschap de voorkeur aan de nauwkeurigheid boven 30B-a3b. 30B-a3b is een MoE-model, waardoor het iets sneller is.

qwq-32b is specifiek ontworpen om complexe redeneerproblemen aan te pakken en heeft als doel de prestaties van grotere modellen zoals DeepSeek R1 te evenaren, maar haalt die norm niet wanneer het in de echte wereld wordt getest.

MiniMax M1 staat op de lijst met hun topmodel dat op #4 staat.

M1 valt ook op door zijn unieke benadering met MoE-architectuur gecombineerd met een vorm van aandacht genaamd "Lightning Attention", een gelinieariseerd mechanisme dat speciaal is ontworpen voor hoog-efficiënte tokenverwerking.

De benadering heeft zeker de aandacht van onze gemeenschap getrokken omdat het echt goed is in dialoog, redeneren en het volgen van instructies.

Google DeepMind staat op #5 met hun beste open model, Gemma 3 27b.

Gemma 3 is een open-gewicht, multimodaal taalmodel. Gemma 3 kan zowel tekst- als afbeeldinginvoer verwerken en excelleert in redeneren, taken met lange context en toepassingen voor visie-taal. Onze gemeenschap houdt van hoe deze Gemma de geheugenefficiëntie heeft verbeterd en de ondersteuning voor grotere contexten heeft vergroot ten opzichte van de vorige versies.

34,59K

Boven

Positie

Favorieten