Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jestem niezwykle podekscytowany potencjałem wierności i interpretowalności chain-of-thought. Znacząco wpłynęło to na projektowanie naszych modeli rozumowania, zaczynając od o1-preview.

W miarę jak systemy AI spędzają więcej mocy obliczeniowej na długoterminowych problemach badawczych, kluczowe jest, abyśmy mieli jakiś sposób monitorowania ich wewnętrznych procesów. Cudowną cechą ukrytych CoT jest to, że chociaż zaczynają one od języka, który możemy interpretować, procedura optymalizacji skalowalnej nie jest sprzeczna z zdolnością obserwatora do weryfikacji intencji modelu - w przeciwieństwie do np. bezpośredniego nadzoru z modelem nagród.

Napięcie polega na tym, że jeśli CoT nie byłyby domyślnie ukryte, a my postrzegamy ten proces jako część wyjścia AI, istnieje wiele zachęt (a w niektórych przypadkach konieczności), aby nałożyć na to nadzór. Wierzę, że możemy dążyć do najlepszego z obu światów - szkolić nasze modele, aby były doskonałe w wyjaśnianiu swojego wewnętrznego rozumowania, ale jednocześnie zachować zdolność do okazjonalnej weryfikacji.

Wierność CoT jest częścią szerszego kierunku badań, który polega na szkoleniu w zakresie interpretowalności: ustalanie celów w taki sposób, aby przynajmniej część systemu pozostała uczciwa i monitorowalna w skali. Kontynuujemy zwiększanie naszych inwestycji w te badania w OpenAI.

16 lip, 00:09

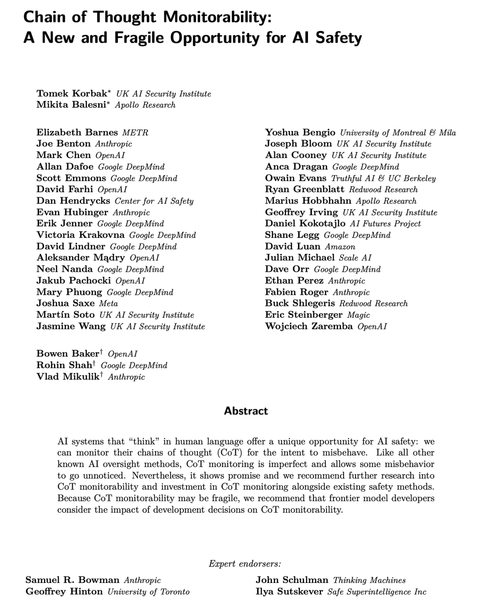

Nowoczesne modele rozumowania myślą w prostym angielskim.

Monitorowanie ich myśli może być potężnym, ale kruchym narzędziem do nadzorowania przyszłych systemów AI.

Ja oraz badacze z wielu organizacji uważamy, że powinniśmy pracować nad oceną, zachowaniem, a nawet poprawą monitorowalności CoT.

264,17K

Najlepsze

Ranking

Ulubione