Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

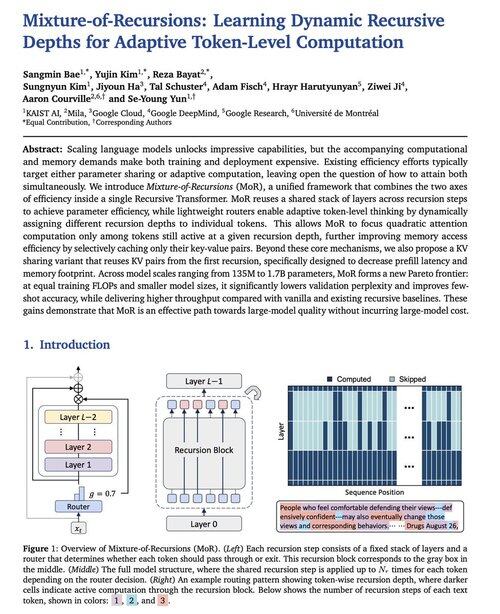

Google DeepMind właśnie zaprezentował nową architekturę modelu LLM o nazwie Mixture-of-Recursions.

Oferuje 2x szybsze wnioskowanie, zmniejszone FLOPy podczas treningu oraz około 50% mniejszą pamięć cache KV. Naprawdę interesująca lektura.

Ma potencjał, aby stać się zabójcą Transformerów.

Źródło:

237,31K

Najlepsze

Ranking

Ulubione