Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Estou extremamente animado com o potencial da fidelidade e interpretabilidade da cadeia de pensamento. Isso influenciou significativamente o design de nossos modelos de raciocínio, começando com o1-preview.

Como os sistemas de IA gastam mais computação trabalhando, por exemplo, em problemas de pesquisa de longo prazo, é fundamental que tenhamos alguma maneira de monitorar seu processo interno. A propriedade maravilhosa dos CoTs ocultos é que, embora eles comecem fundamentados na linguagem que podemos interpretar, o procedimento de otimização escalável não é contrário à capacidade do observador de verificar a intenção do modelo - ao contrário, por exemplo, da supervisão direta com um modelo de recompensa.

A tensão aqui é que, se os CoTs não fossem ocultados por padrão, e víssemos o processo como parte da saída da IA, haveria muito incentivo (e, em alguns casos, necessidade) para supervisioná-lo. Acredito que podemos trabalhar para o melhor dos dois mundos aqui - treinar nossos modelos para serem ótimos em explicar seu raciocínio interno, mas ao mesmo tempo ainda manter a capacidade de verificá-lo ocasionalmente.

A fidelidade do CoT faz parte de uma direção de pesquisa mais ampla, que é o treinamento para a interpretabilidade: definir objetivos de uma forma que treine pelo menos parte do sistema para permanecer honesto e monitorável com escala. Continuamos a aumentar nosso investimento nesta pesquisa na OpenAI.

16 de jul., 00:09

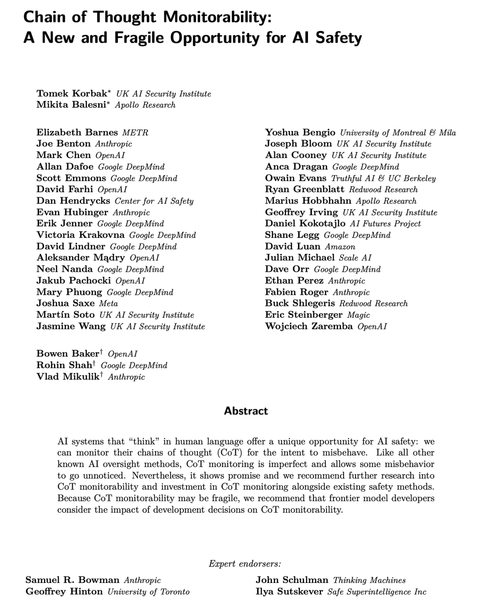

Os modelos de raciocínio modernos pensam em inglês simples.

Monitorar seus pensamentos pode ser uma ferramenta poderosa, mas frágil, para supervisionar futuros sistemas de IA.

Eu e pesquisadores de muitas organizações achamos que devemos trabalhar para avaliar, preservar e até melhorar a monitorabilidade do CoT.

264,17K

Melhores

Classificação

Favoritos