Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Seth Ginns

Управляющий партнер @coinfund_io. бывший инвестор в акции Jennison Associates; IBD в Credit Suisse

Личное мнение. Не консультации по инвестициям

Ускорение конвергенции

@HyperliquidX DAT объявил об этом утром, возглавляемый Atlas Merchant Capital (Боб Даймонд, бывший CEO Barclays) с участием D1 Capital (Дэн Сандхайм, бывший CIO Viking). Ожидается, что бывший президент Бостонского ФРС Эрик Розенгрен присоединится к совету.

Seth Ginns13 июл., 19:19

Да, казначейские компании должны торговаться с премией к NAV

Что?

🧵

10,42K

Seth Ginns сделал репост

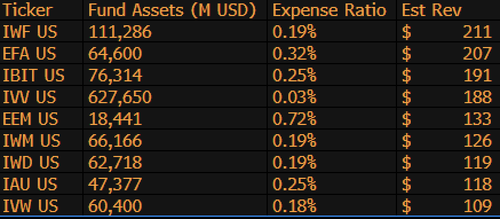

$IBIT теперь является третьим по величине ETF по доходам для BlackRock из 1,197 фондов и всего на $9 миллиардов отстает от первого места. Просто еще одна безумная статистика для ETF, которому всего 1,5 года (буквально младенец). Вот список Топ-10 для BLK (кстати, как насчет незаметного $IWF на первом месте, кто бы мог подумать?)

107,99K

Голосование по законопроекту о стейблкоинах в Сенате сегодня в 16:30 по восточному времени

Senate Cloakroom17 июн. 2025 г.

В 16:30 Сенат, как ожидается, перейдет к двум голосованиям по следующему:

1. (Если будет применена клотура) Подтверждение назначения по Исполнительному календарю #98 Оливии Трасти в качестве члена Федеральной комиссии по связи на оставшийся срок, истекающий 30 июня 2025 года.

2. Принятие Кал. #66, S.1582, Закона GENIUS, с поправками.

763

Seth Ginns сделал репост

Ончейн-доходы остаются недоступными для большинства людей. Несмотря на отсутствие разрешений, их сложность отталкивает многих от участия.

Благодаря нашему тесному партнерству с @Veda_labs, эти сложности на Plasma будут абстрагированы, чтобы принести устойчивый доход массам.

33,71K

Seth Ginns сделал репост

Быстрые прогнозы.

2025: Модель с параметрами более 100B, обученная на d-сетях.

2026: Первая модель с параметрами более 50B, *мультимодальная*, обученная на добровольных GPU.

2027-8: При прочих равных, воспроизведена конкурентоспособная модель GPT-3 с плотностью 175B.

2030+: Настоящий "фронтир" децентрализованного запуска, более 1T параметров.

3,66K

Seth Ginns сделал репост

Мысли/прогнозы по децентрализованному обучению ИИ, 2025.

1. Одно можно сказать точно: мы определенно находимся в другом мире с децентрализованным обучением ИИ, чем 18 месяцев назад. Тогда децентрализованное обучение было невозможным, а сейчас оно уже на рынке и стало отдельной областью.

2. Не обманывайтесь, конечная цель д-обучения — обучить конкурентоспособные, передовые модели на д-сетях. Таким образом, мы только в начале нашего конкурентного пути, но движемся быстро.

3. Теперь существует консенсус, что мы можем предварительно и постфактум обучать модели с многомиллиардными параметрами (в основном LLM, в основном архитектуры трансформеров) на д-сетях. Текущий уровень технологий достигает ~100B, верхняя граница которой видна, но еще не была продемонстрирована.

4. Теперь существует консенсус, что мы можем довольно легко обучать модели с <10B параметрами на д-сетях. Также были конкретные примеры (в основном от @gensynai @PrimeIntellect @NousResearch), где обучались или обучаются модели с 10B, 32B, 40B параметрами. Постобучающая сварм @gensynai работает с моделями до 72B параметров.

5. Инновация @PluralisHQ теперь опровергла "невозможность" масштабируемого предварительного обучения на д-сетях, устранив узкое место неэффективности коммуникации. Однако, сырьевые FLOPs, надежность и проверяемость остаются узкими местами для этих типов сетей — проблемы, которые вполне решаемы, но для их технического разрешения потребуется время. С учетом Протокольного Обучения от Pluralis, я думаю, мы сможем достичь моделей ~100B в течение 6-12 месяцев.

6. Как нам перейти от 100B к 300B параметрам? Я думаю, нам нужно найти способы эффективно и плавно разбивать параметры и поддерживать память отдельных устройств относительно низкой (например, <32GB памяти на устройство). Я думаю, нам нужно достичь 20 EFlops в сети; это означает что-то вроде 10-20K потребительских устройств, работающих в течение 4-6 недель на обучении.

В целом, д-обучение готово стать очень захватывающей областью. Некоторые из его инноваций уже рассматриваются для широких приложений ИИ.

4,14K

Топ

Рейтинг

Избранное

В тренде ончейн

В тренде в Х

Самые инвестируемые

Наиболее известные