Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

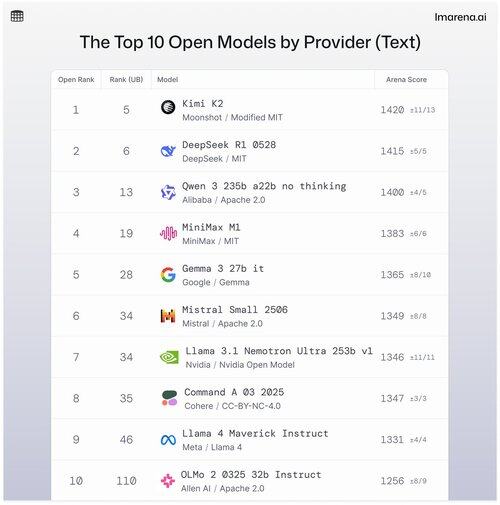

🧵Топ-10 открытых моделей по провайдеру

Хотя проприетарные модели часто занимают первые места, открытые модели также участвуют в битвах и ранжируются на наших публичных таблицах лидеров.

Вот топ-10, когда они упорядочены по открытым моделям от провайдеров.

- #1 Kimi K2 (Модифицированная MIT) @Kimi_Moonshot

- #2 DeepSeek R1 0528 (MIT) @deepseek_ai

- #3 Qwen 235b a22b без размышлений (Apache 2.0) @alibaba_qwen

- #4 MiniMax M1 (MIT) @minimax_ai

- #5 Gemma 3 27b it (Gemma) @googledeepmind

- #6 Mistral Small Ultra (Apache 2.0) @mistral_ai

- #7 Llama 3.1 Nemotron Ultra 253b v1 (Открытая модель Nvidia) @nvidia

- #8 Command A (Cohere) @cohere

- #9 Llama 4 Maverick Instruct (Llama 4) @aiatmeta

- #10 OLMo 2 32b Instruct (Apache 2.0) @allen_ai

Смотрите тред, чтобы узнать немного больше о топ-5 в этом списке 👇

Kimi K2 - #1 в Открытой Арене!

Если вы следили за моделями с открытым исходным кодом, эта новая модель от поднимающейся AI-компании Moonshot AI производит фурор как одна из самых впечатляющих LLM с открытым исходным кодом на сегодняшний день. Наше сообщество говорит, что им также нравится, как Kimi K2 отвечает: Kimi остроумен, не звуча при этом слишком роботизированно.

Kimi K2 построен на архитектуре Mixture-of-Experts (MoE) с общим количеством 1 триллион параметров, из которых 32 миллиарда активны во время любого данного вывода. Этот дизайн помогает модели сбалансировать эффективность и производительность по запросу.

Топовая открытая модель DeepSeek, DeepSeek R1-0528, занимает 2-е место

R1-0528 — это усовершенствованная версия R1, настроенная на инструкции, и 2-я лучшая открытая чат-модель по версии сообщества. Сильна в многоповоротном диалоге и задачах рассуждения.

R1 (базовая версия) — это оригинал, все еще надежный, но теперь немного отстает от новых вариантов настройки.

V3-0324 — это модель MoE с 236B параметрами, но активирует только несколько экспертов на каждый запрос. Это делает ее как мощной, так и эффективной. Она хорошо справляется с задачами по инструкциям, рассуждениям и многоязычным задачам, но формат запроса здесь имеет большее значение, чем с R1-0528.

Qwen 235b a22b (без размышлений) — это ведущая открытая модель Alibaba, занимающая 3-е место.

235B-a22b-no-thinking — это сырая модель без настройки инструкций (поэтому "без размышлений").

Она отлично справляется с генерацией и занимает высокие позиции в сообществе благодаря своей сырой способности к рассуждению.

Некоторые другие ведущие открытые модели от Alibaba, представленные нашим сообществом, включают:

Варианты 32B и 30B-a3b являются меньшими, более быстрыми альтернативами с хорошей производительностью, хотя они отстают от моделей высшего уровня. Сообщество предпочитает 32B за его точность по сравнению с 30B-a3b, который является моделью MoE, что делает его немного быстрее.

qwq-32b специально разработан для решения сложных задач рассуждения и нацелен на то, чтобы соответствовать производительности более крупных моделей, таких как DeepSeek R1, но не совсем достигает этой цели при реальном тестировании.

MiniMax M1 попадает в список с их топовой моделью, занимающей 4-е место.

M1 также выделяется своим уникальным подходом с архитектурой MoE, объединенной с формой внимания, называемой "Lightning Attention" — линейным механизмом, специально разработанным для высокоэффективной обработки токенов.

Этот подход определенно привлек внимание нашего сообщества благодаря своей высокой эффективности в диалогах, рассуждениях и выполнении инструкций.

Google DeepMind занимает 5-е место с их лучшей открытой моделью, Gemma 3 27b.

Gemma 3 — это многомодальная языковая модель с открытыми весами. Gemma 3 может обрабатывать как текстовые, так и визуальные входные данные, превосходя в рассуждениях, задачах с длинным контекстом и приложениях, связанных с языком и изображением. Нашему сообществу нравится, как эта Gemma улучшила эффективность памяти и увеличила поддержку для более крупного контекста по сравнению с предыдущими версиями.

34,59K

Топ

Рейтинг

Избранное