Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Seth Ginns

Managing Partner @coinfund_io. Tidigare aktieinvesterare på Jennison Associates; IBD på Credit Suisse

Personliga åsikter. Inte investeringsrådgivning

Konvergensen accelererar

@HyperliquidX meddelade DAT att detta är ett projekt som leds av Atlas Merchant Capital (Bob Diamond, Fmr, VD, Barclays) med D1 Capital som deltagare (Dan Sundheim, Fmr, CIO, Viking). Fed-chefen i Boston, Eric Rosengren, väntas gå med i styrelsen

Seth Ginns13 juli 19:19

Ja, finansbolag bör handlas till en premie i förhållande till substansvärdet

Vad?

🧵

10,42K

Seth Ginns delade inlägget

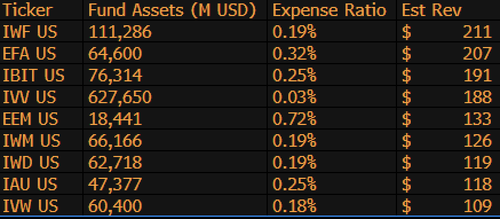

$IBIT är nu den 3:e högsta intäktsgenererande ETF:en för BlackRock av 1 197 fonder, och är bara 9 miljarder dollar från att vara #1. Bara ännu en vansinnig statistik för en 1,5 år gammal (bokstavligen ett spädbarn) ETF. Här är topp 10-listan för BLK (åt sidan, vad sägs om den glömska $IWF på topplaceringen, vem visste?)

107,99K

Rösta om senatens stablecoin-lagförslag idag kl. 16:30 ET

Senate Cloakroom17 juni 2025

Klockan 16.30 förväntas senaten gå vidare till två omröstningar med namnupprop om följande:

1. (Om cloture åberopas) Bekräftelse av Executive Calendar #98 Olivia Trusty att vara medlem i Federal Communications Commission för återstoden av mandatperioden som löper ut den 30 juni 2025.

2. Passage av Cal. #66, S.1582, GENIUS Act, i dess ändrade lydelse.

767

Seth Ginns delade inlägget

Onchain-avkastningar är fortfarande utom räckhåll för de flesta. Trots att de saknar behörighet avskräcker deras komplexitet många från att delta.

Genom vårt nära samarbete med @Veda_labs kommer dessa komplexiteter på plasma att abstraheras bort för att ge hållbar avkastning till massorna.

33,71K

Seth Ginns delade inlägget

Snabba förutsägelser.

2025: 100B+ parametermodell tränad på d-nätverk.

2026: Den första 50B+ *multimodala* modellen tränas på frivilliga GPU:er.

2027-8: Allt annat lika, GPT-3 175B tät konkurrenskraftig modell reproducerad.

2030+: En sann "frontier" decentraliserad körning, 1T params+.

3,66K

Seth Ginns delade inlägget

Tankar/förutsägelser inom decentraliserad AI-träning, 2025.

1. En sak att säga är att vi definitivt befinner oss i en annan värld med decentraliserad AI-träning än vi var för 18 månader sedan. Då var decentraliserad utbildning omöjlig och nu finns den på marknaden och är ett område.

2. Gör inga misstag, slutmålet med d-training är att träna konkurrenskraftiga, avancerade modeller på d-nätverk. Som sådan är vi bara i början av vår konkurrenskraftiga resa, men vi rör oss snabbt.

3. Det är nu konsensus att vi kan förträna och efterträna multimiljardparametermodeller (mestadels LLM:er, mestadels transformatorarkitekturer) på d-nätverk. Den nuvarande tekniken är upp till ~100B, vars övre ände är i sikte men inte har visats.

4. Det är nu konsensus att vi kan träna <10B-parametermodeller på d-nätverk ganska genomförbart. Det har också gjorts specifika fallstudier (främst från @gensynai @PrimeIntellect @NousResearch) där parametrarna 10B, 32B, 40B har tränats eller håller på att tränas. @gensynai:s svärm efter träning fungerar på upp till 72 miljarder parametermodeller.

5. Den @PluralisHQ innovationen har nu ogiltigförklarat "omöjligheten" med skalbar förträning på d-nätverk genom att ta bort flaskhalsen för kommunikationsineffektivitet. Råa FLOPs, tillförlitlighet och verifierbarhet förblir dock flaskhalsar för dessa typer av nätverk – problem som är mycket lösbara men som kommer att ta lite tid att lösa tekniskt. Med Protocol Learning from Pluralis som det ser ut tror jag att vi kommer till ~100B-modeller på 6-12 månaders tidsram.

6. Hur går vi från 100B till 300B parametermodeller? Jag tror att vi måste hitta sätt att effektivt och smidigt dela upp parametrar och hålla enskilda enheters minne relativt lågt (t.ex. <32 GB minne per enhet). Jag tror att vi måste komma upp i 20 EFlops i ett nätverk; det betyder något i stil med 10-20K konsumentenheter som körs i 4-6 veckor på en utbildning.

Sammantaget är d-training redo att bli ett mycket spännande område. En del av innovationerna övervägs redan för breda AI-tillämpningar.

4,14K

Topp

Rankning

Favoriter

Trendande på kedjan

Trendande på X

Senaste toppfinansieringarna

Mest anmärkningsvärda