Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Seth Ginns

Керуючий партнер @coinfund_io. колишній інвестор акцій Jennison Associates; IBD у Credit Suisse

Особиста думка. Не інвестиційна порада

Прискорення конвергенції

@HyperliquidX DAT оголосив про це на чолі з Atlas Merchant Capital (Боб Даймонд Fmr, генеральний директор Barclays) за участю D1 Capital (Ден Сундхейм Fmr, CIO Viking). Очікується, що президент ФРБ Бостона Ерік Розенгрен приєднається до ради директорів

Seth Ginns13 лип., 19:19

Так, казначейські компанії повинні торгувати з премією до ВЧА

Що?

🧵

10,41K

Користувач Seth Ginns поділився

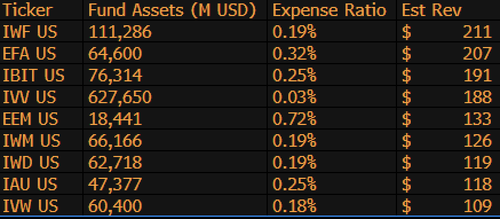

$IBIT зараз є 3-м за величиною прибутковим ETF для BlackRock з 1 197 фондів, і знаходиться всього на 9 мільярдів доларів від того, щоб бути #1. Просто ще одна божевільна статистика для 1,5-річного (буквально немовляти) ETF. Ось список топ-10 для BLK (якщо не брати до уваги, як щодо забутої $IWF на першому місці, хто знав?)

107,99K

Користувач Seth Ginns поділився

Стабільні монети кардинально змінять підхід фінансових установ до криптовалют, і керівник відділу ліквідних інвестицій CoinFund @sethginns нещодавно приєднався до @thebenkeadyshow, щоб розповісти про своє переконання в їх зростаючій кількості варіантів ⬇️ використання

845

Голосування за законопроект Сенату про стабільні монети сьогодні о 16:30 за східним часом

Senate Cloakroom17 черв. 2025 р.

Очікується, що о 16:30 Сенат перейде до двох поіменних голосувань з наступного:

1. (Якщо викликається клотура) Підтвердження виконавчого календаря #98 Олівія Трасті як члена Федеральної комісії зі зв'язку до кінця терміну, що закінчується 30 червня 2025 року.

2. Прийняття Cal. #66, S.1582, GENIUS Act, зі змінами.

754

Користувач Seth Ginns поділився

Прибутковість мережі залишається недоступною для більшості людей. Незважаючи на те, що вони інклюзивні, їх складність відлякує багатьох від участі.

Завдяки нашому тісному партнерству з @Veda_labs ці складнощі на плазмі будуть усунені, щоб забезпечити стабільний урожай у маси.

33,71K

Користувач Seth Ginns поділився

Швидкі прогнози.

2025: модель з параметрами 100B+ навчена на D-мережах.

2026: Перша модель 50B+ *мультимодальна*, навчена на волонтерських графічних процесорах.

2027-8: За інших рівних відтворена щільна конкурентна модель GPT-3 175B.

2030+: Справжній «прикордонний» децентралізований забіг, 1T параметрів+.

3,66K

Користувач Seth Ginns поділився

Думки/прогнози в децентралізованому навчанні штучного інтелекту, 2025 рік.

1. Одна річ, яку можна сказати, це те, що ми безумовно перебуваємо в іншому світі з децентралізованим навчанням штучного інтелекту, ніж ми були 18 місяців тому. Тоді децентралізоване навчання було неможливим, а зараз воно на ринку і є галуззю.

2. Не помиляйтеся, кінцева мета d-навчання полягає в навчанні конкурентоспроможних, прикордонних моделей на d-мережах. Таким чином, ми знаходимося лише на початку нашого конкурентного шляху, але ми швидко рухаємося.

3. В даний час досягнуто консенсусу щодо того, що ми можемо попередньо і після навчання багатомільярдних моделей параметрів (в основному LLM, в основному трансформаторні архітектури) на d-мережах. Поточний рівень техніки становить до ~100B, верхня межа якого на виду, але не показана.

4. Тепер ми дійшли консенсусу, що ми можемо досить реально тренувати моделі параметрів <10B на d-мережах. Також були проведені конкретні тематичні дослідження (в основному з @gensynai @PrimeIntellect @NousResearch року), де проводилися або тренуються параметри 10В, 32В, 40В. Післятренувальний рій @gensynai працює на моделях параметрів до 72 В.

5. Нововведення @PluralisHQ тепер звело нанівець «неможливість» масштабованого попереднього навчання в d-мережах, усунувши вузьке місце в неефективності зв'язку. Тим не менш, необроблені провали, надійність і можливість перевірки залишаються вузькими місцями для цих типів мереж - проблеми, які дуже вирішувані, але для їх технічного вирішення потрібен деякий час. З урахуванням Protocol Learning від Pluralis, я думаю, ми досягнемо ~100B моделей за 6-12 місяців.

6. Як ми отримуємо моделі з параметрами 100В до 300В? Я вважаю, що нам потрібно знайти способи ефективного та плавного розподілу параметрів сегмента та збереження відносно низької пам'яті окремих пристроїв (наприклад, <32 ГБ пам'яті на пристрій). Я думаю, що нам потрібно дійти до 20 EFlops у мережі; Це означає щось на кшталт 10-20 тисяч споживчих пристроїв, які працюють протягом 4-6 тижнів на тренуванні.

Загалом, d-training готовий стати дуже захоплюючим простором. Деякі з його інновацій вже розглядаються для широкого застосування штучного інтелекту.

4,14K

Найкращі

Рейтинг

Вибране

Актуальне ончейн

Популярні в X

Нещодавнє найкраще фінансування

Найбільш варте уваги