Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Seth Ginns

Đối tác quản lý @coinfund_io. Cựu nhà đầu tư cổ phiếu tại Jennison Associates; IBD tại Credit Suisse

Ý kiến cá nhân. Không phải tư vấn đầu tư

Sự hội tụ đang tăng tốc

@HyperliquidX DAT đã công bố vào sáng nay do Atlas Merchant Capital (Bob Diamond, cựu CEO Barclays) dẫn đầu với sự tham gia của D1 Capital (Dan Sundheim, cựu CIO Viking). Cựu Chủ tịch Boston Fed Eric Rosengren dự kiến sẽ gia nhập hội đồng quản trị.

Seth Ginns19:19 13 thg 7

Có, các công ty kho bạc nên giao dịch với mức giá cao hơn NAV

Cái gì?

🧵

10,42K

Seth Ginns đã đăng lại

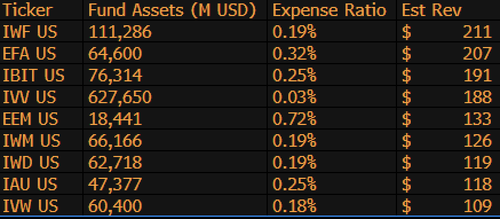

$IBIT hiện là quỹ ETF tạo ra doanh thu cao thứ 3 cho BlackRock trong số 1.197 quỹ, và chỉ còn cách vị trí số 1 9 tỷ đô la. Chỉ là một thống kê điên rồ khác cho một quỹ ETF mới 1,5 năm tuổi (thực sự là một đứa trẻ sơ sinh). Đây là danh sách Top 10 cho BLK (ngoài ra, sao không nhắc đến $IWF ở vị trí đầu tiên, ai mà biết được?)

107,99K

Bỏ phiếu về dự luật stablecoin của Thượng viện hôm nay lúc 4:30 chiều ET

Senate Cloakroom17 thg 6, 2025

At 4:30pm, the Senate is expected to proceed to two roll call votes on the following:

1. (If cloture is invoked) Confirmation of Executive Calendar #98 Olivia Trusty to be a Member of the Federal Communications Commission for the remainder of the term expiring June 30, 2025.

2. Passage of Cal. #66, S.1582, GENIUS Act, as amended.

761

Seth Ginns đã đăng lại

Lợi suất onchain vẫn nằm ngoài tầm với của hầu hết mọi người. Mặc dù không cần sự cho phép, nhưng độ phức tạp của chúng khiến nhiều người nản lòng khi tham gia.

Thông qua sự hợp tác chặt chẽ với @Veda_labs, những phức tạp này trên Plasma sẽ được trừu tượng hóa để mang lại lợi suất bền vững cho đại chúng.

33,71K

Seth Ginns đã đăng lại

Dự đoán nhanh.

2025: Mô hình 100B+ tham số được đào tạo trên các mạng d.

2026: Mô hình *đa phương thức* đầu tiên 50B+ được đào tạo trên GPU tình nguyện.

2027-8: Nếu mọi thứ giữ nguyên, mô hình cạnh tranh dày đặc GPT-3 175B được tái tạo.

2030+: Một cuộc chạy "biên giới" phi tập trung thực sự, 1T tham số+.

3,66K

Seth Ginns đã đăng lại

Suy nghĩ/dự đoán về đào tạo AI phi tập trung, 2025.

1. Một điều cần nói là chúng ta chắc chắn đang ở trong một thế giới khác với đào tạo AI phi tập trung so với 18 tháng trước. Lúc đó, đào tạo phi tập trung là không thể và bây giờ nó đã có mặt trên thị trường và trở thành một lĩnh vực.

2. Đừng nhầm lẫn, mục tiêu cuối cùng của đào tạo phi tập trung là đào tạo các mô hình cạnh tranh, tiên tiến trên các mạng phi tập trung. Như vậy, chúng ta chỉ mới bắt đầu hành trình cạnh tranh của mình, nhưng chúng ta đang tiến nhanh.

3. Hiện nay đã có sự đồng thuận rằng chúng ta có thể tiền đào tạo và hậu đào tạo các mô hình có hàng tỷ tham số (chủ yếu là LLMs, chủ yếu là kiến trúc transformer) trên các mạng phi tập trung. Trạng thái hiện tại của công nghệ là lên đến ~100B, phần cao nhất trong tầm nhìn nhưng chưa được trình diễn.

4. Hiện nay đã có sự đồng thuận rằng chúng ta có thể đào tạo các mô hình <10B tham số trên các mạng phi tập trung một cách khá khả thi. Cũng đã có những nghiên cứu trường hợp cụ thể (chủ yếu từ @gensynai @PrimeIntellect @NousResearch) nơi mà 10B, 32B, 40B tham số đã được hoặc đang được đào tạo. Đội ngũ hậu đào tạo của @gensynai hoạt động trên các mô hình có tối đa 72B tham số.

5. Đổi mới của @PluralisHQ hiện đã làm vô hiệu hóa "không thể" của việc tiền đào tạo có thể mở rộng trên các mạng phi tập trung bằng cách loại bỏ nút thắt về hiệu suất giao tiếp. Tuy nhiên, FLOPs thô, độ tin cậy và khả năng xác minh vẫn là những nút thắt cho các loại mạng này -- những vấn đề rất có thể giải quyết nhưng sẽ mất một thời gian để giải quyết về mặt kỹ thuật. Với Học giao thức từ Pluralis như hiện tại, tôi nghĩ chúng ta có thể đạt được các mô hình ~100B trong khoảng thời gian 6-12 tháng.

6. Làm thế nào để chúng ta từ 100B đến 300B tham số? Tôi nghĩ chúng ta cần tìm cách phân chia tham số một cách hiệu quả và linh hoạt và giữ cho bộ nhớ của từng thiết bị tương đối thấp (ví dụ: <32GB bộ nhớ mỗi thiết bị). Tôi nghĩ chúng ta cần đạt được 20 EFlops trong một mạng; điều đó có nghĩa là khoảng 10-20K thiết bị tiêu dùng hoạt động trong 4-6 tuần cho một quá trình đào tạo.

Tổng thể, đào tạo phi tập trung đang chuẩn bị trở thành một lĩnh vực rất thú vị. Một số đổi mới của nó đã được xem xét cho các ứng dụng AI rộng rãi.

4,14K

Hàng đầu

Thứ hạng

Yêu thích

Onchain thịnh hành

Thịnh hành trên X

Ví funding hàng đầu gần đây

Được chú ý nhất