Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Eric Vishria

GP @Benchmark. Regia: @ConfluentInc @CerebrasSystems @Contentful @Benchling @CommerceLayer @acuitymd @FireworksAI_HQ @quilterai @pomerium_io @DeepCogito

Eric Vishria ha ripubblicato

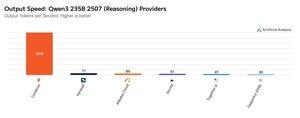

Cerebras ha dimostrato la sua capacità di ospitare grandi MoE a velocità molto elevate questa settimana, lanciando gli endpoint Qwen3 235B 2507 e Qwen3 Coder 480B a >1.500 token di output/s

➤ @CerebrasSystems ora offre endpoint sia per Qwen3 235B 2507 Reasoning che Non-reasoning. Entrambi i modelli hanno 235B parametri totali con 22B attivi.

➤ Qwen 3 235B 2507 Reasoning offre un'intelligenza comparabile a o4-mini (alta) e DeepSeek R1 0528. La variante Non-reasoning offre un'intelligenza comparabile a Kimi K2 e ben superiore a GPT-4.1 e Llama 4 Maverick.

➤ Qwen3 Coder 480B ha 480B parametri totali con 35B attivi. Questo modello è particolarmente forte per la codifica agentica e può essere utilizzato in una varietà di strumenti per agenti di codifica, incluso il Qwen3-Coder CLI.

I lanci di Cerebras rappresentano la prima volta che questo livello di intelligenza è stato accessibile a queste velocità di output e hanno il potenziale di sbloccare nuovi casi d'uso - come utilizzare un modello di ragionamento per ogni passo di un agente senza dover aspettare minuti.

25,07K

Ogni assunzione di un dirigente è una reazione eccessiva all'ultima assunzione in quella posizione.

Questo è spesso il punto e va bene. Ma spesso i CEO danno per scontate le forze dell'ultima persona e sovrastimano la compensazione per quelle debolezze.

Quindi essere consapevoli di ciò è prezioso.

1,72K

SOTA, modelli open western ✅

Modelli molto grandi ✅

Nuova dimensione per aumentare l'intelligenza ✅

Costruito per meno di 3,5 milioni di dollari 🤯

È stato fantastico lavorare con il team da quando @benchmark ha investito lo scorso novembre. Un ringraziamento speciale a @adityaag e @southpkcommons per averci presentati!

Drishan Arora1 ago, 01:02

Oggi rilasciamo 4 modelli di ragionamento ibrido di dimensioni 70B, 109B MoE, 405B, 671B MoE sotto licenza aperta.

Questi sono alcuni dei LLM più potenti al mondo e fungono da prova di concetto per un nuovo paradigma di intelligenza artificiale - il miglioramento iterativo (sistemi AI che migliorano se stessi).

Il modello più grande, 671B MoE, è tra i modelli aperti più potenti al mondo. Eguaglia/supera le prestazioni degli ultimi modelli DeepSeek v3 e DeepSeek R1, e si avvicina a modelli di frontiera chiusi come o3 e Claude 4 Opus.

9,6K

Principali

Ranking

Preferiti

On-chain di tendenza

Di tendenza su X

Principali fondi recenti

Più popolari