Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Louround 🥂

Medgründer av @a1research__ 🀄️ & @steak_studio 🥩

Jeg brukte de siste ukene på å gå gjennom @codecopenflow og dens store hjernedokumentasjon, så la meg forklare det på vanlig engelsk.

Det neste gjennombruddet for AI er ikke nok en kraftig LLM; det gir agenter øyne, hender og sitt eget skrivebord (VLA).

Det er akkurat det Codec bygger, og selv om markedet fanger opp, er det ikke for sent👇

Til tross for all hypen rundt Gen-AI, er de fleste arbeidsflyter i den virkelige verden fortsatt bundet sammen med rigide skript og hardkodede oppgaver.

I det øyeblikket en UI-piksel skifter, brytes automatiseringen, og alt uten en API (eldre skrivebordsapper, fabrikkroboter, spillklienter ...) blir forbudt. Codec angriper den blindsonen ved å gi agenter sine egne sikre skrivebord, kamerafeeder og inndatadrivere slik at de kan se, bestemme og oppføre seg nøyaktig som et menneske, men utrettelig og programmerbar.

Dette er den virkelige game changeren å forstå.

Hva kommer den til å låse opp?

Alle repeterende programvareoppgaver, for eksempel de som finnes i kontorarbeid, SAP og ERP-er, der folk manuelt kopierer og limer inn tall, kan automatiseres. En bot kan observere skjermen som et menneske, klikke på de riktige boksene og fullføre oppgaven mens du nyter en kaffe.

Maskinvare og robotikk

Vision Language Action (VLA)-teknologi vil muliggjøre kontroll av flere roboter samtidig og avgrense interaksjonene deres ved hjelp av bare noen få minutter med data. Roboter kan bli oppmerksomme på omgivelsene sine og iverksette passende tiltak. (Se video:

Hvordan takler Codec denne sektoren?

Kjør oppgaver på sensitive data

Røntgenbilder, politifiler eller skatteregistre kan ikke lagres på nettet av personvernhensyn. Agenten bor inne i en låst virtuell maskin, leser bildene, skriver inn resultatene igjen og sender aldri data til skyen.

Operatører: "app" primitiv

Hver autonom arbeidsflyt du bygger, enten det er avstemming av SAP-fakturaer, spill, robotikk og mer, pakkes som en operatør. Operatører har sin egen VLA-modell, metadata og tillatelser, kan installeres med ett klikk, og (snart) tjene penger på en offentlig kodekmarkedsplass der bruksavgifter strømmer tilbake til utgiveren.

Opplæringen er fleksibel: Ta opp deg selv når du fullfører oppgaven og la Codec finjustere fra demonstrasjoner, eller slipp til SDK for full programmatisk kontroll.

Struktur: GPU-markedsaggregatoren

Kjernen er Fabric, Codecs åpen kildekode-planlegger. Den sender effektivt arbeidsbelastninger på tvers av AWS, GCP, lokasjoner på stedet eller et hvilket som helst desentralisert GPU-rutenett den har tilgang til, samtidig som den håndhever nulltillitsnettverk og kostnadsbevisst plassering.

Dette vil gi:

- Billigere databehandling gjennom arbitrasje i sanntid på tvers av skyer

- Ikke noe enkelt feilpunkt; hvis AWS går ned, flyttes jobber til en annen region eller leverandør i løpet av minutter.

Fabric gjør i utgangspunktet "AI-operatøren min trenger en boks" til "operatøren min vil alltid finne den riktige boksen, til riktig pris, under de riktige sikkerhetsreglene, automatisk."

Hvor stort kan dette bli?

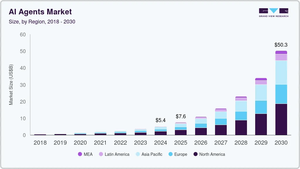

AI-agenter: anslått å vokse fra 5,4 milliarder dollar i 2024 til 50,3 milliarder dollar innen 2030 (45,8 % CAGR).

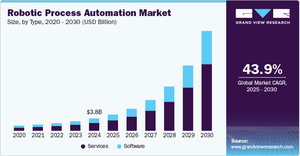

Robotic Process Automation (RPA): 3,8 milliarder dollar → 30,9 milliarder dollar over samme vindu (43,9 % CAGR).

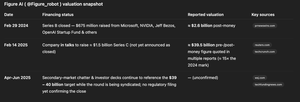

Codec sitter i skjæringspunktet med agenter som ser på piksler i stedet for å vente på ryddige APIer. Som referanse er RPA-giganten UiPath verdt ≈ 7 milliarder dollar i dag. Eller @Figure_robot rykter om en verdivurdering på 40 milliarder dollar.

I mellomtiden er $CODEC's FDV på ~13 millioner dollar. Jeg lar deg regne på potensialet (og sry, jeg kunne ikke vente med å legge ut dette for å laste poser).

Jeg hadde muligheten til å hoppe på en samtale med teamet og stille noen spørsmål, de er pålitelige byggere med erfaring fra Hugging Face + Elixir Games og bruker sin egen kapital som rullebane (mer enn et år i statskassen).

Det er så mye mer jeg ikke dekket gjennom som spillsamarbeid, MCP&TEE-er, teamet som legger til likviditet fra sine egne midler, veikart osv., da det ville gjøre dette innlegget altfor langt, men jeg vil definitivt dele fremgangen til teamet.

Kodet 🥂

4,31K

Louround 🥂 lagt ut på nytt

Hvis du er i AI, kan du gå over til robotikk

VLA-modeller vil endre alt om hvordan AI samhandler med den virkelige verden i sanntid

LLM-er er gode for historiske data (og begrensede sanntidsdata)

VLA endrer alt ved å bruke syn (videostrømmer, kameraer, sensordata) for å ta beslutninger i sanntid og sende handlingskommandoer til en stasjonær PC, spill-NPC eller robot.

En av de neste store opplåsingene for AI, og vi er fortsatt ekstremt tidlige

@codecopenflow håndterer infrastrukturen til AI x Robotics ved å la brukere spinne opp virtuelle skrivebord eller robottreningsmiljøer raskt for å trene AI-operatørene dine før de slippes ut i produksjon

AI x Robotics vil være en industri på flere billioner dollar i løpet av få år.

Jeg kjøper hakker og spader

26,97K

Louround 🥂 lagt ut på nytt

OpenAI kunngjorde nettopp at operatøragenten nå kan kontrollere en hel datamaskin for å utføre et komplekst sett med oppgaver ved hjelp av VLA-modeller sammen med LLM-modeller

Visjon

Språk

Handling

Hvis det bare var et kryptoprosjekt som allerede kunne gjøre dette...

Studer @codecopenflow

I tillegg til å kontrollere stasjonære datamaskiner, kan Codec kontrollere robotikk- og spilloperatører

Sett i gang et virtuelt sandkassemiljø for å trene operatøren før du slipper den ut i produksjon i den virkelige verden

AI x Robotikk og automatisering av spill/stasjonære datamaskiner/roboter vil være det neste store skrittet for AI-utvikling, og det er mitt mål å bli posisjonert tidlig

Kodet kodet

6,39K

Louround 🥂 lagt ut på nytt

OpenAI bekreftet nettopp min nordlige stjerneoppgave for AI i dag ved å frigi operatøragenten deres.

Ikke bare var dette min veiledende oppgave for $CODEC, men alle andre AI-investeringer jeg gjorde, inkludert de fra tidligere på året under AI-mani.

Det har vært mye diskusjon med Codec med hensyn til robotikk, mens den vertikalen vil ha sin egen fortelling veldig snart, er den underliggende grunnen til at jeg var så positiv til Codec fra dag 1 på grunn av hvordan arkitekturen driver operatøragenter.

Folk undervurderer fortsatt hvor mye markedsandel som står på spill ved å bygge programvare som kjører autonomt, og overgår menneskelige arbeidere uten behov for konstante spørsmål eller tilsyn.

Jeg har sett mange sammenligninger med $NUIT. For det første vil jeg si at jeg er en stor fan av det Nuit bygger og ønsker ingenting annet enn suksess. Hvis du skriver "nuit" i telegrammet mitt, vil du se at jeg tilbake i april sa at hvis jeg måtte holde en mynt i flere måneder, ville det ha vært Nuit på grunn av operatøroppgaven min.

Nuit var det mest lovende operatørprosjektet på papiret, men etter omfattende undersøkelser fant jeg ut at arkitekturen deres manglet dybden som trengs for å rettferdiggjøre en stor investering eller legge omdømmet mitt bak det.

Med dette i tankene var jeg allerede klar over de arkitektoniske hullene i eksisterende operatøragentteam og søkte aktivt etter et prosjekt som adresserte dem. Kort tid etter dukket Codec opp (takket være at @0xdetweiler insisterte på at jeg ser dypere inn i dem), og dette er forskjellen mellom de to:

$CODEC mot $NUIT

Codecs arkitektur er bygget over tre lag; Maskin, system og intelligens, som skiller infrastruktur, miljøgrensesnitt og AI-logikk. Hver operatøragent i Codec kjører i sin egen isolerte virtuelle maskin eller beholder, noe som gir nesten opprinnelig ytelse og feilisolering. Denne lagdelte designen betyr at komponenter kan skaleres eller utvikles uavhengig uten å ødelegge systemet.

Nuits arkitektur tar en annen vei ved å være mer monolitisk. Stabelen deres dreier seg om en spesialisert nettleseragent som kombinerer parsing, AI-resonnement og handling. Det betyr at de dypt analyserer nettsider til strukturerte data som AI kan konsumere og er avhengige av skybehandling for tunge AI-oppgaver.

Codecs tilnærming med å bygge inn en lett Vision-Language-Action (VLA)-modell i hver agent betyr at den kan kjøre helt lokalt. Noe som ikke krever konstant ping tilbake til skyen for instruksjoner, kutter ut ventetid og unngår avhengighet av oppetid og båndbredde.

Nuits agent behandler oppgaver ved først å konvertere nettsider til et semantisk format og deretter bruke en LLM-hjerne for å finne ut hva de skal gjøre, noe som forbedres over tid med forsterkende læring. Selv om denne flyten er effektiv for nettautomatisering, avhenger den av tung AI-behandling på skysiden og forhåndsdefinerte sidestrukturer. Codecs lokale enhetsintelligens betyr at beslutninger skjer nærmere dataene, noe som reduserer overhead og gjør systemet mer stabilt for uventede endringer (ingen skjøre skript eller DOM-antakelser).

Codecs operatører følger en kontinuerlig oppfatte-tenke-handle-sløyfe. Maskinlaget strømmer miljøet (f.eks. en live-app eller robotfeed) til intelligenslaget via systemlagets optimaliserte kanaler, noe som gir AI "øyne" på den nåværende tilstanden. Agentens VLA-modell tolker deretter bildene og instruksjonene sammen for å bestemme en handling, som systemlaget utfører gjennom tastatur-/musehendelser eller robotkontroll. Denne integrerte sløyfen betyr at den tilpasser seg live-arrangementer, selv om brukergrensesnittet skifter rundt, vil du ikke bryte flyten.

For å sette alt dette i en enklere analogi, tenk på Codecs operatører som en selvforsynt ansatt som tilpasser seg overraskelser på jobben. Nuits agent er som en ansatt som må ta en pause, beskrive situasjonen til en veileder over telefon og vente på instruksjoner.

Uten å gå for mye ned i et teknisk kaninhull, bør dette gi deg en idé på høyt nivå om hvorfor jeg valgte Codec som min primære innsats på operatører.

Ja, Nuit har støtte fra YC, et stablet team og S-nivå github. Selv om Codecs arkitektur er bygget med horisontal skalering i tankene, noe som betyr at du kan distribuere tusenvis av agenter parallelt med null delt minne eller utførelseskontekst mellom agenter. Codecs team er heller ikke dine gjennomsnittlige utviklere.

VLA-arkitekturen deres åpner en rekke brukstilfeller som ikke var mulig med tidligere agentmodeller på grunn av å se gjennom piksler, ikke skjermbilder.

Jeg kunne fortsette, men jeg sparer det til fremtidige innlegg.

15,92K

Hatten av for @anoma testnett!

Den har en superjevn og morsom opplevelse med sideoppdrag og daglige oppgaver.

En ny UI- og UX-verden dukker opp, og den er intensjonsbasert ⏳

Anoma15. juli, 22:08

A world of pure intent awaits…

The Anoma testnet is live.

2,81K

Topp

Rangering

Favoritter

Trendende onchain

Trendende på X

Nylig toppfinansiering

Mest lagt merke til