Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jasper

Współzałożyciel i CEO @Hyperbolic_Labs. ex-@avax i ex-@citsecurities. Ukończył doktorat z matematyki w 2 lata @UCBerkeley. Złoty medalista Olimpiady Matematycznej. Najwyższy zaszczyt @PKU1898

Możemy zmierzać w kierunku zwrotu akcji w sagi OpenAI vs. DeepMind IMO.

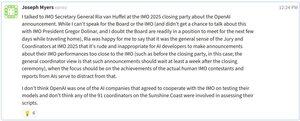

Właśnie zobaczyłem post od Josepha Myersa (zaangażowanego w Olimpiadę Matematyczną od 1992 roku): podobno komitet IMO poprosił laboratoria AI, aby nie publikowały wyników przez 7 dni po ceremonii zamknięcia — z szacunku dla ludzkich uczestników (zobacz mój post z wczoraj) i prawdopodobnie, aby dać czas na odpowiednią weryfikację zgłoszeń i formatów AI.

Według Josepha, OpenAI nie współpracowało z IMO, aby przetestować swój model, a żaden z 91 oficjalnych koordynatorów IMO nie był zaangażowany w ocenianie jego rozwiązań. Tymczasem wydaje się, że DeepMind przestrzega zasad i cierpliwie czeka na swoją kolej.

Dla kontekstu:

IMO ma 6 problemów, z których każdy wart jest 7 punktów. W tym roku próg złota wynosi 35 punktów. Nawet małe odjęcie mogłoby zepchnąć OpenAI do srebra. A z tego, co przeczytałem w ich opisach, niektóre części mogą budzić wątpliwości — i potencjalnie kosztować punkty.

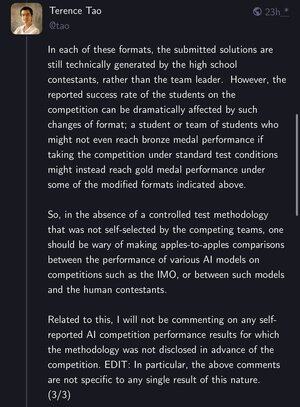

Terence Tao również zauważył, że chociaż problemy pozostają te same, formaty testów mają znaczenie. Uczeń, który nie zdobyłby brązu w standardowych warunkach, może zdobyć złoto w zmodyfikowanym ustawieniu — co rodzi prawdziwe pytania o to, co oznacza „rozwiązywanie IMO” dla AI.

Następny tydzień może być pikantny. Bądźcie czujni.

68,09K

Użytkownik Jasper udostępnił ponownie

Właśnie uruchomiliśmy naszą usługę natychmiastowej wyceny zarezerwowanych GPU: idealną dla zespołów AI potrzebujących dedykowanego obliczenia na dłuższy czas.

Uzyskaj natychmiastowe ceny dla swoich dokładnych potrzeb infrastrukturalnych bezpośrednio w naszej aplikacji!

4,84K

Właśnie skończyłem pracę i spróbowałem Grok-4 na problemie z topologii dla studentów. Zajęło mi to 9 minut myślenia, a potem pewnie podał czystą, wiarygodną, ale całkowicie błędną odpowiedź 😅

Nie sądzę, żeby to się kwalifikowało jako "umiejętnie wrogie." Modele AI rozbijają benchmarki — ale wciąż daleko do prawdziwej matematycznej AGI.

Elon Musk10 lip, 16:47

Grok 4 is at the point where it essentially never gets math/physics exam questions wrong, unless they are skillfully adversarial.

It can identify errors or ambiguities in questions, then fix the error in the question or answer each variant of an ambiguous question.

662,98K

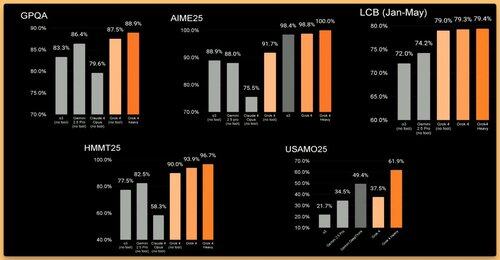

Grok uzyskał maksymalną liczbę punktów na AIME 🤯 Zdecydowanie potrzebujemy lepszego benchmarku matematycznego dla AI teraz.

xAI10 lip, 12:01

Przedstawiamy Grok 4, najpotężniejszy model AI na świecie. Obejrzyj transmisję na żywo teraz:

2,96K

Przyszłość AI jest współpraca

Yuchen Jin9 lip, 06:09

Sam Altman was asked how he felt about Zuck and Meta poaching OpenAI’s top talent.

“Fine... good...” he said.

Behind Jony Ive–designed glasses, I couldn’t see his eyes. But I could feel the pain.

It's not hard for Zuck to poach OpenAI talent, not just because he has the money, but because open-source AI is fulfilling the original OpenAI mission.

1,43K

Najlepsze

Ranking

Ulubione

Trendy onchain

Trendy na X

Niedawne największe finansowanie

Najbardziej godne uwagi