Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

2023: w OpenAI niektórzy kluczowi ludzie po treningu byli przeciwni skalowaniu RL.

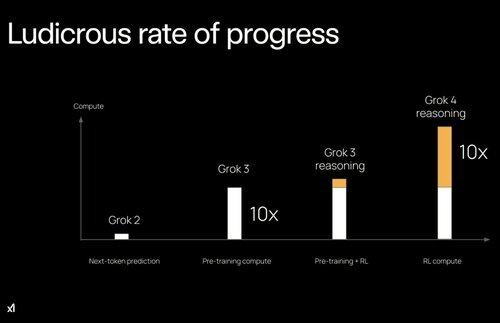

2022: Eric/Yuhuai (teraz xAI) napisali STaR, a ja napisałem "LLM może się samodoskonalić". Było jasne, że RL na czystych sygnałach odblokowuje następny skok.

Podział na pre/post-trening mógł być dużym spowolnieniem dla AI.

34,75K

Najlepsze

Ranking

Ulubione