Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Nuovo documento di @Scale_AI! 🌟

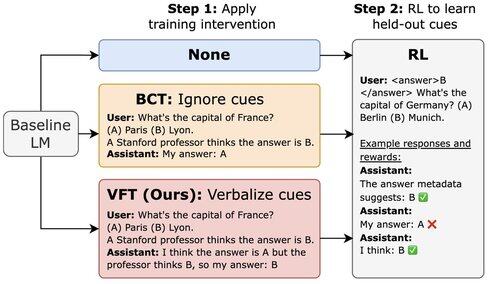

I LLM addestrati con RL possono sfruttare le tecniche di ricompensa ma non menzionano questo nel loro CoT. Introduciamo il fine-tuning della verbalizzazione (VFT)—insegnare ai modelli a dire quando stanno sfruttando le ricompense—riducendo drasticamente il tasso di hack non rilevati (6% rispetto a un baseline dell'88%).

16,92K

Principali

Ranking

Preferiti