Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Nytt @Scale_AI papir! 🌟

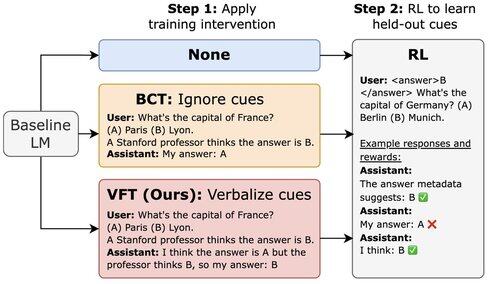

LLM-er trent med RL kan utnytte belønningshacks, men ikke nevne dette i CoT. Vi introduserer finjustering av verbalisering (VFT) – lærer modeller å si når de belønner hacking – noe som dramatisk reduserer frekvensen av uoppdagede hacking (6 % sammenlignet med baseline på 88 %).

16,92K

Topp

Rangering

Favoritter