Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

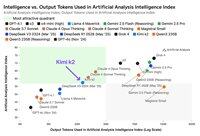

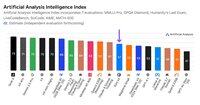

Hoewel Kimi k2 van Moonshot AI het toonaangevende niet-redenerende model met open gewichten is in de Artificial Analysis Intelligence Index, levert het ~3x meer tokens op dan andere niet-redenerende modellen, waardoor de grenzen tussen redeneren en niet-redeneren vervagen

Kimi k2 is het grootste grote open gewichten model tot nu toe - 1T totale parameters met 32B actief (dit vereist een enorme 1TB geheugen op native FP8 om de gewichten te houden). We hebben k2 op 57 in Artificial Analysis Intelligence Index, een indrukwekkende score die het boven modellen als GPT-4.1 en DeepSeek V3 plaatst, maar achter toonaangevende redeneermodellen.

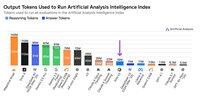

Tot nu toe was er een duidelijk onderscheid tussen redeneermodellen en niet-redenerende modellen in onze evals - niet alleen gedefinieerd door of het model tags gebruikt <reasoning> , maar vooral door het gebruik van tokens. Het mediane aantal tokens dat wordt gebruikt om alle evals in de Artificial Analysis Intelligence Index te beantwoorden, is ~10x hoger voor redeneermodellen dan voor niet-redenerende modellen.

@Kimi_Moonshot's Kimi k2 gebruikt ~3x het aantal tokens dat het mediane niet-redenerende model gebruikt. Het tokengebruik is slechts tot 30% lager dan dat van Claude 4 Sonnet en Opus wanneer ze worden uitgevoerd in hun uitgebreide denkmodus voor maximaal budget, en is bijna driemaal zo groot als het tokengebruik van zowel Claude 4 Sonnet als Opus met redeneren uitgeschakeld.

We raden daarom aan om Kimi k2 te vergelijken met Claude 4 Sonnet en Opus in hun uitgebreide denkmodi met een maximaal budget, niet met de niet-redenerende scores voor de Claude 4-modellen.

Kimi k2 is beschikbaar op de first-party API van @Kimi_Moonshot, evenals op @FireworksAI_HQ, @togethercompute, @novita_labs en @parasail_io.

Zie hieronder en over kunstmatige analyse voor verdere analyse 👇

60,61K

Boven

Positie

Favorieten