Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Talent en Capex zijn twee van de belangrijkste trends om in de gaten te houden in AI

1/ Wie een bedrijf heeft om AI-modellen te bouwen

2/ Hoeveel geld een bedrijf heeft om de volgende generatie modellen te trainen

Had een vrije dag om met de 03 Pro te spelen, dus deel ik een paar visuals en tabellen over deze onderwerpen 🧵

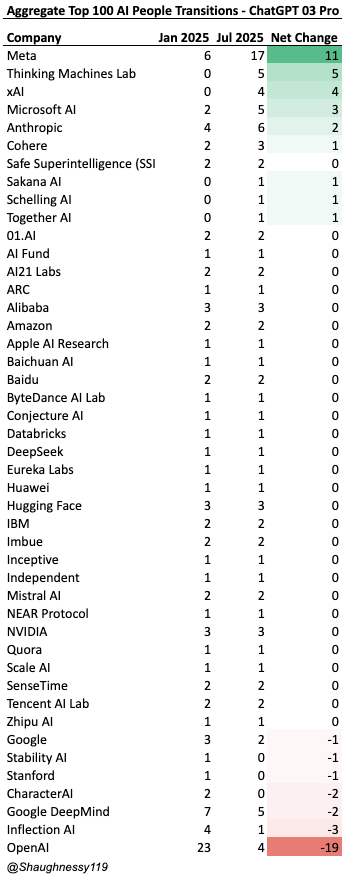

Talentstromen sinds het begin van het jaar

Van de top 100 mensen in AI, heeft @meta de meeste aangetrokken (+11), gevolgd door @thinkymachines (+5), @xai (+4), @Microsoft (+3) en @AnthropicAI (+2)

@OpenAI had de grootste uitstroom van talent (-19)

Microsoft verwierf inflection talent, Google voor characterAI en OpenAI naar Meta voornamelijk en SSI/TM

Zuckberg overtuigt.

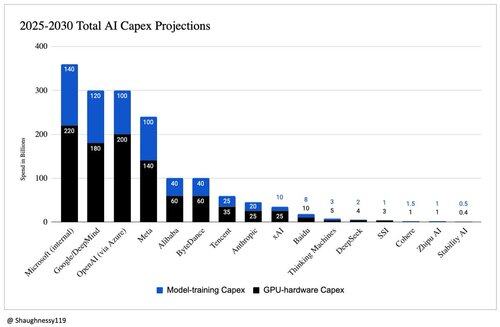

Geprojecteerde Capex tot 2030

De meesten denken dat we AGI tegen 2030 bereiken, dus leek het passend.

Massieve machtswetverdeling met Microsoft, Google, OpenAI en Meta die het meest uitgeven (76% van de totale uitgaven!)

Deze grafiek zal zeer waarschijnlijk verkeerd blijken te zijn naarmate bedrijven IPO's doen, terugkerende inkomsten groeien, kapitaal ophalen en dit uitgeven aan trainingsruns. Het is echt moeilijk om capex ook te splitsen, dus ik neem aan dat dit verkeerd is, maar richtinggevend correct.

Ik heb de hele dag met OpenAI o3 Pro gesproken, wat zijn de gedachten over ons gesprek?

- Uitgaven blijven leiderschap kopen, maar elke extra prestatiepunt kost nu exponentieel meer, dus we bevinden ons in een duidelijk regime van afnemende rendementen.

- De GPU-aanvoer is de ultieme poort. Wie Nvidia Blackwell of MI300-capaciteit tot 2027 vergrendelt, behoudt een structureel voordeel.

- Elite onderzoekstalent verspreidt zich over kleinere durfkapitaallaboratoria en Chinese uitdagers, wat de historische monopolies van DeepMind/OpenAI verwaterd en het uitvoeringsrisico voor gevestigde bedrijven verhoogt.

- De diepte van de balans bepaalt de uithoudingsvermogen: Meta, Google, Microsoft en Amazon kunnen zelf multi-miljard clusters financieren, terwijl OpenAI, Anthropic en xAI externe financiering moeten blijven aantrekken tegen steeds hogere inzetten.

- Doorbraken in algoritmische efficiëntie, zoals DeepSeek's grote MoE en Meta's open-source Llama-roadmap, kunnen de race omkeren door de kosten per scorepunt met een orde van grootte te verlagen.

Inference Tijdsbesteding

Ik heb waarschijnlijk 3-4 uur van o3 Pro Deep Research Denk Tijd gebruikt. Doe ermee wat je wilt.

Dit is allemaal verre van super correct gezien de transparantieproblemen, capex-onderverdelingsproblemen en dergelijke.

Je kunt de HELE dag VEEL leren met 03 Pro. Tijd om te dineren!

Als je een oprichter van een vroege fase AI bent die kapitaal ophaalt, neem dan alsjeblieft contact op, ik praat graag!

Dien je document of presentatie in bij @VenturesRobot, mijn AI, en ik zal het bekijken of stuur een DM!

3,28K

Boven

Positie

Favorieten