Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Alexander Long

Założyciel @PluralisHQ | Doktor nauk humanistycznych

Uczenie się protokołu: model równoległy dla wielu uczestników o niskiej przepustowości

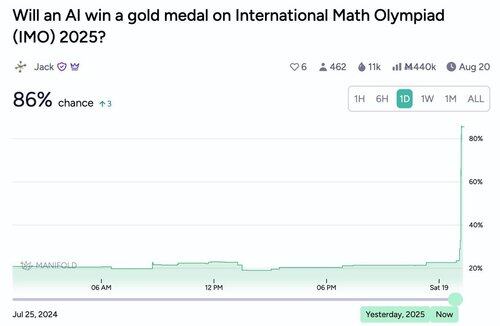

Noam ma tendencję do nieprzesadzania.

Noam Brown19 lip, 15:52

Gdzie to prowadzi? Tak szybko, jak postęp w dziedzinie AI był ostatnio, w pełni oczekuję, że trend ten będzie się utrzymywał. Co ważne, myślę, że jesteśmy blisko momentu, w którym AI znacznie przyczyni się do odkryć naukowych. Istnieje duża różnica między AI, które jest nieco poniżej najlepszej ludzkiej wydajności, a tym, które jest nieco powyżej.

791

Całkowicie się zgadzam - Flower labs to kolejna grupa, która aktywnie publikuje świetne materiały i teraz skupia się na zdecentralizowanym szkoleniu. Powinno to być istotnym punktem odniesienia dla wszystkich, którzy wciąż są sceptyczni wobec tej dziedziny - zespół Flower jest tak wiarygodny, jak to tylko możliwe, a Nic Lane to praktycznie szczyt w Federated Learning.

Każdy sygnał wskazuje na to, że jesteśmy świadkami ogromnego akademickiego punktu zwrotnego w tej dziedzinie po stronie ML. To już nie jest nawet kontrowersyjne, to przeszło od tego do wyraźnie wczesnych dni tego, co stanie się istotnym i bardzo wpływowym polem.

nic lane16 lip, 19:35

Gratulacje za artykuł @_AlexanderLong. Ale pominąłeś @flwrlabs, który opublikował pełny system (photon) z walidowanym w terenie w pełni zdecentralizowanym treningiem do 13B na @MLSysConf. Wraz z kluczową techniką zdecentralizowanego stosu (oddzielone osadzenia) opublikowaną jako wystąpienie ustne na @iclr_conf. To była praca wykonana wspólnie z @CaMLSys na @Cambridge_Uni.

1,02K

Użytkownik Alexander Long udostępnił ponownie

Z mojego doświadczenia wynika, że uzyskanie akceptacji artykułu na temat zdecentralizowanego DL na konferencjach na najwyższym poziomie może być dość trudne. Motywacja nie jest znana wielu recenzentom, a standardowe ustawienia eksperymentów nie uwzględniają problemów, które chcesz rozwiązać.

Dlatego bardzo się cieszę, że firmy takie jak @PluralisHQ i @PrimeIntellect inwestują wysiłek w dzielenie się swoimi wynikami i publikowanie ich na dużych konferencjach! IMO nawet przygotowanie zgłoszenia zmusza cię do większej rygorystyczności w kwestii twoich eksperymentów, a zewnętrzne opinie od recenzentów pomagają wyostrzyć przesłanie artykułu.

7,24K

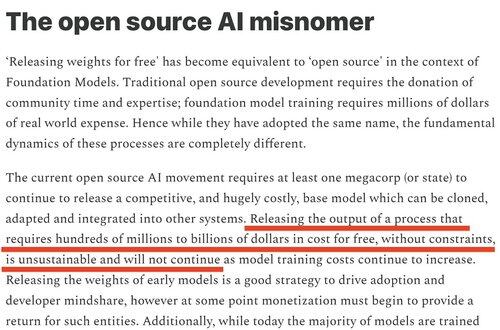

Czułem, że zamknięcie modeli przez meta było bardzo przewidywalne. Wyraźnie powiedziałem, że to się wydarzy w zeszłym roku i wyjaśniłem dlaczego (z ).

Shane Gu15 lip, 05:35

Cześć dla startupów AI wartych miliardy, które nie mają żadnych produktów, żadnych modeli bazowych i po prostu miały polegać na dużych laboratoriach, które udostępniają modele open-source za darmo do łączenia modeli. Znam jeden lub dwa.

3,62K

Użytkownik Alexander Long udostępnił ponownie

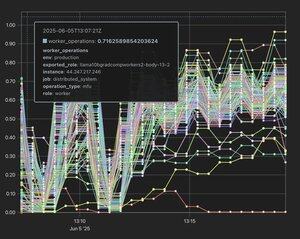

Mówiłem przez 50 minut bez przerwy do pełnej sali badaczy AI na ICML, prezentując prace @akashnet_, @PrimeIntellect, @gensynai, @NousResearch, @PluralisHQ i @GoogleDeepMind.

Obecnie istnieje ogromne zainteresowanie DeAI.

Misja (częściowo) zrealizowana.

10,77K

Dla osób, które nie są zaznajomione z publikowaniem w AI; co roku odbywają się 3 główne konferencje. ICML, ICLR i NeurIPS. To są konferencje techniczne i odpowiadają czasopismom w innych dziedzinach - są głównym miejscem publikacji w AI. Konkurencja o przyjęcie prac na te konferencje osiągnęła już absurdalny poziom, akceptacja prac jest bardzo trudna, a wiele osób ma obawy co do procesu recenzji, który w tym momencie jest dość hałaśliwy. Silna praca bez wad ma około 50% szans na akceptację, a zazwyczaj praca jest składana z poprawkami od recenzentów kilka razy, aż zostanie zaakceptowana. Mimo to, prace w tych miejscach pozostają głównym znakiem legitymacji w świecie AI i prawdopodobnie nadal są głównymi wskaźnikami kariery dla badaczy ML (chociaż moim zdaniem to słabnie, ponieważ tak wiele badań w laboratoriach na granicy nie jest publikowanych).

Prace głównego toru różnią się znacznie od prac warsztatowych. Główny tor ma intensywną, poważną recenzję rówieśniczą. Prace warsztatowe są dla wstępnych badań, które dają pewne wskazanie interesującego wyniku, ale są albo niekompletne, albo wynik nie jest wystarczająco znaczący dla głównego toru. Muszą być recenzowane tylko przez pulę recenzentów warsztatowych i nie pojawiają się w materiałach konferencyjnych.

Wiele świetnych prac po raz pierwszy pojawiło się na warsztatach (np. grokking) - ale prace warsztatowe i głównego toru to zasadniczo różne rzeczy, z zasadniczo różnym poziomem wpływu. Jedynymi dwiema firmami w zdecentralizowanej AI, które mają prace głównego toru w tym roku, są @PrimeIntellect i Pluralis.

18,77K

Najlepsze

Ranking

Ulubione

Trendy onchain

Trendy na X

Niedawne największe finansowanie

Najbardziej godne uwagi