Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

jack morris

@meta @cornell de investigación // modelos de lenguaje, teoría de la información, ciencia de la IA

¡súper genial! inspirador

y un gran recordatorio de que la mayoría de los principales investigadores de IA no están, de hecho, en Twitter. la mayoría no tuitea, muchos no tienen cuentas

las personas más ruidosas aquí, las que publican más sobre IA, son típicamente solo tipos de tecnología anónimos y aleatorios.

Deedy2 ago, 12:10

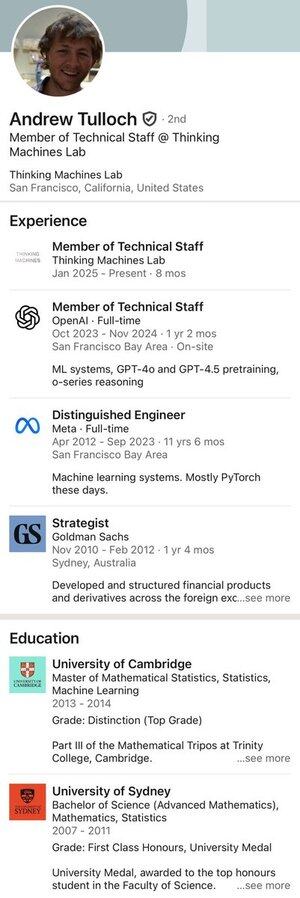

Aquí está: el hombre que rechazó una oferta de 1.000 millones de dólares durante 4 años de Meta.

26,46K

uno no simplemente "resuelve" un problema de investigación

uno en su lugar desarrolla un nuevo marco intelectual desde los primeros principios.

haciendo y respondiendo preguntas y subpreguntas, quizás durante varios meses

eventualmente, al volver a visitar el problema original, se da cuenta de que es trivial

5,15K

aquí hay un poco de información valiosa:

si hacemos RL durante demasiado tiempo después del preentrenamiento, seguramente sobrescribiremos parámetros y comenzaremos a olvidar cosas.

en el artículo original de instructGPT, su mejor modelo mezcló RLHF con gradientes de preentrenamiento para evitar exactamente este problema de deriva del modelo.

sin embargo, nadie está haciendo esto ya. claro, es una instancia particular (mezcla de gradientes) de una idea más amplia (evitar el olvido), pero parece ser una línea de pensamiento muy pasada por alto a medida que hacemos más y más pasos de RL.

por ejemplo, vean el reciente artículo de ProRL. ahora están haciendo más de 1000 pasos de GRPO con una tasa de aprendizaje no trivial y sin penalización por desviarse del modelo original. los circuitos construidos dentro del modelo durante el preentrenamiento seguramente están comenzando a decaer. y si no, lo harán después de 10k o 100k pasos de RL.

sospecho que esta idea volverá eventualmente; probablemente ya lo estén haciendo en los grandes laboratorios.

55,25K

esto parece realmente importante:

es totalmente plausible que un modelo pudiera obtener IMO oro sin *ningún* aprendizaje por refuerzo, dado un prompt perfectamente elaborado.

simplemente no lo sabemos, y carecemos de herramientas para buscar de manera eficiente a través del espacio de prompts. me alegra ver que al menos alguien está intentando.

Lakshya A Agrawal29 jul 2025

¿Cómo se compara la optimización de prompts con algoritmos de RL como GRPO?

GRPO necesita miles de ejecuciones, pero los humanos pueden aprender de unos pocos ensayos, reflexionando sobre lo que funcionó y lo que no.

Conoce a GEPA: un optimizador de prompts reflexivo que puede superar a GRPO en hasta un 20% con 35 veces menos ejecuciones!🧵

38,47K

situación hipotética -

soy una empresa de IA que ha reducido el costo de transferir y almacenar modelos a cero. puedo ofrecer a cada usuario su propio modelo sin costos adicionales.

¿qué hago? ¿entrenar directamente modelos específicos para el usuario con sus datos? ¿o hacer RLHF basado en las calificaciones del chat? ¿algo más?

16,61K

Parte superior

Clasificación

Favoritos

En tendencia on-chain

En tendencia en X

Principales fondos recientes

Más destacado