Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

jack morris

дослідження @meta @cornell // мовні моделі, теорія інформації, наука про штучний інтелект

Супер круто! Надихає

і чудове нагадування про те, що більшість провідних дослідників штучного інтелекту насправді не сидять у Twitter. Більшість не твітить, багато хто не має облікових записів

найгучніші люди тут, ті, хто найбільше пишуть про штучний інтелект, як правило, просто випадкові анонімні технічні брати

Deedy21 години тому

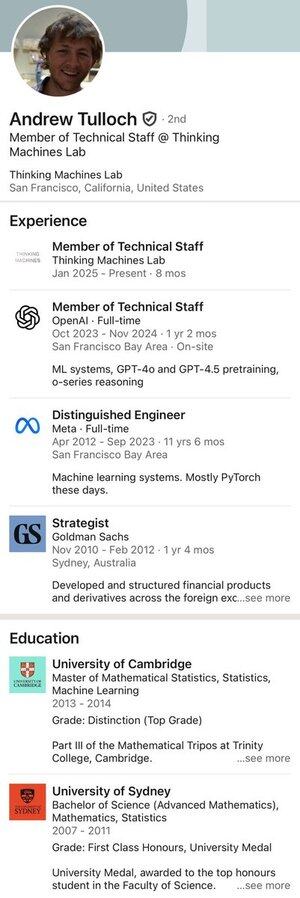

Ось він: людина, яка за 4 роки відхилила пропозицію від Meta на 1 мільярд доларів.

3,89K

Ось деякі з безкоштовних альфа-версій:

якщо ми будемо робити RL занадто довго після попередньої підготовки, ми обов'язково перезаписаємо параметри і почнемо забувати речі

в оригінальному документі InstructGPT, їхня найкраща модель змішала RLHF з градієнтами попереднього навчання, щоб уникнути саме цієї проблеми з дрейфом моделі

Але цього вже ніхто не робить. Звичайно, це одна особлива інстанціація (градієнтне змішування) більш широкої ідеї (уникнення забування), але здається сильно недооціненою лінією мислення, оскільки ми робимо все більше і більше кроків РЛ

наприклад, дивіться нещодавню статтю ProRL. Тепер вони роблять понад 1000 кроків GRPO з нетривіальною швидкістю навчання та без штрафу за відхилення від оригінальної моделі. Схеми, вбудовані всередині моделі під час передтренувальної підготовки, напевно починають руйнуватися. а якщо ні, то після 10 або 100 тисяч кроків RL

Я підозрюю, що ця ідея з часом повернеться; Вони, напевно, вже роблять це у великих лабораторіях

54,8K

Це здається дуже важливим:

цілком імовірно, що модель може отримати золото IMO без *будь-якого* навчання з підкріпленням, за умови ідеально складеної підказки

Ми просто не знаємо, і нам не вистачає інструментів для ефективного пошуку в оперативному просторі. радий бачити, що хоч хтось намагається

Lakshya A Agrawal29 лип. 2025 р.

Як оперативна оптимізація порівнюється з RL algos, такими як GRPO?

GRPO потребує 1000 розгортань, але люди можуть вчитися на кількох випробуваннях, розмірковуючи про те, що спрацювало, а що ні.

Зустрічайте GEPA: оптимізатор рефлексивних підказок, який може перевершити GRPO до 20% завдяки в 35 разів меншій кількості розгортань! 🧵

38,46K

гіпотетична ситуація -

Я компанія зі штучним інтелектом, яка звела витрати на передачу та зберігання моделей до нуля. Я можу подати кожному користувачеві свою модель без зайвих витрат

Що робити? безпосередньо SFT специфічні для користувача моделі на їх даних? або RLHF на чаті рейтинги? Щось інше?

16,6K

Найкращі

Рейтинг

Вибране

Актуальне ончейн

Популярні в X

Нещодавнє найкраще фінансування

Найбільш варте уваги