Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

jack morris

@meta @cornell de recherche // modèles de langage, théorie de l’information, science de l’IA

super cool ! inspirant

et un excellent rappel que la plupart des meilleurs chercheurs en IA ne sont pas, en fait, sur Twitter. la plupart ne tweetent pas, beaucoup n'ont pas de comptes

les personnes les plus bruyantes ici, celles qui postent le plus sur l'IA, sont généralement juste des tech bros anonymes aléatoires.

Deedy2 août, 12:10

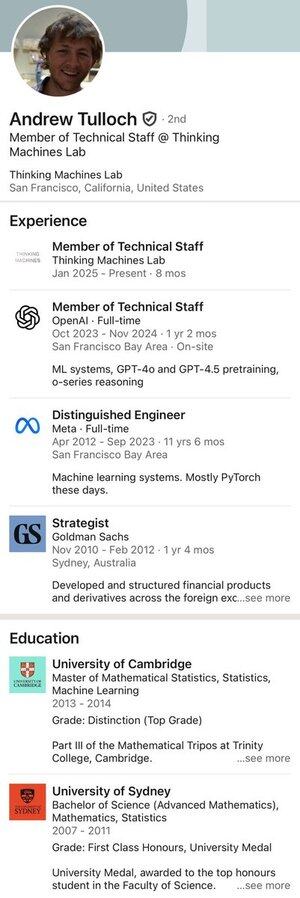

Le voici : l'homme qui a refusé une offre de 1 milliard de dollars sur 4 ans de Meta.

26,46K

on ne "résout" pas simplement un problème de recherche

on développe plutôt un nouveau cadre intellectuel à partir des premiers principes.

poser et répondre à des questions et sous-questions, peut-être pendant plusieurs mois

finalement, en revisitant le problème original, on réalise qu'il est trivial.

5,14K

voici quelques informations gratuites :

si nous faisons du RL trop longtemps après le pré-entraînement, nous allons sûrement écraser les paramètres et commencer à oublier des choses.

dans l'article original de instructGPT, leur meilleur modèle mélangeait RLHF avec des gradients de pré-entraînement pour éviter exactement ce problème de dérive du modèle.

pourtant, personne ne fait cela maintenant. bien sûr, c'est une instanciation particulière (mélange de gradients) d'une idée plus large (éviter l'oubli), mais cela semble être une ligne de pensée grandement négligée alors que nous faisons de plus en plus d'étapes de RL.

par exemple, voir le récent article ProRL. ils font maintenant plus de 1000 étapes de GRPO avec un taux d'apprentissage non trivial et aucune pénalité pour s'écarter du modèle original. les circuits construits à l'intérieur du modèle pendant le pré-entraînement commencent sûrement à se dégrader. et sinon, ils le feront après 10k ou 100k étapes de RL.

je soupçonne que cette idée reviendra éventuellement ; ils le font probablement déjà dans les grands laboratoires.

55,25K

cela semble vraiment important :

il est tout à fait plausible qu'un modèle puisse obtenir de l'or IMO sans *aucun* apprentissage par renforcement, étant donné un prompt parfaitement conçu.

nous ne savons tout simplement pas, et nous manquons d'outils pour explorer efficacement l'espace des prompts. content de voir qu'au moins quelqu'un essaie.

Lakshya A Agrawal29 juil. 2025

Comment l'optimisation des prompts se compare-t-elle aux algorithmes RL comme GRPO ?

GRPO nécessite des milliers de déploiements, mais les humains peuvent apprendre à partir de quelques essais—en réfléchissant à ce qui a fonctionné et à ce qui n'a pas fonctionné.

Découvrez GEPA : un optimiseur de prompts réflexif qui peut surpasser GRPO de jusqu'à 20 % avec 35 fois moins de déploiements !🧵

38,47K

situation hypothétique -

je suis une entreprise d'IA qui a réduit le coût de transfert et de stockage des modèles à zéro. Je peux servir à chaque utilisateur son propre modèle sans frais généraux.

Que dois-je faire ? SFT directement des modèles spécifiques à l'utilisateur sur leurs données ? Ou RLHF sur les évaluations de chat ? Autre chose ?

16,61K

Meilleurs

Classement

Favoris

Tendance on-chain

Tendance sur X

Récents financements de premier plan

Les plus notables