Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Artificial Analysis

Análisis independiente de modelos de IA y proveedores de alojamiento: elija el mejor modelo y proveedor de API para su caso de uso

DeepSeek lanza V3.1, unificando V3 y R1 en un modelo de razonamiento híbrido con un aumento incremental en inteligencia

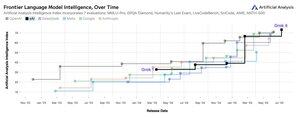

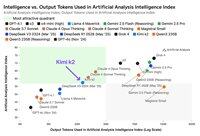

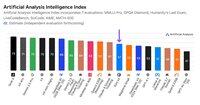

Aumento incremental de inteligencia: Los resultados iniciales de evaluación para DeepSeek V3.1 muestran un Índice de Inteligencia de Análisis Artificial de 60 en modo de razonamiento, por encima de la puntuación de 59 de R1. En modo no razonamiento, V3.1 alcanza una puntuación de 49, un mayor aumento respecto a la puntuación anterior de V3 0324 de 44. Esto deja a V3.1 (razonamiento) detrás del último Qwen3 235B 2507 de Alibaba (razonamiento) - DeepSeek no ha recuperado el liderazgo.

Razonamiento híbrido: @deepseek_ai ha pasado a un modelo de razonamiento híbrido por primera vez, apoyando tanto modos de razonamiento como no razonamiento. El movimiento de DeepSeek hacia un modelo de razonamiento híbrido unificado imita el enfoque adoptado por OpenAI, Anthropic y Google. Sin embargo, es interesante notar que Alibaba recientemente abandonó su enfoque híbrido que favorecía para Qwen3 con sus lanzamientos separados de los modelos de razonamiento y de instrucción de Qwen3 2507.

Llamadas a funciones / uso de herramientas: Aunque DeepSeek afirma haber mejorado las llamadas a funciones para el modelo, DeepSeek V3.1 no soporta llamadas a funciones cuando está en modo de razonamiento. Esto probablemente limitará sustancialmente su capacidad para soportar flujos de trabajo agentes con requisitos de inteligencia, incluyendo en agentes de codificación.

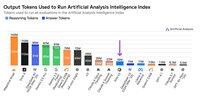

Uso de tokens: DeepSeek V3.1 obtiene puntuaciones incrementalmente más altas en modo de razonamiento que DeepSeek R1, y utiliza ligeramente menos tokens en las evaluaciones que usamos para el Índice de Inteligencia de Análisis Artificial. En modo no razonamiento, utiliza ligeramente más tokens que V3 0324, pero aún así varias veces menos que en su propio modo de razonamiento.

API: La API de primera parte de DeepSeek ahora sirve el nuevo modelo DeepSeek V3.1 en sus puntos finales de chat y razonamiento, simplemente cambiando si el token de pensamiento final </think> se proporciona al modelo en la plantilla de chat para controlar si el modelo razonará.

Arquitectura: DeepSeek V3.1 es arquitectónicamente idéntico a los modelos anteriores V3 y R1, con 671B de parámetros totales y 37B de parámetros activos.

Implicaciones: Aconsejaríamos precaución al hacer suposiciones sobre lo que esta versión implica sobre el progreso de DeepSeek hacia un futuro modelo referido en rumores como V4 o R2. Notamos que DeepSeek lanzó previamente el modelo final construido sobre su arquitectura V2 el 10 de diciembre de 2024, solo dos semanas antes de lanzar V3.

70,48K

Anunciando el Análisis Artificial de Razonamiento de Largo Contexto (AA-LCR), un nuevo estándar para evaluar el rendimiento en contextos largos a través de pruebas de capacidades de razonamiento en múltiples documentos largos (~100k tokens)

El enfoque de AA-LCR es replicar el trabajo de conocimiento real y las tareas de razonamiento, probando capacidades críticas para las aplicaciones modernas de IA que abarcan el análisis de documentos, la comprensión de bases de código y flujos de trabajo complejos de múltiples pasos.

AA-LCR consiste en 100 preguntas difíciles basadas en texto que requieren razonamiento a través de múltiples documentos del mundo real que representan ~100k tokens de entrada. Las preguntas están diseñadas de tal manera que las respuestas no se pueden encontrar directamente, sino que deben deducirse de múltiples fuentes de información, con pruebas humanas que verifican que cada pregunta requiere una inferencia genuina en lugar de recuperación.

Puntos clave:

➤ Los modelos líderes de hoy logran ~70% de precisión: los tres primeros lugares son para OpenAI o3 (69%), xAI Grok 4 (68%) y Qwen3 235B 2507 Thinking (67%)

➤👀 ¡También ya tenemos resultados de gpt-oss! 120B se desempeña cerca de o4-mini (alto), en línea con las afirmaciones de OpenAI sobre el rendimiento del modelo. Pronto seguiremos con un Índice de Inteligencia para los modelos.

➤ 100 preguntas difíciles basadas en texto que abarcan 7 categorías de documentos (Informes de Empresas, Informes de la Industria, Consultas Gubernamentales, Academia, Legal, Materiales de Marketing e Informes de Encuestas)

➤ ~100k tokens de entrada por pregunta, requiriendo que los modelos soporten un mínimo de 128K de ventana de contexto para puntuar en este estándar

➤ ~3M de tokens de entrada únicos en ~230 documentos para ejecutar el estándar (los tokens de salida varían típicamente según el modelo)

➤ El enlace al conjunto de datos en 🤗 @HuggingFace está abajo

Estamos añadiendo AA-LCR al Índice de Inteligencia de Análisis Artificial, y llevando el número de versión a v2.2. El Índice de Inteligencia de Análisis Artificial v2.2 ahora incluye: MMLU-Pro, GPQA Diamond, AIME 2025, IFBench, LiveCodeBench, SciCode y AA-LCR.

Todos los números están actualizados en el sitio ahora. Descubre qué modelos incluye el Índice de Inteligencia de Análisis Artificial v2.2 👇

28,71K

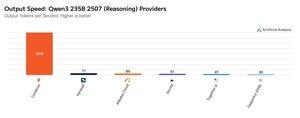

Cerebras ha estado demostrando su capacidad para alojar grandes MoEs a velocidades muy altas esta semana, lanzando los puntos finales Qwen3 235B 2507 y Qwen3 Coder 480B a >1,500 tokens de salida/s

➤ @CerebrasSystems ahora ofrece puntos finales tanto para Qwen3 235B 2507 Razonamiento como No-razonamiento. Ambos modelos tienen 235B de parámetros totales con 22B activos.

➤ Qwen 3 235B 2507 Razonamiento ofrece una inteligencia comparable a o4-mini (alta) y DeepSeek R1 0528. La variante No-razonamiento ofrece una inteligencia comparable a Kimi K2 y muy por encima de GPT-4.1 y Llama 4 Maverick.

➤ Qwen3 Coder 480B tiene 480B de parámetros totales con 35B activos. Este modelo es particularmente fuerte para la codificación agente y se puede utilizar en una variedad de herramientas de agentes de codificación, incluyendo la Qwen3-Coder CLI.

Los lanzamientos de Cerebras representan la primera vez que este nivel de inteligencia ha estado accesible a estas velocidades de salida y tienen el potencial de desbloquear nuevos casos de uso, como usar un modelo de razonamiento para cada paso de un agente sin tener que esperar minutos.

25,2K

🇰🇷 LG lanzó recientemente el EXAONE 4.0 32B - obtiene 62 en el Índice de Inteligencia de Análisis Artificial, la puntuación más alta para un modelo 32B hasta ahora.

El EXAONE 4.0 de @LG_AI_Research se lanza en dos variantes: el modelo híbrido de razonamiento 32B del que estamos informando los resultados de las pruebas aquí, y un modelo más pequeño de 1.2B diseñado para aplicaciones en el dispositivo que aún no hemos evaluado.

Junto con el reciente lanzamiento del Solar Pro 2 de Upstage, es emocionante ver a los laboratorios de IA de Corea unirse a los de EE. UU. y China cerca de la cima de las listas de inteligencia.

Resultados clave:

➤ 🧠 EXAONE 4.0 32B (Razonamiento): En modo de razonamiento, el EXAONE 4.0 obtiene 62 en el Índice de Inteligencia de Análisis Artificial. Esto iguala a Claude 4 Opus y al nuevo Llama Nemotron Super 49B v1.5 de NVIDIA, y se sitúa solo 1 punto detrás de Gemini 2.5 Flash.

➤ ⚡ EXAONE 4.0 32B (No Razonamiento): En modo no razonamiento, el EXAONE 4.0 obtiene 51 en el Índice de Inteligencia de Análisis Artificial. Iguala a Llama 4 Maverick en inteligencia a pesar de tener solo ~1/4 de parámetros totales (aunque tiene ~2x los parámetros activos).

➤ ⚙️ Tokens de salida y verbosidad: En modo de razonamiento, el EXAONE 4.0 utilizó 100M de tokens de salida para el Índice de Inteligencia de Análisis Artificial. Esto es más alto que algunos otros modelos de frontera, pero se alinea con las tendencias recientes de modelos de razonamiento que utilizan más tokens de salida para 'pensar más' - similar a Llama Nemotron Super 49B v1.5, Grok 4 y Qwen3 235B 2507 Razonamiento. En modo no razonamiento, el EXAONE 4.0 utilizó 15M de tokens - alto para un no razonador, pero no tan alto como los 30M de Kimi K2.

Detalles clave:

➤ Razonamiento híbrido: El modelo ofrece opcionalidad entre modo 'razonamiento' y modo 'no razonamiento'.

➤ Disponibilidad: Actualmente alojado por @friendliai, y con precios competitivos (especialmente en comparación con opciones propietarias) por FriendliAI a $1 por 1M de tokens de entrada y salida.

➤ Pesos abiertos: El EXAONE 4.0 es un modelo de pesos abiertos disponible bajo el Acuerdo de Licencia del Modelo de IA EXAONE 1.2. La licencia limita el uso comercial.

➤ Multimodalidad: Solo entrada y salida de texto.

➤ Ventana de contexto: 131k tokens.

➤ Parámetros: 32B de parámetros activos y totales, disponibles en precisión de 16 bits y 8 bits (lo que significa que el modelo se puede ejecutar en un solo chip H100 en precisión completa).

41,56K

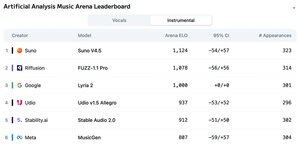

Anunciando el Ranking del Arena de Análisis Artificial de Música: con más de 5k votos, Suno v4.5 es el modelo líder de Generación de Música, seguido por el FUZZ-1.1 Pro de Riffusion.

Lyria 2 de Google ocupa el tercer lugar en nuestro ranking de Instrumental, y el v1.5 Allegro de Udio ocupa el tercer lugar en nuestro ranking de Voces.

El Ranking de Instrumental es el siguiente:

🥇 @SunoMusic V4.5

🥈 @riffusionai FUZZ-1.1 Pro

🥉 @GoogleDeepMind Lyria 2

@udiomusic v1.5 Allegro

@StabilityAI Stable Audio 2.0

@metaai MusicGen

Los rankings se basan en los votos de la comunidad a través de una amplia gama de géneros y prompts. ¿Quieres ver tu prompt destacado? Puedes enviar prompts en la arena hoy.

👇 ¡Mira a continuación el Ranking de Voces y el enlace para participar!

22,19K

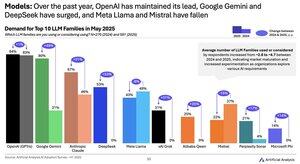

Cambio de la demanda del modelo 2024 a 2025: Google (+49pts), DeepSeek (+53pts) y xAI (+31pts) han logrado ganancias masivas en la cuota de demanda durante el año pasado

@Google ha pasado de ser un rezagado de IA a un líder de IA con un aumento de ~2,5 veces en la proporción de encuestados que utilizan o consideran la serie de modelos Gemini. Un factor clave de esto ha sido que Google ha logrado avances significativos en inteligencia: Gemini 2.5 Pro ahora se encuentra en el #3 en nuestro Índice de Inteligencia de Análisis Artificial, en comparación con el retraso significativo de OpenAI y Anthropic a principios de 2024.

@deepseek_ai en el primer semestre de 2024 solo había lanzado DeepSeek 67B, un modelo que tuvo una adopción limitada y tuvo un rendimiento inferior al de Llama 3 70B. DeepSeek vio por primera vez cierta aceptación a fines de 2024 con los lanzamientos de su modelo V2, y luego vio una rápida adopción a principios de 2025 con sus modelos V3 y R1 que los han llevado al liderazgo entre los modelos de peso abierto.

@xai lanzó su primer modelo Grok-1 a mediados del primer semestre de 2024 y desde entonces ha ascendido rápidamente al liderazgo de inteligencia en todos los modelos con lanzamientos sucesivos, que culminaron con el lanzamiento de Grok 4 la semana pasada.

Fuente: Encuesta de adopción de IA de análisis artificial H1 2025 (informe disponible en el sitio web de Análisis artificial)

389,04K

Proveedores de Kimi K2: Groq está sirviendo Kimi K2 a >400 tokens de salida/s, 40 veces más rápido que la API de primera parte de Moonshot.

Felicitaciones a varios proveedores por ser rápidos en lanzar APIs para Kimi K2, incluyendo a @GroqInc, @basetenco, @togethercompute, @FireworksAI_HQ, @parasail_io, @novita_labs, @DeepInfra, y por supuesto a @Kimi_Moonshot. Esto es impresionante considerando el tamaño del modelo con 1 billón de parámetros en total.

Groq se destaca por su velocidad increíblemente rápida. DeepInfra, Novita y Baseten se destacan por sus precios, siendo los únicos proveedores que tienen precios similares o más baratos que la API de primera parte de Moonshot.

Vea a continuación más comparaciones entre los proveedores. Esperamos aumentos rápidos en la velocidad entre algunos proveedores a medida que los equipos optimizan para el modelo K2; nuestros números a continuación muestran velocidades medianas durante las últimas 72 horas, pero ya estamos viendo a DeepInfra alcanzar 62 tokens/s en las mediciones de hoy.

52,3K

Si bien Kimi k2 de Moonshot AI es el modelo de no razonamiento de ponderaciones abiertas líder en el Índice de Inteligencia de Análisis Artificial, produce ~ 3 veces más tokens que otros modelos sin razonamiento, difuminando las líneas entre razonamiento y no razonamiento

Kimi k2 es el modelo de pesas abiertas más grande hasta el momento: parámetros totales de 1T con 32B activos (esto requiere un enorme 1TB de memoria en FP8 nativo para sostener los pesos). Tenemos k2 en 57 en el Índice de Inteligencia de Análisis Artificial, una puntuación impresionante que lo coloca por encima de modelos como GPT-4.1 y DeepSeek V3, pero detrás de los principales modelos de razonamiento.

Hasta ahora, ha habido una clara distinción entre el modelo de razonamiento y los modelos no racionales en nuestras evaluaciones, definidas no solo por si el modelo usa <reasoning> etiquetas, sino principalmente por el uso de tokens. El número medio de tokens utilizados para responder a todas las evaluaciones en el Índice de Inteligencia de Análisis Artificial es ~10 veces mayor para los modelos de razonamiento que para los modelos sin razonamiento.

Kimi k2 de @Kimi_Moonshot usa ~ 3 veces la cantidad de tokens que usa el modelo medio sin razonamiento. Su uso de tokens es solo hasta un 30% más bajo que Claude 4 Sonnet y Opus cuando se ejecuta en su modo de pensamiento extendido de presupuesto máximo, y es casi el triple del uso de tokens de Claude 4 Sonnet y Opus con el razonamiento desactivado.

Por lo tanto, recomendamos que Kimi k2 se compare con Claude 4 Sonnet y Opus en sus modos de pensamiento extendido de presupuesto máximo, no con las partituras no razonadas de los modelos Claude 4.

Kimi k2 está disponible en la API propia de @Kimi_Moonshot, así como en @FireworksAI_HQ, @togethercompute, @novita_labs y @parasail_io.

Consulte a continuación y en Análisis artificial para obtener más información sobre el análisis 👇

60,62K

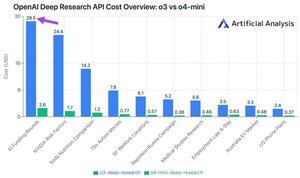

¡La nueva API de investigación profunda de OpenAI cuesta hasta ~ $ 30 por llamada a la API! Estos nuevos puntos finales de la API de Deep Research podrían ser la nueva forma más rápida de gastar dinero

En nuestras 10 consultas de pruebas de investigación profundas, gastamos $ 100 en o3 y $ 9.18 en o4-mini. ¿Cómo se vuelven tan grandes los costos? Precios altos y millones de tokens.

Estos puntos finales son versiones de o3 y o4-mini que han sido RL para tareas de investigación profundas. La disponibilidad a través de API permite que se utilicen tanto con la herramienta de búsqueda web de OpenAI como con fuentes de datos personalizadas a través de servidores MCP remotos.

El precio de o4-mini-deep-research es 5 veces más bajo que el precio de o3-deep-research. En nuestras consultas de prueba, o4-mini también parece usar menos tokens: es más de 10 veces más barato en total en nuestras 10 consultas de prueba.

Precios:

➤ o3-deep-research tiene un precio de $ 10 / M de entrada ($ 2.50 entrada en caché), $ 40 / M de salida

➤ o4-mini-deep-research tiene un precio de $ 2 / M de entrada ($ 0.5 entrada en caché), $ 8 / M de salida

Estos puntos finales son sustancialmente más caros que los puntos finales o3 y o4-mini estándar de OpenAI, que se encuentran en:

➤ o3: entrada de $ 2 / M ($ 0.5 en caché), salida de $ 8 / M para o3

➤ o4-mini: entrada de $ 1.1 / M (0.275 en caché), salida de $ 4.4 / M

37,33K

Parte superior

Clasificación

Favoritos

En tendencia on-chain

En tendencia en X

Principales fondos recientes

Más destacado