Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Artificial Analysis

Análise independente de modelos de IA e provedores de hospedagem - escolha o melhor modelo e provedor de API para seu caso de uso

A DeepSeek lança a V3.1, unificando a V3 e a R1 em um modelo híbrido de raciocínio com um aumento incremental na inteligência

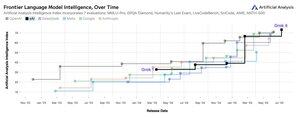

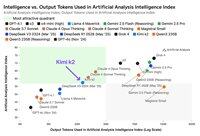

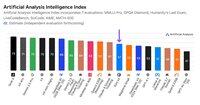

Aumento incremental de inteligência: Os resultados iniciais de benchmark para a DeepSeek V3.1 mostram um Índice de Inteligência de Análise Artificial de 60 em modo de raciocínio, acima da pontuação de 59 da R1. Em modo não-raciocínio, a V3.1 alcança uma pontuação de 49, um aumento maior em relação à pontuação anterior da V3 0324 de 44. Isso deixa a V3.1 (raciocínio) atrás do Qwen3 235B 2507 (raciocínio) da Alibaba - a DeepSeek não recuperou a liderança.

Raciocínio híbrido: @deepseek_ai mudou para um modelo híbrido de raciocínio pela primeira vez - suportando tanto modos de raciocínio quanto não-raciocínio. A mudança da DeepSeek para um modelo híbrido unificado imita a abordagem adotada pela OpenAI, Anthropic e Google. É interessante notar, no entanto, que a Alibaba recentemente abandonou a abordagem híbrida que favorecia para o Qwen3 com seus lançamentos separados dos modelos de raciocínio e instrução do Qwen3 2507.

Chamada de função / uso de ferramentas: Embora a DeepSeek afirme ter melhorado a chamada de função para o modelo, a DeepSeek V3.1 não suporta chamada de função quando em modo de raciocínio. Isso provavelmente limitará substancialmente sua capacidade de suportar fluxos de trabalho agentes com requisitos de inteligência, incluindo em agentes de codificação.

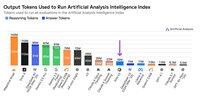

Uso de tokens: A DeepSeek V3.1 pontua incrementalmente mais alto em modo de raciocínio do que a DeepSeek R1, e usa ligeiramente menos tokens nos evals que usamos para o Índice de Inteligência de Análise Artificial. Em modo não-raciocínio, usa ligeiramente mais tokens do que a V3 0324 - mas ainda assim várias vezes menos do que em seu próprio modo de raciocínio.

API: A API de primeira parte da DeepSeek agora serve o novo modelo DeepSeek V3.1 em seus endpoints de chat e raciocínio - simplesmente mudando se o token de pensamento final </think> é fornecido ao modelo no template de chat para controlar se o modelo irá raciocinar.

Arquitetura: A DeepSeek V3.1 é arquitetonicamente idêntica aos modelos anteriores V3 e R1, com 671B de parâmetros totais e 37B de parâmetros ativos.

Implicações: Aconselharíamos cautela ao fazer quaisquer suposições sobre o que este lançamento implica sobre o progresso da DeepSeek em direção a um futuro modelo referido em rumores como V4 ou R2. Notamos que a DeepSeek lançou anteriormente o modelo final construído em sua arquitetura V2 em 10 de dezembro de 2024, apenas duas semanas antes de lançar a V3.

70,78K

Anunciando a Análise Artificial de Raciocínio de Longo Contexto (AA-LCR), um novo benchmark para avaliar o desempenho em contextos longos através da testagem das capacidades de raciocínio em múltiplos documentos longos (~100k tokens)

O foco da AA-LCR é replicar o trabalho real de conhecimento e tarefas de raciocínio, testando capacidades críticas para aplicações modernas de IA que abrangem análise de documentos, compreensão de bases de código e fluxos de trabalho complexos de múltiplos passos.

AA-LCR consiste em 100 perguntas difíceis baseadas em texto que requerem raciocínio através de múltiplos documentos do mundo real que representam ~100k tokens de entrada. As perguntas são projetadas de forma que as respostas não possam ser encontradas diretamente, mas devem ser inferidas a partir de múltiplas fontes de informação, com testes humanos verificando que cada pergunta requer uma inferência genuína em vez de recuperação.

Principais conclusões:

➤ Os modelos líderes de hoje alcançam ~70% de precisão: os três primeiros lugares vão para OpenAI o3 (69%), xAI Grok 4 (68%) e Qwen3 235B 2507 Thinking (67%)

➤👀 Também já temos resultados do gpt-oss! 120B apresenta desempenho próximo ao o4-mini (alto), alinhado com as alegações da OpenAI sobre o desempenho do modelo. Em breve, seguiremos com um Índice de Inteligência para os modelos.

➤ 100 perguntas difíceis baseadas em texto abrangendo 7 categorias de documentos (Relatórios de Empresas, Relatórios da Indústria, Consultas Governamentais, Academia, Legal, Materiais de Marketing e Relatórios de Pesquisa)

➤ ~100k tokens de entrada por pergunta, exigindo que os modelos suportem uma janela de contexto mínima de 128K para pontuar neste benchmark

➤ ~3M de tokens de entrada únicos abrangendo ~230 documentos para executar o benchmark (os tokens de saída geralmente variam por modelo)

➤ O link para o conjunto de dados no 🤗 @HuggingFace está abaixo

Estamos adicionando a AA-LCR ao Índice de Inteligência da Análise Artificial, e elevando o número da versão para v2.2. O Índice de Inteligência da Análise Artificial v2.2 agora inclui: MMLU-Pro, GPQA Diamond, AIME 2025, IFBench, LiveCodeBench, SciCode e AA-LCR.

Todos os números estão atualizados no site agora. Descubra quais modelos estão no Índice de Inteligência da Análise Artificial v2.2 👇

28,72K

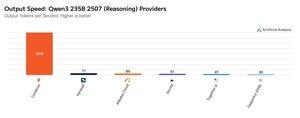

A Cerebras tem demonstrado a sua capacidade de hospedar grandes MoEs a velocidades muito altas esta semana, lançando os endpoints Qwen3 235B 2507 e Qwen3 Coder 480B a >1.500 tokens de saída/s

➤ @CerebrasSystems agora oferece endpoints para ambos Qwen3 235B 2507 Raciocínio & Não-raciocínio. Ambos os modelos têm 235B de parâmetros totais com 22B ativos.

➤ O Qwen 3 235B 2507 Raciocínio oferece inteligência comparável ao o4-mini (alto) & DeepSeek R1 0528. A variante Não-raciocínio oferece inteligência comparável ao Kimi K2 e bem acima do GPT-4.1 e Llama 4 Maverick.

➤ O Qwen3 Coder 480B tem 480B de parâmetros totais com 35B ativos. Este modelo é particularmente forte para codificação agentiva e pode ser usado em uma variedade de ferramentas de agentes de codificação, incluindo o Qwen3-Coder CLI.

Os lançamentos da Cerebras representam a primeira vez que este nível de inteligência tem estado acessível a estas velocidades de saída e têm o potencial de desbloquear novos casos de uso - como usar um modelo de raciocínio para cada passo de um agente sem ter que esperar minutos.

25,21K

🇰🇷 A LG lançou recentemente o EXAONE 4.0 32B - ele obteve 62 no Índice de Análise de Inteligência Artificial, a maior pontuação para um modelo 32B até agora.

O EXAONE 4.0 da @LG_AI_Research é lançado em duas variantes: o modelo híbrido de raciocínio 32B, para o qual estamos reportando resultados de benchmark aqui, e um modelo menor de 1.2B projetado para aplicações em dispositivo que ainda não avaliamos.

Juntamente com o recente lançamento do Solar Pro 2 da Upstage, é emocionante ver laboratórios de IA coreanos se juntarem aos EUA e à China perto do topo das tabelas de inteligência.

Resultados principais:

➤ 🧠 EXAONE 4.0 32B (Raciocínio): Em modo de raciocínio, o EXAONE 4.0 obteve 62 no Índice de Análise de Inteligência Artificial. Isso iguala o Claude 4 Opus e o novo Llama Nemotron Super 49B v1.5 da NVIDIA, e está apenas 1 ponto atrás do Gemini 2.5 Flash.

➤ ⚡ EXAONE 4.0 32B (Não-Raciocínio): Em modo não-raciocínio, o EXAONE 4.0 obteve 51 no Índice de Análise de Inteligência Artificial. Ele iguala o Llama 4 Maverick em inteligência, apesar de ter apenas ~1/4 dos parâmetros totais (embora tenha ~2x os parâmetros ativos).

➤ ⚙️ Tokens de saída e verbosidade: Em modo de raciocínio, o EXAONE 4.0 usou 100M de tokens de saída para o Índice de Análise de Inteligência Artificial. Isso é mais alto do que alguns outros modelos de fronteira, mas alinha-se com as tendências recentes de modelos de raciocínio usando mais tokens de saída para 'pensar mais' - semelhante ao Llama Nemotron Super 49B v1.5, Grok 4 e Qwen3 235B 2507 Raciocínio. Em modo não-raciocínio, o EXAONE 4.0 usou 15M de tokens - alto para um não-raciocinador, mas não tão alto quanto os 30M do Kimi K2.

Detalhes principais:

➤ Raciocínio híbrido: O modelo oferece opcionalidade entre o modo 'raciocínio' e o modo 'não-raciocínio'.

➤ Disponibilidade: Hospedado atualmente pela @friendliai, e com preços competitivos (especialmente em comparação com opções proprietárias) pela FriendliAI a $1 por 1M de tokens de entrada e saída.

➤ Pesos abertos: O EXAONE 4.0 é um modelo de pesos abertos disponível sob o Acordo de Licença do Modelo de IA EXAONE 1.2. A licença limita o uso comercial.

➤ Multimodalidade: Entrada e saída apenas em texto.

➤ Janela de contexto: 131k tokens.

➤ Parâmetros: 32B de parâmetros ativos e totais, disponíveis em precisão de 16 bits e 8 bits (o que significa que o modelo pode ser executado em um único chip H100 em precisão total).

41,57K

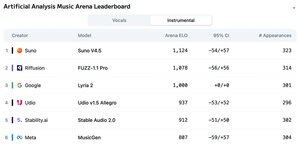

Anunciando o Quadro de Líderes da Arena de Análise Musical Artificial: com mais de 5 mil votos, o Suno v4.5 é o modelo de Geração Musical líder, seguido pelo FUZZ-1.1 Pro da Riffusion.

O Lyria 2 do Google ocupa o terceiro lugar no nosso quadro de Instrumentos, e o v1.5 Allegro da Udio ocupa o terceiro lugar no nosso quadro de Vocais.

O Quadro de Líderes Instrumentais é o seguinte:

🥇 @SunoMusic V4.5

🥈 @riffusionai FUZZ-1.1 Pro

🥉 @GoogleDeepMind Lyria 2

@udiomusic v1.5 Allegro

@StabilityAI Stable Audio 2.0

@metaai MusicGen

As classificações são baseadas em votos da comunidade em uma ampla gama de géneros e prompts. Quer ver o seu prompt destacado? Você pode enviar prompts na arena hoje.

👇 Veja abaixo o Quadro de Líderes de Vocais e o link para participar!

22,19K

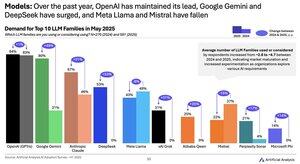

Modelo de mudança de demanda 2024 para 2025: Google (+49pts), DeepSeek (+53pts) e xAI (+31pts) alcançaram enormes ganhos em participação de demanda no ano passado

@Google passou de um retardatário de IA para um líder de IA com um aumento de ~2,5x na proporção de entrevistados usando ou considerando a série de modelos Gemini. Um fator-chave disso tem sido o Google fazendo ganhos significativos em inteligência: o Gemini 2.5 Pro agora está em #3 em nosso Índice de Inteligência de Análise Artificial, em comparação com significativamente atrasado em relação ao OpenAI e Anthropic no início de 2024.

@deepseek_ai no H1 2024 tinha lançado apenas o DeepSeek 67B, um modelo que viu uma adoção limitada e teve um desempenho inferior ao Llama 3 70B. A DeepSeek viu alguma aceitação no final de 2024 com os lançamentos de seu modelo V2, e depois viu uma rápida adoção no início de 2025 com seus modelos V3 e R1 que os levaram à liderança entre os modelos de pesos abertos.

@xai lançou seu primeiro modelo Grok-1 em meados do H1 2024 e, desde então, subiu rapidamente para a liderança de inteligência em todos os modelos com lançamentos sucessivos, culminando no lançamento do Grok 4 na semana passada.

Fonte: Artificial Analysis AI Adoption Survey H1 2025 (relatório disponível no sítio Web da Análise Artificial)

389,04K

Provedores Kimi K2: A Groq está a fornecer Kimi K2 a >400 tokens de saída/s, 40X mais rápido do que a API de primeira linha da Moonshot.

Parabéns a vários provedores por serem rápidos a lançar APIs para Kimi K2, incluindo @GroqInc, @basetenco, @togethercompute, @FireworksAI_HQ, @parasail_io, @novita_labs, @DeepInfra e, claro, @Kimi_Moonshot. Isso é impressionante considerando o tamanho do modelo com 1 trilhão de parâmetros no total.

A Groq destaca-se pela velocidade impressionante. A DeepInfra, Novita e Baseten destacam-se pelos seus preços, sendo os únicos provedores a cobrar de forma semelhante ou mais barata do que a API de primeira linha da Moonshot.

Veja abaixo mais comparações entre os provedores. Esperamos aumentos rápidos na velocidade entre alguns provedores à medida que as equipas otimizam para o modelo K2 - nossos números abaixo mostram velocidades medianas das últimas 72 horas, mas já estamos a ver a DeepInfra subir para 62 tokens/s nas medições de hoje.

52,31K

Embora o Kimi k2 da Moonshot AI seja o principal modelo de não-raciocínio de pesos abertos no Índice de Inteligência de Análise Artificial, ele produz ~3x mais tokens do que outros modelos sem raciocínio, borrando as linhas entre raciocínio e não raciocínio

Kimi k2 é o maior modelo de pesos abertos até agora - 1T parâmetros totais com 32B ativos (isso requer um enorme 1TB de memória no FP8 nativo para manter os pesos). Temos k2 em 57 no Artificial Analysis Intelligence Index, uma pontuação impressionante que o coloca acima de modelos como GPT-4.1 e DeepSeek V3, mas atrás de modelos de raciocínio líderes.

Até agora, havia uma distinção clara entre modelo de raciocínio e modelos sem raciocínio em nossos evals - definidos não apenas pelo <reasoning> uso de tags pelo modelo, mas principalmente pelo uso de tokens. O número mediano de tokens usados para responder a todos os evals no Índice de Inteligência de Análise Artificial é ~10x maior para modelos de raciocínio do que para modelos sem raciocínio.

O Kimi k2 da @Kimi_Moonshot usa ~3x o número de tokens que o modelo mediano sem raciocínio usa. Seu uso de token é apenas até 30% menor do que Claude 4 Sonnet e Opus quando executado em seu modo de pensamento estendido de orçamento máximo, e é quase o triplo do uso de token de Claude 4 Sonnet e Opus com o raciocínio desligado.

Portanto, recomendamos que Kimi k2 seja comparado com Claude 4 Sonnet e Opus em seus modos de pensamento estendido de orçamento máximo, não com as pontuações sem raciocínio para os modelos Claude 4.

O Kimi k2 está disponível na API de primeira parte da @Kimi_Moonshot, bem como @FireworksAI_HQ, @togethercompute, @novita_labs e @parasail_io.

Veja abaixo e em Análise Artificial para uma análise 👇 mais aprofundada

60,63K

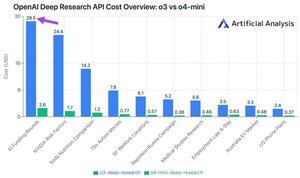

A nova API de Pesquisa Profunda da OpenAI custa até ~$30 por chamada de API! Esses novos endpoints da API de Pesquisa Profunda podem ser apenas a nova maneira mais rápida de gastar dinheiro

Em nossas 10 consultas de teste de pesquisa profunda, gastamos US $ 100 no o3 e US $ 9,18 no o4-mini. Como é que os custos ficam tão elevados? Preços altos e milhões de tokens.

Esses endpoints são versões de o3 e o4-mini que foram RL'd para tarefas de pesquisa profunda. A disponibilidade via API permite que eles sejam usados com a ferramenta de pesquisa na web da OpenAI e fontes de dados personalizadas através de servidores MCP remotos.

O preço do O4-Mini-Deep-Research é 5x menor do que o preço do O3-Deep-Research. Em nossas consultas de teste, o o4-mini também parece usar menos tokens - ele é mais de 10x mais barato no total em nossas 10 consultas de teste.

Preços:

➤ A pesquisa profunda de o3 custa US$ 10 /M de entrada (US$ 2,50 de entrada em cache), US$ 40/M de saída

➤ o4-mini-deep-research custa $2 /M de entrada ($0,5 entrada em cache), $8 /M de saída

Esses endpoints são substancialmente mais caros do que os endpoints padrão o3 e o4-mini da OpenAI - esses estão em:

➤ o3: entrada de US$ 2 /M (US$ 0,5 em cache), saída de US$ 8 /M para o3

➤ o4-mini: entrada de $1.1 /M (0.275 em cache), $4.4 /M de saída

37,34K

Top

Classificação

Favoritos

Tendências on-chain

Popular no X

Principais financiamentos atuais

Mais notável