Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Artificial Analysis

Oberoende analys av AI-modeller och hostingleverantörer - välj den bästa modellen och API-leverantören för ditt användningsfall

DeepSeek lanserar V3.1 och förenar V3 och R1 till en hybrid resonemangsmodell med en inkrementell ökning av intelligensen

Ökning av inkrementell intelligens: Initiala benchmarkingresultat för DeepSeek V3.1 visar Artificial Analysis Intelligence Index på 60 i resonemangsläge, upp från R1:s poäng på 59. I icke-resonemangsläge uppnår V3.1 en poäng på 49, en större ökning från den tidigare V3 0324-poängen på 44. Detta lämnar V3.1 (resonemang) bakom Alibabas senaste Qwen3 235B 2507 (resonemang) - DeepSeek har inte tagit tillbaka ledningen.

Hybridresonemang: @deepseek_ai har för första gången gått över till en hybridmodell för resonemang - med stöd för både resonemang och icke-resonemang. DeepSeeks övergång till en enhetlig hybridresonemangsmodell efterliknar det tillvägagångssätt som OpenAI, Anthropic och Google har antagit. Det är dock intressant att notera att Alibaba nyligen övergav sin hybridmetod som de föredrog för Qwen3 med sina separata utgåvor av Qwen3 2507 resonemangs- och instruktionsmodeller.

Funktionsanrop / verktygsanvändning: Medan DeepSeek hävdar förbättrad funktionsanrop för modellen, stöder DeepSeek V3.1 inte funktionsanrop i resonemangsläge. Detta kommer sannolikt att avsevärt begränsa dess förmåga att stödja agentiska arbetsflöden med intelligenskrav, inklusive kodning av agenter.

Tokenanvändning: DeepSeek V3.1 får stegvis högre poäng i resonemangsläge än DeepSeek R1 och använder något färre tokens över de val vi använder för Artificial Analysis Intelligence Index. I icke-resonemangsläge använder den något fler tokens än V3 0324 - men fortfarande flera gånger färre än i sitt eget resonemangsläge.

API: DeepSeeks förstaparts-API betjänar nu den nya DeepSeek V3.1-modellen på både deras chatt- och resonemangsslutpunkter - och ändrar helt enkelt om sluttänkartoken </think> tillhandahålls till modellen i chattmallen för att kontrollera om modellen kommer att resonera.

Arkitektur: DeepSeek V3.1 är arkitektoniskt identisk med tidigare V3- och R1-modeller, med totalt 671B parametrar och 37B aktiva parametrar.

Konsekvenser: Vi skulle råda till försiktighet med att göra några antaganden om vad denna utgåva innebär om DeepSeeks framsteg mot en framtida modell som i rykten kallas V4 eller R2. Vi noterar att DeepSeek tidigare släppte den slutliga modellen byggd på deras V2-arkitektur den 10 december 2024, bara två veckor innan de släppte V3.

71,11K

Vi presenterar Artificial Analysis Long Context Reasoning (AA-LCR), ett nytt riktmärke för att utvärdera prestanda för lång kontext genom att testa resonemangsfunktioner i flera långa dokument (~100k tokens)

Fokus för AA-LCR är att replikera verkligt kunskapsarbete och resonemangsuppgifter, testkapacitet som är avgörande för moderna AI-applikationer som spänner över dokumentanalys, kodbasförståelse och komplexa arbetsflöden i flera steg.

AA-LCR är 100 hårda textbaserade frågor som kräver resonemang i flera verkliga dokument som representerar ~100k indatatoken. Frågorna är utformade så att svaren inte kan hittas direkt utan måste motiveras utifrån flera informationskällor, med mänskliga tester som verifierar att varje fråga kräver genuin slutsats snarare än hämtning.

Viktigt att ta med sig:

➤ Dagens ledande modeller uppnår ~70 % noggrannhet: de tre översta platserna går till OpenAI o3 (69 %), xAI Grok 4 (68 %) och Qwen3 235B 2507 Thinking (67 %)

👀 ➤ Vi har också redan gpt-oss-resultat! 120B presterar nära o4-mini (hög), i linje med OpenAI:s påståenden om modellprestanda. Vi kommer inom kort att följa upp med ett Intelligence Index för modellerna.

➤ 100 hårdtextbaserade frågor som spänner över 7 kategorier av dokument (företagsrapporter, branschrapporter, statliga samråd, akademi, juridik, marknadsföringsmaterial och undersökningsrapporter)

➤ ~100K tokens av input per fråga, vilket kräver att modeller stöder ett minst 128K kontextfönster för att få poäng på detta riktmärke

➤ ~3 miljoner totala unika indatatoken som sträcker sig över ~230 dokument för att köra riktmärket (utdatatoken varierar vanligtvis beroende på modell)

➤ Länk till dataset om 🤗 @HuggingFace finns nedan

Vi lägger till AA-LCR i Artificial Analysis Intelligence Index och tar versionsnumret till v2.2. Artificial Analysis Intelligence Index v2.2 inkluderar nu: MMLU-Pro, GPQA Diamond, AIME 2025, IFBench, LiveCodeBench, SciCode och AA-LCR.

Alla siffror är uppdaterade på sajten nu. Ta reda på vilka modeller Artificial Analysis Intelligence Index v2.2 👇

28,8K

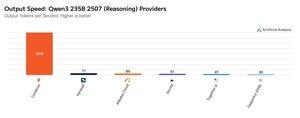

Cerebras har demonstrerat sin förmåga att vara värd för stora MoE-enheter med mycket höga hastigheter den här veckan och lanserat Qwen3 235B 2507- och Qwen3 Coder 480B-slutpunkter på >1 500 output-tokens/s

➤ @CerebrasSystems erbjuder nu slutpunkter för både Qwen3 235B 2507 Reasoning och Non-reasoning. Båda modellerna har totalt 235B parametrar med 22B aktiva.

➤ Qwen 3 235B 2507 Reasoning erbjuder intelligens jämförbar med o4-mini (hög) och DeepSeek R1 0528. Den icke-resonerande varianten erbjuder intelligens som är jämförbar med Kimi K2 och långt över GPT-4.1 och Llama 4 Maverick.

➤ Qwen3 Coder 480B har 480B totala parametrar med 35B aktiv. Den här modellen är särskilt stark för agentkodning och kan användas i en mängd olika kodningsagentverktyg, inklusive Qwen3-Coder CLI.

Cerebras lanseringar representerar första gången som denna nivå av intelligens har varit tillgänglig vid dessa utgångshastigheter och har potential att låsa upp nya användningsfall - som att använda en resonemangsmodell för varje steg av en agent utan att behöva vänta minuter.

25,29K

Topp

Rankning

Favoriter