Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Max Ryabinin

Aprendizaje profundo a gran escala e investigación @togethercompute

Learning@home/Autor de Hivemind (DMoE, DeDLOC, SWARM, Petals)

Doctorado en DL descentralizado '2023

¡Si estás en ICML y te interesa la inferencia verificable, asegúrate de pasar por nuestro póster!

Presentaremos TOPLOC, un método eficiente de hashing de activación que funciona en una variedad de configuraciones, por ejemplo, cambiando configuraciones de inferencia o incluso modelos.

16 de julio, 4:30 p.m., E-1106

1,46K

Desde mi experiencia, conseguir que un artículo sobre DL descentralizado sea aceptado en conferencias de alto nivel puede ser bastante difícil. La motivación no es familiar para muchos revisores, y los ajustes experimentales estándar no tienen en cuenta los problemas que intentas resolver.

Por lo tanto, estoy muy emocionado de ver a empresas como @PluralisHQ y @PrimeIntellect invirtiendo el esfuerzo para compartir sus resultados y publicarlos en conferencias importantes. En mi opinión, incluso preparar la presentación te obliga a ser más riguroso con tus experimentos y la retroalimentación externa de los revisores te ayuda a afinar el mensaje del artículo.

Alexander Long14 jul, 08:24

Para las personas que no están familiarizadas con la publicación de IA; hay 3 conferencias principales cada año. ICML, ICLR y NeurIPS. Estas son conferencias técnicas y el equivalente a revistas en otras disciplinas: son el principal lugar de publicación para la IA. La competencia para tener artículos en estas conferencias ahora está en un nivel ridículo, conseguir que acepten artículos es muy difícil, y hay mucha preocupación sobre el proceso de revisión, que en este momento es bastante ruidoso. Un artículo sólido sin fallos tiene alrededor de un 50% de posibilidades de ser aceptado, y típicamente un artículo se presenta con cambios de los revisores varias veces hasta que es aceptado. A pesar de todo eso, los artículos en estos lugares siguen siendo el principal sello de legitimidad en el mundo de la IA, y probablemente siguen siendo las principales métricas de carrera para los investigadores de ML (aunque esto está debilitándose, en mi opinión, ya que gran parte de la investigación en los laboratorios de frontera no está publicada).

Los artículos de la pista principal son significativamente diferentes a los artículos de los talleres. La pista principal tiene una revisión por pares intensa y seria. Los artículos de los talleres son para trabajos preliminares, que dan alguna indicación de un resultado interesante, pero que están incompletos o el resultado no es lo suficientemente significativo para la pista principal. Solo se requiere que sean revisados por el grupo de revisores del taller y no aparecen en las actas.

Muchos grandes artículos han aparecido por primera vez en talleres (por ejemplo, grokking) - pero los artículos de talleres y de la pista principal son cosas fundamentalmente diferentes, con un nivel de impacto fundamentalmente diferente. Las únicas dos empresas en IA descentralizada que tienen artículos de la pista principal este año son @PrimeIntellect y Pluralis.

7,34K

Max Ryabinin republicó

@gowthami_s @JangLawrenceK @IAmTimNguyen @ishapuri101 Entrenamiento distribuido en aprendizaje🌍 automático

Únase a nosotros el 12 de julio mientras @Ar_Douillard explora métodos clave como FSDP, Pipeline y Expert Parallelism, además de enfoques emergentes como DiLoCo y SWARM, superando los límites de la capacitación global y distribuida.

Aprende más:

7,27K

¡Muchas gracias a Ferdinand por organizar esta conversación! Fue una gran oportunidad para repasar todas las partes de SWARM y discutir la motivación detrás de ellas en profundidad.

¡Espero que este video haga que el DL descentralizado sea más accesible: muchas ideas en el campo son más simples de lo que parecen!

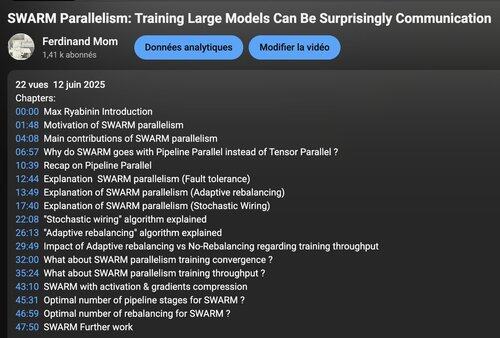

Ferdinand Mom12 jun 2025

¡La revisión en video del artículo de investigación sobre "Paralelismo de Enjambre" junto con el autor @m_ryabinin, Científico Investigador Distinguido @togethercompute ya está disponible! Enlace abajo 👇

Para dar contexto, la mayoría de los entrenamientos descentralizados hoy en día siguen enfoques estilo DDP que requieren una replicación completa del modelo en cada nodo. Si bien es práctico para aquellos que tienen clústeres H100 a su disposición, esto sigue estando fuera del alcance de la gran mayoría de los posibles contribuyentes, ¡aquí es donde SWARM resulta útil!

3,15K

Parte superior

Clasificación

Favoritos

En tendencia on-chain

En tendencia en X

Principales fondos recientes

Más destacado