Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Max Ryabinin

Deep learning e ricerca su larga scala @togethercompute

Learning@home/Autore di Hivemind (DMoE, DeDLOC, SWARM, Petals)

Dottorato di ricerca in DL decentrato '2023

Se sei all'ICML e sei interessato all'inferenza verificabile, assicurati di passare dal nostro poster!

Presenteremo TOPLOC, un metodo di hashing delle attivazioni efficiente che funziona in una varietà di contesti, ad esempio cambiando le configurazioni di inferenza o anche i modelli.

16 luglio, 16:30, E-1106

1,45K

Dalla mia esperienza, far accettare un articolo sulla DL decentralizzata a conferenze di alto livello può essere piuttosto difficile. La motivazione non è familiare a molti revisori, e le impostazioni standard degli esperimenti non tengono conto dei problemi che intendi risolvere.

Pertanto, sono molto entusiasta di vedere aziende come @PluralisHQ e @PrimeIntellect investire sforzi per condividere i loro risultati e farli pubblicare in conferenze importanti! IMO anche preparare la sottomissione ti costringe a essere più rigoroso riguardo ai tuoi esperimenti + il feedback esterno dei revisori ti aiuta a affinare il messaggio dell'articolo.

Alexander Long14 lug, 08:24

Per le persone che non sono familiari con la pubblicazione AI; ci sono 3 conferenze principali ogni anno. ICML, ICLR e NeurIPS. Queste sono conferenze tecniche e l'equivalente di riviste in altre discipline - sono il principale luogo di pubblicazione per l'AI. La competizione per avere articoli a queste conferenze è ora a un livello ridicolo, ottenere l'accettazione degli articoli è molto difficile e c'è molta preoccupazione riguardo al processo di revisione che è piuttosto rumoroso in questo momento. Un articolo forte senza difetti ha circa il 50% di possibilità di essere accettato e tipicamente un articolo viene inviato con modifiche dei revisori diverse volte fino a quando non viene accettato. Nonostante tutto ciò, gli articoli in questi luoghi rimangono il principale timbro di legittimità nel mondo dell'AI e probabilmente sono ancora le principali metriche di carriera per i ricercatori di ML (anche se questo sta indebolendosi secondo me poiché gran parte della ricerca nei laboratori all'avanguardia non è pubblicata).

Gli articoli del Main Track sono significativamente diversi dagli articoli dei workshop. Il main track ha una revisione tra pari intensa e seria. Gli articoli dei workshop sono per lavori preliminari, che danno qualche indicazione di un risultato interessante, ma non sono completi o il risultato non è abbastanza significativo per il main track. Devono essere solo revisionati dal pool di revisori del workshop e non appaiono negli atti.

Molti grandi articoli sono stati presentati per la prima volta nei workshop (ad es. grokking) - ma gli articoli dei workshop e del main track sono fondamentalmente cose diverse, con un livello di impatto fondamentalmente diverso. Le uniche due aziende nell'AI decentralizzata che hanno articoli del main track quest'anno sono @PrimeIntellect e Pluralis.

7,33K

Max Ryabinin ha ripubblicato

@gowthami_s @JangLawrenceK @IAmTimNguyen @ishapuri101 Formazione distribuita in Machine Learning🌍

Unisciti a noi il 12 luglio mentre @Ar_Douillard esplora metodi chiave come FSDP, Pipeline e Expert Parallelism, oltre ad approcci emergenti come DiLoCo e SWARM, spingendo i limiti della formazione globale e distribuita.

Ulteriori informazioni:

7,27K

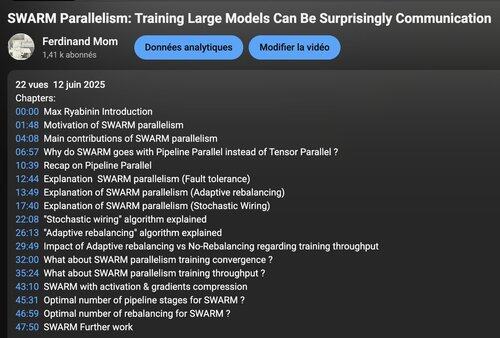

Grazie mille a Ferdinand per aver ospitato questa conversazione! È stata una grande opportunità per rivedere tutte le parti di SWARM e discutere a fondo la motivazione dietro di esse.

Spero che questo video renda il DL decentralizzato più accessibile: molte idee nel campo sono più semplici di quanto sembrino!

Ferdinand Mom12 giu 2025

La recensione video del documento di ricerca su "Swarm Parallelism" insieme all'autore @m_ryabinin, Distinguished Research Scientist @togethercompute è ora disponibile! Link qui sotto 👇

Per contesto, la maggior parte dei training decentralizzati oggi segue approcci in stile DDP che richiedono una replica completa del modello su ogni nodo. Sebbene sia pratico per coloro che hanno cluster H100 a disposizione, questo rimane fuori portata per la stragrande maggioranza dei potenziali contributori, ed è qui che SWARM si rivela utile!

3,15K

Principali

Ranking

Preferiti

On-chain di tendenza

Di tendenza su X

Principali fondi recenti

Più popolari