Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

La carrera por el "núcleo cognitivo" de LLM - un modelo de unos pocos miles de millones de parámetros que sacrifica al máximo el conocimiento enciclopédico por capacidad. Vive siempre activo y, por defecto, en cada computadora como el núcleo de la computación personal LLM.

Sus características se están cristalizando lentamente:

- Multimodal nativo de texto/visión/audio tanto en entrada como en salida.

- Arquitectura estilo Matryoshka que permite ajustar la capacidad hacia arriba y hacia abajo en el momento de la prueba.

- Razonamiento, también con un dial. (sistema 2)

- Uso agresivo de herramientas.

- Slots de LoRA para ajuste fino en el dispositivo para entrenamiento en el momento de la prueba, personalización y customización.

- Delegados y verifica solo las partes correctas con los oráculos en la nube si hay internet disponible.

No sabe que el reinado de Guillermo el Conquistador terminó el 9 de septiembre de 1087, pero reconoce vagamente el nombre y puede buscar la fecha. No puede recitar el SHA-256 de la cadena vacía como e3b0c442..., pero puede calcularlo rápidamente si realmente lo deseas.

Lo que la computación personal LLM carece en conocimiento amplio del mundo y capacidad de resolución de problemas de primer nivel, lo compensará con una latencia de interacción super baja (especialmente a medida que lo multimodal madure), acceso directo / privado a datos y estado, continuidad offline, soberanía ("no tus pesos, no tu cerebro"). Es decir, muchas de las mismas razones por las que nos gustan, usamos y compramos computadoras personales en lugar de tener clientes ligeros que accedan a la nube a través de escritorio remoto o algo así.

27 jun 2025

¡Estoy muy emocionado de anunciar que Gemma 3n ya está aquí! 🎉

🔊 Comprensión multimodal (texto/audio/imagen/video)

🤯 Funciona con tan solo 2GB de RAM

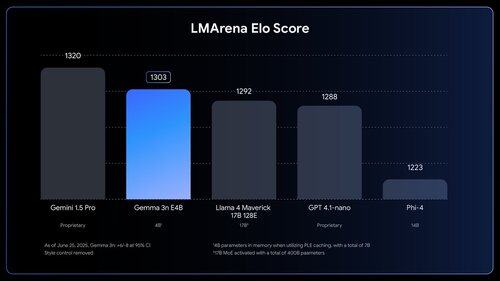

🏆 Primer modelo por debajo de 10B con una puntuación de @lmarena_ai de 1300+

Disponible ahora en @huggingface, @kaggle, llama.cpp, y más.

¿La gente *siente* cuánto trabajo queda por hacer? Como, wow.

1,03M

Parte superior

Clasificación

Favoritos