Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Wyścig o "kognitywne jądro" LLM - model z kilkoma miliardami parametrów, który maksymalnie poświęca encyklopedyczną wiedzę na rzecz zdolności. Żyje zawsze włączony i domyślnie na każdym komputerze jako jądro osobistego przetwarzania LLM.

Jego cechy powoli się krystalizują:

- Natywna multimodalność tekstu/wizji/dźwięku zarówno na wejściu, jak i wyjściu.

- Architektura w stylu matrioszki, pozwalająca na regulację zdolności w górę i w dół w czasie testu.

- Rozumowanie, również z regulacją. (system 2)

- Agresywne korzystanie z narzędzi.

- Sloty LoRA do dostrajania na urządzeniu na potrzeby treningu w czasie testu, personalizacji i dostosowywania.

- Deleguje i podwójnie sprawdza tylko te odpowiednie części z oraklami w chmurze, jeśli internet jest dostępny.

Nie wie, że panowanie Wilhelma Zdobywcy zakończyło się 9 września 1087 roku, ale w pewnym sensie rozpoznaje to imię i może sprawdzić datę. Nie potrafi recytować SHA-256 pustego ciągu jako e3b0c442..., ale może to szybko obliczyć, jeśli naprawdę tego chcesz.

Czego osobiste przetwarzanie LLM brakuje w szerokiej wiedzy o świecie i najwyższej klasy zdolności rozwiązywania problemów, to nadrobi w super niskiej latencji interakcji (szczególnie w miarę dojrzewania multimodalności), bezpośrednim / prywatnym dostępie do danych i stanu, offline'owej ciągłości, suwerenności ("nie twoje wagi, nie twój mózg"). tzn. wiele z tych samych powodów, dla których lubimy, używamy i kupujemy komputery osobiste zamiast mieć cienkie klienty uzyskujące dostęp do chmury przez zdalny pulpit lub coś w tym stylu.

27 cze 2025

Jestem bardzo podekscytowany, aby ogłosić, że Gemma 3n jest już tutaj! 🎉

🔊 Zrozumienie multimodalne (tekst/audio/obraz/wideo)

🤯 Działa przy zaledwie 2 GB RAM

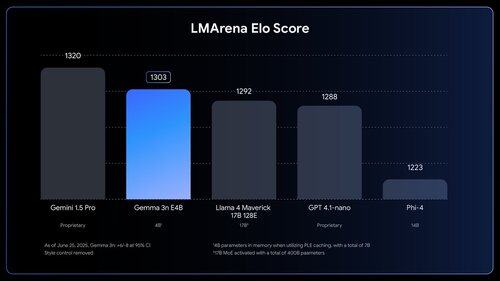

🏆 Pierwszy model poniżej 10B z wynikiem @lmarena_ai wynoszącym 1300+

Dostępny teraz na @huggingface, @kaggle, llama.cpp i innych.

Czy ludzie *czują*, ile pracy jeszcze zostało do zrobienia. Jak wow.

1,03M

Najlepsze

Ranking

Ulubione