Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Shane Gu

Gemini - RL, CoT, multilinguisme. Cadre supérieur RS @GoogleDeepMind MTV. 🇯🇵 -né 🇨🇳🇨🇦 . ex : @OpenAI (JP : @shanegJP)

Shane Gu a reposté

🚨 Mathématiques Olympiques + IA :

Nous avons exécuté le Gemini 2.5 Pro de Google sur les nouveaux problèmes de l'IMO 2025. Avec un prompt soigneusement conçu et une architecture bien pensée, il a résolu 5 problèmes sur 6 — remarquable pour des tâches nécessitant une profonde compréhension et créativité.

Le modèle pourrait gagner de l'or ! 🥇

#IA #Math #LLMs #IMO2025

116,76K

Asiatiques : nous allons régler notre propre désordre

Patrick Shen18 juil., 03:03

Lors de leur lancement, Cluely a affirmé qu'il tuerait 9 industries.

Nous sommes ici pour en tuer juste une : la tricherie.

Découvrez Truely — l'outil open-source qui signale les entretiens assistés par IA en temps réel. Fonctionne avec Zoom, Meets, Teams, et plus encore.

L'avenir des entretiens en ligne est là.

1,98K

Pour combattre les Asiatiques, vous avez besoin d'Asiatiques.

Patrick Shen18 juil., 03:03

Lors de leur lancement, Cluely a affirmé qu'il tuerait 9 industries.

Nous sommes ici pour en tuer juste une : la tricherie.

Découvrez Truely — l'outil open-source qui signale les entretiens assistés par IA en temps réel. Fonctionne avec Zoom, Meets, Teams, et plus encore.

L'avenir des entretiens en ligne est là.

222

Pourquoi les équipes de pré-formation et de post-formation doivent s'entendre

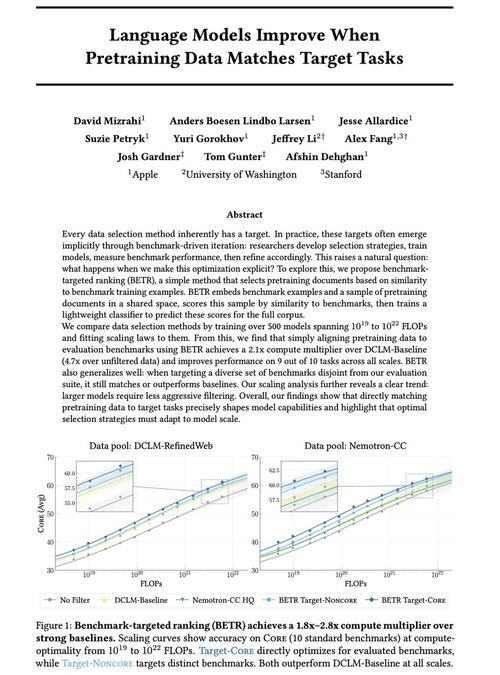

David Mizrahi18 juil., 06:21

Excité de partager notre nouveau travail : « Les modèles de langage s'améliorent lorsque les données de préentraînement correspondent aux tâches cibles »

Oui, cela semble évident (et c'est le cas !), mais cela se produit généralement de manière implicite et indirecte : sélectionner intuitivement des données → évaluation → affiner → répéter.

Nous nous sommes demandé : que se passe-t-il si nous faisons correspondre explicitement les données de préentraînement aux évaluations ? Le résultat est une approche très simple qui offre des multiplicateurs de calcul de 2x+ par rapport à de solides références et nous donne un moyen fondamental d'étudier comment les choix d'évaluation façonnent (et contraignent !) les capacités des modèles.

Bonus : des lois d'échelle étendues provenant de l'entraînement de plus de 500 modèles qui révèlent comment la sélection optimale des données évolue à mesure que les modèles se développent.

🧵 (1/14)

2,65K

L'équipe Grok internalise les opérations de données humaines (par exemple, le recrutement pour le rôle de tuteur IA pour le japonais). Il est probable que d'autres laboratoires de pointe envisagent de posséder et d'exploiter le travail des données.

Koki Ikeda | SoftBank15 juil., 22:12

"xAI," qui développe Grok, recherche un tuteur IA japonais.

Le poste consiste à étiqueter et annoter des données textuelles, audio et vidéo en japonais. Vous pouvez travailler entièrement à distance depuis le Japon, et le salaire est à un taux horaire élevé équivalent aux normes américaines.

🗣️ Locuteur natif japonais

🧑💻 Entièrement à distance

💰 Taux horaire de 35 à 65 $ (5200-9600 yens)

🕐 Contrat de 6 mois (avec possibilité de prolongation)

8,36K

L'équipe Grok internalise les opérations de données humaines (par exemple, le recrutement pour le rôle de tuteur IA pour le japonais). Étant donné la transition de Scale AI, il est probable que davantage de laboratoires de pointe envisagent de posséder et d'exploiter le travail des données.

Koki Ikeda | SoftBank15 juil., 22:12

"xAI," qui développe Grok, recherche un tuteur IA japonais.

Le poste consiste à étiqueter et annoter des données textuelles, audio et vidéo en japonais. Vous pouvez travailler entièrement à distance depuis le Japon, et le salaire est à un taux horaire élevé équivalent aux normes américaines.

🗣️ Locuteur natif japonais

🧑💻 Entièrement à distance

💰 Taux horaire de 35 à 65 $ (5200-9600 yens)

🕐 Contrat de 6 mois (avec possibilité de prolongation)

297

Si vous êtes à l'ICML et intéressé par le RL ou la multilinguisme, n'hésitez pas à dire bonjour à @marafinkels ! Nous avons travaillé en étroite collaboration ces derniers mois pour expédier une méthode RL afin de résoudre un problème de qualité critique de Gemini. Elle a aussi de superbes idées de recherche ! J'espère que Gemini et le monde académique resteront en contact.

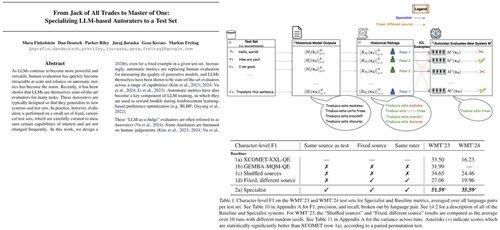

Mara Finkelstein27 nov. 2024

Les LLMs sont généralement évalués avec des métriques automatiques sur des ensembles de tests standard, mais les métriques et les ensembles de tests sont développés indépendamment. Cela soulève une question cruciale : Pouvons-nous concevoir des métriques automatiques spécifiquement pour exceller sur les ensembles de tests que nous priorisons ? Réponse : Oui !

5,73K

Shane Gu a reposté

Nouveau billet de blog sur l'asymétrie de la vérification et la "loi du vérificateur" :

L'asymétrie de la vérification – l'idée que certaines tâches sont beaucoup plus faciles à vérifier qu'à résoudre – devient une idée importante alors que nous avons enfin un apprentissage par renforcement qui fonctionne généralement.

De grands exemples d'asymétrie de vérification sont des choses comme les puzzles sudoku, l'écriture du code pour un site web comme Instagram, et les problèmes BrowseComp (il faut environ 100 sites web pour trouver la réponse, mais c'est facile à vérifier une fois que vous avez la réponse).

D'autres tâches ont une quasi-symétrie de vérification, comme la somme de deux nombres de 900 chiffres ou certains scripts de traitement de données. D'autres tâches sont beaucoup plus faciles à proposer comme solutions réalisables qu'à les vérifier (par exemple, vérifier les faits d'un long essai ou énoncer un nouveau régime comme "ne manger que du bison").

Une chose importante à comprendre sur l'asymétrie de la vérification est que vous pouvez améliorer l'asymétrie en effectuant un certain travail au préalable. Par exemple, si vous avez la clé de réponse à un problème mathématique ou si vous avez des cas de test pour un problème Leetcode. Cela augmente considérablement l'ensemble des problèmes avec une asymétrie de vérification souhaitable.

La "loi du vérificateur" stipule que la facilité d'entraînement de l'IA à résoudre une tâche est proportionnelle à la vérifiabilité de la tâche. Toutes les tâches qui peuvent être résolues et faciles à vérifier seront résolues par l'IA. La capacité d'entraîner l'IA à résoudre une tâche est proportionnelle à la mesure dans laquelle la tâche possède les propriétés suivantes :

1. Vérité objective : tout le monde s'accorde à dire ce que sont de bonnes solutions

2. Rapide à vérifier : toute solution donnée peut être vérifiée en quelques secondes

3. Évolutif à vérifier : de nombreuses solutions peuvent être vérifiées simultanément

4. Faible bruit : la vérification est aussi étroitement corrélée à la qualité de la solution que possible

5. Récompense continue : il est facile de classer la qualité de nombreuses solutions pour un seul problème

Une instantiation évidente de la loi du vérificateur est le fait que la plupart des benchmarks proposés en IA sont faciles à vérifier et ont jusqu'à présent été résolus. Remarquez que pratiquement tous les benchmarks populaires au cours des dix dernières années répondent aux critères #1-4 ; les benchmarks qui ne répondent pas aux critères #1-4 auraient du mal à devenir populaires.

Pourquoi la vérifiabilité est-elle si importante ? La quantité d'apprentissage en IA qui se produit est maximisée lorsque les critères ci-dessus sont satisfaits ; vous pouvez faire beaucoup d'étapes de gradient où chaque étape a beaucoup de signal. La vitesse d'itération est critique : c'est la raison pour laquelle les progrès dans le monde numérique ont été beaucoup plus rapides que les progrès dans le monde physique.

AlphaEvolve de Google est l'un des plus grands exemples d'exploitation de l'asymétrie de la vérification. Il se concentre sur des configurations qui répondent à tous les critères ci-dessus et a conduit à un certain nombre d'avancées en mathématiques et dans d'autres domaines. Différent de ce que nous avons fait en IA au cours des deux dernières décennies, c'est un nouveau paradigme dans lequel tous les problèmes sont optimisés dans un cadre où l'ensemble d'entraînement est équivalent à l'ensemble de test.

L'asymétrie de la vérification est partout et il est excitant de considérer un monde d'intelligence déchiquetée où tout ce que nous pouvons mesurer sera résolu.

298,72K

Un travail impactant que tout le monde peut faire est d'utiliser des LLM pour journaliser et numériser autant que possible votre flux de travail, vos CoTs et votre inspiration.

L'ingénierie contextuelle pour automatiser et augmenter votre vie et votre travail.

Thariq15 juil., 05:51

Journaux & À faire

J'ai quelques commandes personnalisées :

/ journal une commande qui créera une nouvelle entrée de journal pour la journée.

/ todos une commande qui me permettra de créer de nouvelles tâches à faire ou de marquer d'autres comme terminées. Les tâches à faire sont organisées par sujet dans des fichiers, par exemple ‘

Claude cherchera souvent dans mon code, mes projets, etc. pour plus de contexte lorsque j'ajoute une tâche à faire, ce qui est super utile.

798

Meilleurs

Classement

Favoris

Tendance on-chain

Tendance sur X

Récents financements de premier plan

Les plus notables