Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Shane Gu

Zwillinge - RL, CoT, Mehrsprachigkeit. Senior Staff RS @GoogleDeepMind MTV. 🇯🇵 -geboren 🇨🇳🇨🇦 . z.B.: @OpenAI (JP: @shanegJP)

Shane Gu erneut gepostet

🚨 Olympiade Mathematik + KI:

Wir haben Googles Gemini 2.5 Pro an den neuen IMO 2025 Aufgaben getestet. Mit sorgfältigem Prompting und Pipeline-Design hat es 5 von 6 gelöst – bemerkenswert für Aufgaben, die tiefes Verständnis und Kreativität erfordern.

Das Modell könnte Gold gewinnen! 🥇

#KI #Mathematik #LLMs #IMO2025

218,88K

Asiaten: Wir werden unser eigenes Chaos beheben.

Patrick Shen18. Juli, 03:03

Bei ihrer Einführung behauptete Cluely, es würde 9 Branchen töten.

Wir sind hier, um nur eine zu töten: Betrug.

Lernen Sie Truely kennen – das Open-Source-Tool, das KI-unterstützte Interviews in Echtzeit kennzeichnet. Funktioniert mit Zoom, Meets, Teams und mehr.

Die Zukunft der Online-Interviews ist hier.

2,01K

Um gegen Asiaten zu kämpfen, braucht man Asiaten.

Patrick Shen18. Juli, 03:03

Bei ihrer Einführung behauptete Cluely, es würde 9 Branchen töten.

Wir sind hier, um nur eine zu töten: Betrug.

Lernen Sie Truely kennen – das Open-Source-Tool, das KI-unterstützte Interviews in Echtzeit kennzeichnet. Funktioniert mit Zoom, Meets, Teams und mehr.

Die Zukunft der Online-Interviews ist hier.

241

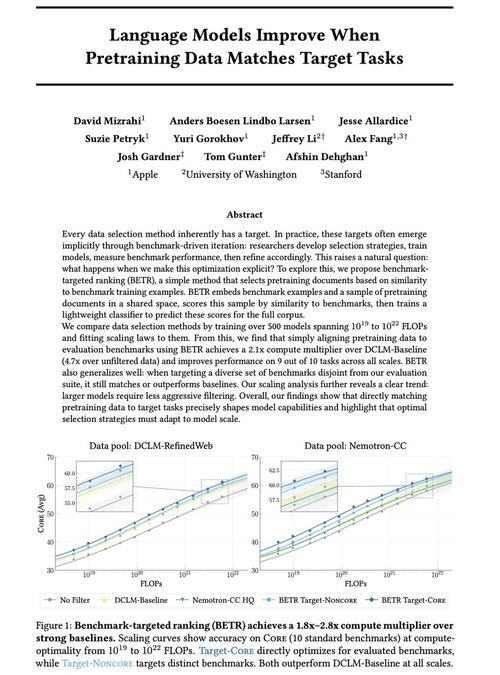

Warum die Pre-Training- und Post-Training-Teams gut miteinander auskommen müssen

David Mizrahi18. Juli, 06:21

Aufgeregt, unsere neue Arbeit zu teilen: „Sprachmodelle verbessern sich, wenn die Pretraining-Daten mit den Zielaufgaben übereinstimmen“

Ja, es klingt offensichtlich (und das ist es!), aber normalerweise geschieht dies nur implizit und indirekt: intuitiv Daten auswählen → Benchmark → verfeinern → wiederholen.

Wir haben uns gefragt: Was passiert, wenn wir die Pretraining-Daten explizit an Benchmarks anpassen? Das Ergebnis ist ein todsimple Ansatz, der 2x+ Rechenmultiplikatoren gegenüber starken Baselines liefert und uns eine fundierte Möglichkeit gibt, zu untersuchen, wie die Auswahl von Benchmarks die (und einschränkt!) Modellfähigkeiten formt.

Bonus: umfangreiche Skalierungsgesetze aus dem Training von über 500 Modellen, die zeigen, wie sich die optimale Datenauswahl entwickelt, während die Modelle skalieren.

🧵 (1/14)

2,68K

Das Grok-Team internalisiert die menschlichen Datenoperationen (z. B. Rekrutierung für die Rolle des KI-Tutors für Japanisch). Wahrscheinlich denken mehr Frontier-Labore darüber nach, die Datenarbeit zu besitzen und zu betreiben.

Koki Ikeda | SoftBank15. Juli, 22:12

"xAI," das Grok entwickelt, sucht einen japanischen AI-Tutor.

Die Aufgabe besteht darin, japanische Texte, Audio- und Videodaten zu kennzeichnen und zu annotieren. Sie können vollständig remote aus Japan arbeiten, und die Bezahlung liegt auf einem hohen Stundenlohn, der den amerikanischen Standards entspricht.

🗣️ Muttersprachler Japanisch

🧑💻 Vollständig remote

💰 Stundenlohn von 35–65 $ (5200-9600 Yen)

🕐 6-Monats-Vertrag (mit Möglichkeit zur Verlängerung)

8,38K

Das Grok-Team internalisiert die menschlichen Datenoperationen (z. B. Rekrutierung für die Rolle des KI-Tutors für Japanisch). Angesichts des Übergangs zu Scale AI denken wahrscheinlich mehr Frontier-Labore darüber nach, die Datenarbeit zu besitzen und zu betreiben.

Koki Ikeda | SoftBank15. Juli, 22:12

"xAI," das Grok entwickelt, sucht einen japanischen AI-Tutor.

Die Aufgabe besteht darin, japanische Texte, Audio- und Videodaten zu kennzeichnen und zu annotieren. Sie können vollständig remote aus Japan arbeiten, und die Bezahlung liegt auf einem hohen Stundenlohn, der den amerikanischen Standards entspricht.

🗣️ Muttersprachler Japanisch

🧑💻 Vollständig remote

💰 Stundenlohn von 35–65 $ (5200-9600 Yen)

🕐 6-Monats-Vertrag (mit Möglichkeit zur Verlängerung)

327

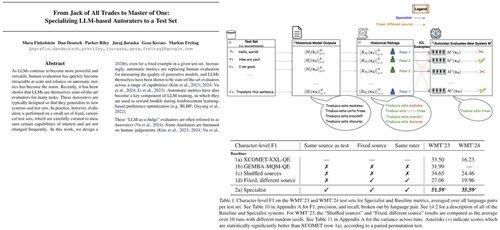

Wenn Sie auf der ICML sind und sich für RL oder Mehrsprachigkeit interessieren, sagen Sie bitte Hallo zu @marafinkels! Wir haben in den letzten Monaten eng zusammengearbeitet, um eine RL-Methode zu entwickeln, die ein kritisches Qualitätsproblem bei Gemini behebt. Sie hat auch großartige Forschungsideen! Ich hoffe, Gemini und die Akademie bleiben in Kontakt.

Mara Finkelstein27. Nov. 2024

LLMs werden typischerweise mit automatischen Metriken auf standardisierten Testsets bewertet, aber Metriken und Testsets werden unabhängig entwickelt. Dies wirft eine entscheidende Frage auf: Können wir automatische Metriken entwerfen, die speziell darauf ausgelegt sind, in den Testsets, die wir priorisieren, hervorragend abzuschneiden? Antwort: Ja!

5,76K

Shane Gu erneut gepostet

Neuer Blogbeitrag über die Asymmetrie der Verifikation und das "Gesetz des Verifiers":

Die Asymmetrie der Verifikation – die Idee, dass einige Aufgaben viel einfacher zu verifizieren sind als zu lösen – wird zu einem wichtigen Konzept, da wir RL haben, das endlich allgemein funktioniert.

Große Beispiele für die Asymmetrie der Verifikation sind Dinge wie Sudoku-Rätsel, das Schreiben des Codes für eine Website wie Instagram und BrowseComp-Probleme (es dauert ~100 Websites, um die Antwort zu finden, aber es ist einfach zu verifizieren, sobald man die Antwort hat).

Andere Aufgaben haben eine nahezu Symmetrie der Verifikation, wie das Summieren von zwei 900-stelligen Zahlen oder einige Datenverarbeitungsskripte. Wieder andere Aufgaben sind viel einfacher, um machbare Lösungen vorzuschlagen, als sie zu verifizieren (z. B. das Überprüfen eines langen Aufsatzes oder das Nennen einer neuen Diät wie "nur Bison essen").

Eine wichtige Sache, die man über die Asymmetrie der Verifikation verstehen sollte, ist, dass man die Asymmetrie verbessern kann, indem man im Voraus etwas Arbeit leistet. Zum Beispiel, wenn man den Antwortschlüssel zu einem Mathematikproblem hat oder wenn man Testfälle für ein Leetcode-Problem hat. Dies erhöht erheblich die Menge an Problemen mit wünschenswerter Verifikationsasymmetrie.

Das "Gesetz des Verifiers" besagt, dass die Leichtigkeit, KI zu trainieren, um eine Aufgabe zu lösen, proportional dazu ist, wie verifizierbar die Aufgabe ist. Alle Aufgaben, die lösbar und einfach zu verifizieren sind, werden von KI gelöst. Die Fähigkeit, KI zu trainieren, um eine Aufgabe zu lösen, ist proportional dazu, ob die Aufgabe die folgenden Eigenschaften hat:

1. Objektive Wahrheit: Jeder ist sich einig, was gute Lösungen sind.

2. Schnell zu verifizieren: Jede gegebene Lösung kann in wenigen Sekunden verifiziert werden.

3. Skalierbar zu verifizieren: Viele Lösungen können gleichzeitig verifiziert werden.

4. Geringes Rauschen: Die Verifikation ist so eng wie möglich mit der Lösungsqualität korreliert.

5. Kontinuierliche Belohnung: Es ist einfach, die Güte vieler Lösungen für ein einzelnes Problem zu bewerten.

Eine offensichtliche Veranschaulichung des Gesetzes des Verifiers ist die Tatsache, dass die meisten Benchmarks, die in der KI vorgeschlagen werden, einfach zu verifizieren sind und bisher gelöst wurden. Beachten Sie, dass praktisch alle beliebten Benchmarks der letzten zehn Jahre die Kriterien #1-4 erfüllen; Benchmarks, die die Kriterien #1-4 nicht erfüllen, würden Schwierigkeiten haben, populär zu werden.

Warum ist Verifizierbarkeit so wichtig? Die Menge des Lernens in der KI, die stattfindet, wird maximiert, wenn die oben genannten Kriterien erfüllt sind; man kann viele Gradienten-Schritte machen, bei denen jeder Schritt viel Signal hat. Die Geschwindigkeit der Iteration ist entscheidend – sie ist der Grund, warum der Fortschritt in der digitalen Welt so viel schneller war als der Fortschritt in der physischen Welt.

AlphaEvolve von Google ist eines der größten Beispiele für die Nutzung der Asymmetrie der Verifikation. Es konzentriert sich auf Setups, die alle oben genannten Kriterien erfüllen, und hat zu einer Reihe von Fortschritten in der Mathematik und anderen Bereichen geführt. Anders als das, was wir in der KI in den letzten zwei Jahrzehnten gemacht haben, ist es ein neues Paradigma, bei dem alle Probleme in einem Setting optimiert werden, in dem der Trainingssatz dem Testsatz entspricht.

Die Asymmetrie der Verifikation ist überall und es ist aufregend, sich eine Welt mit gezackter Intelligenz vorzustellen, in der alles, was wir messen können, gelöst wird.

298,73K

Wirkungsvolle Arbeit, die jeder leisten kann, besteht darin, LLMs zu nutzen, um so viel wie möglich von Ihrem Workflow, CoTs und Ihrer Inspiration zu journalisieren und zu digitalisieren.

Kontextengineering zur Automatisierung und Erweiterung Ihrer selbst im Leben und bei der Arbeit.

Thariq15. Juli, 05:51

Journale & Aufgaben

Ich habe ein paar benutzerdefinierte Befehle:

/journal-Befehl, der einen neuen Journaleintrag für den Tag erstellt.

/todos ein Befehl, der es mir ermöglicht, neue Aufgaben zu erstellen oder andere als erledigt zu markieren. Aufgaben sind nach Themen in Dateien organisiert, z.B. ‘

Claude wird oft meinen Code, Projekte usw. durchsuchen, um mehr Kontext zu erhalten, wenn ich eine Aufgabe hinzufüge, was super hilfreich ist.

817

Top

Ranking

Favoriten

Onchain-Trends

Im Trend auf X

Aktuelle Top-Finanzierungen

Am bemerkenswertesten