Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Pourquoi les équipes de pré-formation et de post-formation doivent s'entendre

18 juil., 06:21

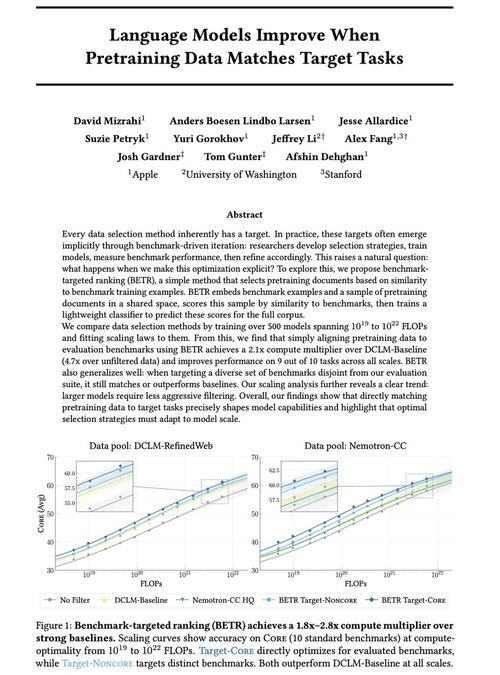

Excité de partager notre nouveau travail : « Les modèles de langage s'améliorent lorsque les données de préentraînement correspondent aux tâches cibles »

Oui, cela semble évident (et c'est le cas !), mais cela se produit généralement de manière implicite et indirecte : sélectionner intuitivement des données → évaluation → affiner → répéter.

Nous nous sommes demandé : que se passe-t-il si nous faisons correspondre explicitement les données de préentraînement aux évaluations ? Le résultat est une approche très simple qui offre des multiplicateurs de calcul de 2x+ par rapport à de solides références et nous donne un moyen fondamental d'étudier comment les choix d'évaluation façonnent (et contraignent !) les capacités des modèles.

Bonus : des lois d'échelle étendues provenant de l'entraînement de plus de 500 modèles qui révèlent comment la sélection optimale des données évolue à mesure que les modèles se développent.

🧵 (1/14)

2,69K

Meilleurs

Classement

Favoris