Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

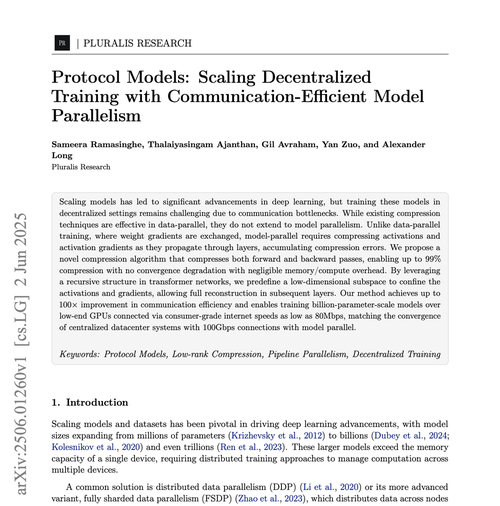

Pluralis Research

Apprendimento del protocollo

Pluralis Research ha ripubblicato

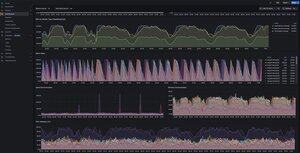

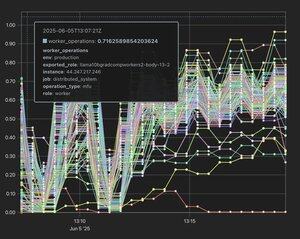

Utilizzando bellissimi dashboard Grafana per tutto internamente, molto più belli di Tensorboard. Wandb è ancora buono ma non funziona davvero con l'addestramento decentralizzato. Mi fa chiedere com'è lo strumento di visualizzazione interno in openai - deve essere incredibile.

3,04K

Abbiamo raggiunto un importante traguardo nell'addestramento completamente decentralizzato: per la prima volta, abbiamo dimostrato che un modello linguistico di grandi dimensioni può essere suddiviso e addestrato su dispositivi consumer connessi a Internet, senza perdita di velocità o prestazioni.

161,09K

Pluralis Research ha ripubblicato

Probabilmente la più grande settimana di formazione decentralizzata fino ad oggi dopo l'ICLR e altre stanno per uscire. Riassunto della situazione attuale:

1. La post-formazione RL decentralizzata sta chiaramente funzionando. @gensynai le ultime notizie con ottimi risultati qui. Questo processo prende un modello di base forte, ne dà copie ai partecipanti che generano tracce di ragionamento che vengono poi raccolte e utilizzate per migliorare il modello di base. Questo ovviamente si basa sul fatto che i modelli base siano disponibili/a peso aperto, ed è significativamente più economico del Pretraining. I nodi devono solo fare inferenza. Lo svantaggio è che ci sono prove crescenti (ed è molto intuitivo) che non è possibile superare un modello base difettoso. Quindi si mantiene una dipendenza. Dobbiamo aspettare i risultati di queste corse, ma la realtà è che questo funzionerà in un modo o nell'altro perché il processo è così banalmente parallizzabile.

2. Il pre-addestramento con parallelo ai dati (DP) sembra buono. Sia @NousResearch che @PrimeIntellect hanno già risultati qui con modelli in scala 10B. Sarà molto semplice (ma costoso per gli operatori dei nodi) estendere questo al caso 100B. Questo perché in DP ogni nodo conserva una copia completa del modello, quindi sono necessari ad esempio 8xh100s per allenarsi alla dimensione 10b; Non puoi usare carte piccole. Quindi puoi semplicemente estendere questa tecnica aumentando le dimensioni dei nodi ed eseguire l'addestramento collaborativo tra datacenter (ad esempio, ogni nodo è composto da circa 100 H100 e ti addestri >modello 100b). Hai anche il problema che tutti vedono una copia completa del modello, quindi non è chiaro come monetizzare (Protocol Learning risolve questo problema).

3. Il modello parallelo (in cui il modello stesso è suddiviso in nodi - pensa a 1000 Macbook geograficamente separati che addestrano un modello di parametro 100b, in cui ogni dispositivo ha solo una piccola parte del modello totale) ha iniziato a mostrare i primi sentori di essere possibile. Abbiamo (@PluralisHQ) pubblicato l'articolo "Beyond Top k" che comprime le comunicazioni tra i nodi oltre il 90%, così come altri due lavori che dimostrano che è possibile utilizzare dispositivi eterogenei in una configurazione Pipeline Parallel (PP). Abbiamo anche fatto accettare il nostro metodo Nesterov per la PP in ICML2025, che, per quanto ne so, è il primo documento sull'addestramento decentralizzato accettato in una grande conferenza sull'IA dopo l'articolo originale di SWARM, e dovrebbe aiutare a catalizzare l'interesse dei circoli tradizionali dell'IA.

Il modello parallelo decentralizzato è risolto → NO. La larghezza di banda di comunicazione è molto peggiore rispetto a un data center, che anche il 90% non è sufficiente. Dobbiamo arrivare a circa 300 volte la compressione per raggiungere la parità con l'allenamento centralizzato. Rimane un'enorme domanda se questo sia possibile: stai distruggendo così tanto del segnale di allenamento in questo modo. Questo è l'obiettivo di Pluralis.

Tuttavia, cosa succede se funziona? Per la prima volta, è possibile fare un vero e proprio pretraining collaborativo. Non c'è dipendenza da deepseek o Meta. I singoli utenti possono combinare il calcolo per creare modelli su questa scala, da zero. Otteniamo una vera e propria innovazione guidata dalla comunità in un modo che non è mai esistito fino ad oggi. Il post-training decentralizzato basato su RL può quindi essere utilizzato per migliorare ulteriormente questi modelli.

La realtà è che siamo agli albori di qualcosa di estremamente significativo che sta accadendo qui. Questo sarà un campo importante. Le società di cui sopra stanno sparando a tutti i cilindri, un mucchio di altre sta per uscire dal cancello a breve, e non mi aspetto che questo rallenti affatto da ora fino a quando non accadrà qualunque cosa accada. E se stai leggendo questo articolo, sei in anticipo.

14,21K

Pluralis Research ha ripubblicato

Incredibile vedere il documento sul parallelismo della pipeline di Pluralis accettato in ICML.

ICML è una delle più grandi e rinomate conferenze sull'intelligenza artificiale al mondo, che quest'anno avrà un'importante rappresentanza di DeAI.

L'estate di DeAI sarà epica.

3,92K

1/2 Abbiamo esteso il nostro lavoro precedente nel regime data-parallel (in cui ogni nodo ha una copia completa del modello) al regime Model-Parallel. Questo è il primo lavoro, a parte l'articolo originale dello sciame, che si occupa dello scenario in cui il modello stesso viene frammentato sui dispositivi.

1,97K

Principali

Ranking

Preferiti

On-chain di tendenza

Di tendenza su X

Principali fondi recenti

Più popolari