Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

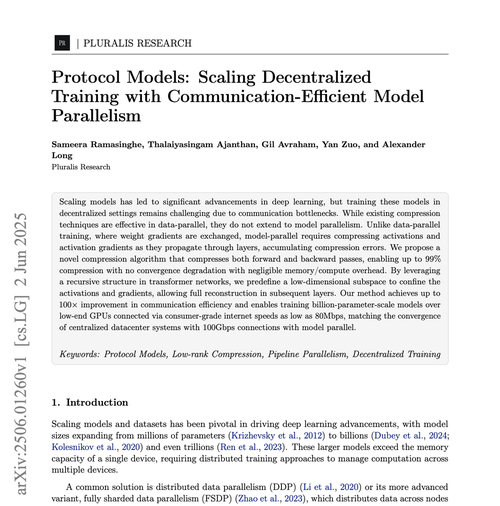

Pluralis Research

Protokoll læring

Pluralis Research lagt ut på nytt

Sannsynligvis den største uken i desentralisert trening til dags dato på bakgrunn av ICLR og mer i ferd med å komme ut. Oppsummering av situasjonen slik den er i dag:

1. Desentralisert RL-ettertrening fungerer tydeligvis. @gensynai det siste med flotte resultater her. Denne prosessen tar en sterk basismodell, gir kopier til deltakere som genererer resonneringsspor som deretter samles inn og brukes til å forbedre basismodellen. Dette er åpenbart avhengig av at basismodellene er tilgjengelige/åpne vekter, og er betydelig billigere enn Pretraining. Noder trenger bare å gjøre slutning. Ulempen er at det er økende bevis (og det er veldig intuitivt) på at det ikke er mulig å RL deg forbi en dårlig basismodell. Så du beholder en avhengighet. Vi må vente på resultatene av disse løpene, men realiteten er at dette kommer til å fungere på en eller annen måte fordi prosessen er så trivielt paralliserbar.

2. Data-Parallel (DP) forhåndstrening ser bra ut. Både @NousResearch og @PrimeIntellect har allerede resultater her på modellstørrelser i skala 10B. Det vil være veldig enkelt (men dyrt for nodeoperatører) å utvide dette til 100B-tilfellet. Dette er fordi i DP beholder hver node en fullstendig kopi av modellen, så du trenger for eksempel 8xh100s for å trene i 10b-størrelsen; Du kan ikke bruke små kort. Så du kan bare utvide denne teknikken ved å skalere opp nodene og gjøre samarbeidstrening på tvers av datasentre (dvs. hver node består av 100 H100-er eller så, og du trener >100b-modellen). Du har også problemet med at alle ser en fullstendig kopi av modellen, så det er ikke klart hvordan de skal tjene penger (Protocol Learning løser dette).

3. Model-Parallel (der selve modellen er delt over noder - tenk 1000 geografisk separate Macbook-er som trener en 100b param-modell, der hver enhet bare har en liten del av den totale modellen) begynte å vise de første anelsene om å være mulig. Vi (@PluralisHQ) publiserte 'Beyond Top k'-artikkelen som komprimerer kommunikasjon mellom noder over 90 %, samt to andre arbeider som viser at du kan bruke heterogene enheter i et Pipeline Parallel (PP)-oppsett. Vi fikk også vår Nesterov-metode for PP akseptert i ICML2025, som så vidt jeg vet er den første artikkelen om desentralisert opplæring akseptert i en stor AI-konferanse siden den originale SWARM-artikkelen, og bør bidra til å katalysere interesse fra vanlige AI-kretser.

Er desentralisert modell-parallell løst → NEI. Kommunikasjonsbåndbredden er så mye dårligere sammenlignet med et datasenter, at selv 90 % ikke er nok. Vi må komme til rundt 300x kompresjon for å oppnå paritet med sentralisert trening. Det gjenstår et stort spørsmål om dette i det hele tatt er mulig - du ødelegger så mye av treningssignalet ved å gjøre dette. Dette er Pluralis' fokus.

Men hva skjer hvis dette fungerer? For første gang kan du gjøre ekte samarbeidstrening. Det er ingen avhengighet av deepseek eller Meta. Enkeltpersoner kan kombinere databehandling for å lage modeller i denne skalaen, fra bunnen av. Vi får faktisk fellesskapsdrevet innovasjon som skjer her på en måte som aldri har eksistert til dags dato. Desentralisert RL-basert ettertrening kan deretter brukes til å gjøre disse modellene enda bedre.

Realiteten er at vi er i de tidligste dagene av noe enormt betydningsfullt som skjer her. Dette kommer til å bli et stort felt. De ovennevnte selskapene fyrer på alle sylindere, en haug til er i ferd med å komme ut av porten snart, og jeg forventer ikke at dette vil avta i det hele tatt fra nå før det som skjer skjer. Og hvis du leser dette, er du tidlig.

14,21K

Topp

Rangering

Favoritter

Trendende onchain

Trendende på X

Nylig toppfinansiering

Mest lagt merke til