Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Pluralis Research

Вивчення протоколів

Користувач Pluralis Research поділився

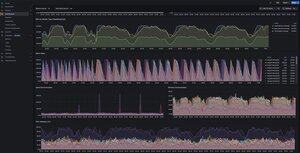

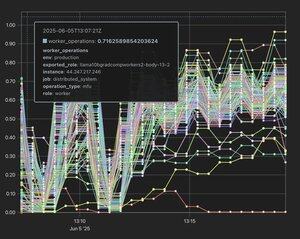

Використання красивих дашбордів Grafana для всього внутрішнє, набагато приємніше, ніж Tensorboard. Wandb все ще хороший, але насправді не працює з децентралізованим навчанням. Змушує мене задуматися, який внутрішній vis tooling в openai - мабуть, неймовірно.

3,04K

Користувач Pluralis Research поділився

Ймовірно, це найбільший тиждень у децентралізованому навчанні на сьогоднішній день після ICLR і ще більше ось-ось вийде. Стислий виклад ситуації на сьогодні:

1. Децентралізоване постнавчання РЛ явно працює. @gensynai тут останні з чудовими результатами. Цей процес бере сильну базову модель, дає копії учасникам, які генерують сліди міркувань, які потім збираються і використовуються для вдосконалення базової моделі. Це, очевидно, залежить від того, що базові моделі доступні/з відкритою вагою, і є значно дешевшими, ніж Pretraining. Вузлам потрібно лише робити умовивід. Недоліком є все більше доказів (і вони дуже інтуїтивно зрозумілі), що неможливо пройти повз погану базову модель. Так ви збережете залежність. Нам потрібно дочекатися результатів цих забігів, але реальність така, що це спрацює так чи інакше, тому що процес дуже тривіально паралізований.

2. Попереднє тренування Data-Parallel (DP) виглядає добре. І @NousResearch, і @PrimeIntellect вже мають тут результати при масштабі 10B розмірів моделей. Буде дуже просто (але дорого для операторів вузлів) розширити це до корпусу 100B. Це пов'язано з тим, що в DP кожен вузол зберігає повну копію моделі, тому вам потрібно, наприклад, 8xh100s, щоб тренуватися на розмірі 10b; Не можна використовувати маленькі картки. Таким чином, ви можете просто розширити цю техніку, масштабуючи вузли та проводячи спільне навчання між центрами обробки даних (тобто кожен вузол складається зі 100 H100 або близько того, і ви тренуєтеся >модель 100b). У вас також є проблема, що всі бачать повну копію моделі, тому не зрозуміло, як монетизувати (Protocol Learning вирішує це).

3. Model-Parallel (де сама модель розділена на вузли - згадайте 1000 географічно відокремлених Macbook, які навчають модель 100b param, де кожен пристрій має лише невелику частину загальної моделі) почала демонструвати перші натяки на можливість. Ми (@PluralisHQ) опублікували статтю «Beyond Top k», яка стискає комунікації між вузлами більш ніж на 90%, а також дві інші роботи, які показують, що ви можете використовувати гетерогенні пристрої в конфігурації Pipeline Parallel (PP). Ми також прийняли в ICML2025 наш метод Нестерова для ПП, який, наскільки мені відомо, є першим документом про децентралізоване навчання, прийнятим на велику конференцію зі штучного інтелекту після оригінального документа SWARM, і має допомогти каталізувати інтерес з боку основних кіл штучного інтелекту.

Чи вирішується децентралізована модель-паралель → НІ. Пропускна здатність зв'язку настільки гірша в порівнянні з дата-центром, що навіть 90% не вистачає. Нам потрібно досягти приблизно 300-кратного стиснення, щоб досягти паритету з централізованим навчанням. Залишається величезне питання, чи можливо це взагалі - ви цим знищуєте дуже багато тренувального сигналу. Саме на цьому і зосереджений Pluralis.

Однак, що станеться, якщо це спрацює? Вперше ви зможете провести справжню спільну попередню підготовку. Немає залежності від deepseek або Meta. Приватні особи можуть комбінувати обчислення для створення моделей у такому масштабі, з нуля. Ми отримуємо справжні інновації, керовані спільнотою, які відбуваються тут у спосіб, якого досі не існувало. Децентралізоване постнавчання на основі RL може бути використане для того, щоб зробити ці моделі ще кращими.

Реальність така, що ми знаходимося на початку того, що тут відбувається щось надзвичайно важливе. Це буде основна сфера. Перераховані вище компанії стріляють по всіх циліндрах, незабаром з воріт ось-ось вийде ще купа, і я не очікую, що відтепер це зовсім сповільниться, поки не станеться що станеться. І якщо ви читаєте це, ви ще рано.

14,21K

Найкращі

Рейтинг

Вибране

Актуальне ончейн

Популярні в X

Нещодавнє найкраще фінансування

Найбільш варте уваги