Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Ero uno dei 16 sviluppatori in questo studio. Volevo esprimere le mie opinioni sulle cause e le strategie di mitigazione per il rallentamento degli sviluppatori.

Dirò come un gancio "perché dovremmo ascoltarti?" che ho sperimentato un -38% di accelerazione AI sui miei problemi assegnati. Penso che la trasparenza aiuti la comunità.

11 lug, 01:23

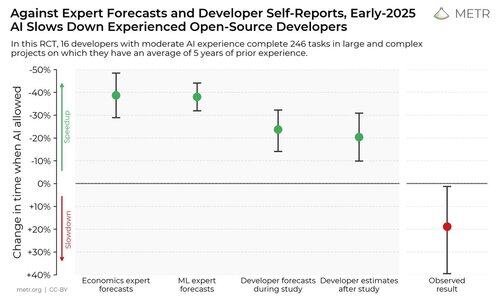

Abbiamo condotto uno studio controllato randomizzato per vedere quanto gli strumenti di codifica AI accelerino gli sviluppatori esperti di open-source.

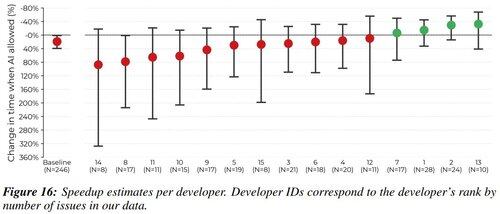

I risultati ci hanno sorpreso: gli sviluppatori pensavano di essere più veloci del 20% con gli strumenti AI, ma in realtà erano l'19% più lenti quando avevano accesso all'AI rispetto a quando non lo avevano.

In primo luogo, penso che l'accelerazione dell'IA sia molto debolmente correlata all'abilità di qualcuno come sviluppatore. Tutti gli sviluppatori in questo studio sono molto bravi. Penso che abbia più a che fare con il cadere in modalità di fallimento, sia nell'abilità del LLM che nel flusso di lavoro umano. Lavoro con un sacco di sviluppatori di pretraining straordinari e penso che le persone affrontino molti degli stessi problemi.

Ci piace dire che i LLM sono strumenti, ma li trattiamo più come un proiettile magico.

Letteralmente, qualsiasi sviluppatore può attestare la soddisfazione di risolvere finalmente un problema difficile. I LLM sono un grande pulsante di scorciatoia per la dopamina che potrebbe risolvere il tuo problema in un colpo solo. Continui a premere il pulsante che ha l'1% di possibilità di risolvere tutto? È molto più piacevole rispetto all'alternativa estenuante, almeno per me.

Penso che i casi di sovrautilizzo degli LLM possano verificarsi perché è facile ottimizzare per il piacere percepito piuttosto che per il tempo di soluzione mentre si lavora.

Io che premo tab nel cursore per 5 ore invece di fare debug per 1:

In terzo luogo, è super facile distrarsi durante il tempo di inattività mentre i LLM stanno generando. L'economia dell'attenzione sui social media è brutale, e penso che le persone passino 30 minuti a scorrere mentre "aspettano" la loro generazione di 30 secondi.

Tutto ciò che posso dire su questo è che dovremmo conoscere i nostri punti deboli e cercare di riempire questo tempo di generazione LLM in modo produttivo:

- Se il compito richiede alta concentrazione, sfrutta questo tempo per lavorare su un sotto-compito o pensare a domande di follow-up. Anche se il modello risponde perfettamente alla tua domanda, cosa altro non capisco?

- Se il compito richiede bassa concentrazione, fai un altro piccolo compito nel frattempo (rispondi a email/slack, leggi o modifica un altro paragrafo, ecc).

Come sempre, piccoli passi di igiene digitale aiutano in questo (bloccatori di siti web, telefono in modalità non disturbare, ecc). Scusa se sembro un rompiscatole, ma funziona per me :)

Alcune dichiarazioni finali:

- METR è un'organizzazione meravigliosa con cui lavorare, e sono scienziati competenti. Mi è piaciuto partecipare a questo studio e leggere i loro risultati.

- Non sono un guru dei LLM che cerca di predicare. Pensate a questo come a una mia pubblicazione di un'entrata personale di diario, sperando che altri possano trarre beneficio dalla mia introspezione.

1,72M

Principali

Ranking

Preferiti