Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Eu fui um dos 16 desenvolvedores neste estudo. Queria falar sobre as minhas opiniões sobre as causas e estratégias de mitigação para a desaceleração dos desenvolvedores.

Vou dizer como um gancho de "por que devo ouvir você?" que experimentei uma aceleração de -38% na IA nas minhas questões atribuídas. Acho que a transparência ajuda a comunidade.

11/07, 01:23

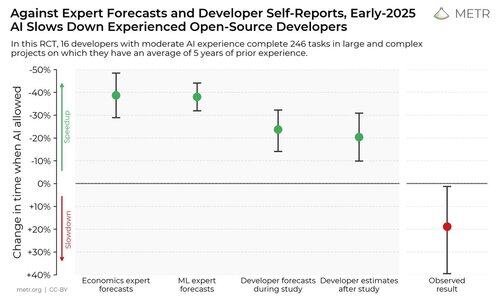

Realizámos um ensaio clínico randomizado controlado para ver quanto tempo os ferramentas de codificação de IA aceleram os desenvolvedores experientes de código aberto.

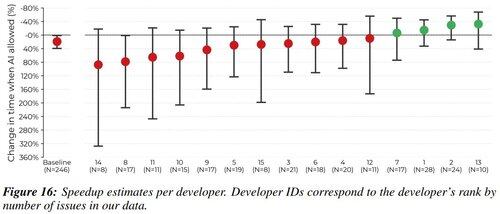

Os resultados surpreenderam-nos: os desenvolvedores pensavam que eram 20% mais rápidos com as ferramentas de IA, mas na verdade eram 19% mais lentos quando tinham acesso à IA do que quando não tinham.

Em primeiro lugar, acho que a aceleração da IA está muito fraca em correlação com a capacidade de alguém como desenvolvedor. Todos os desenvolvedores neste estudo são muito bons. Acho que tem mais a ver com cair em modos de falha, tanto na capacidade do LLM quanto no fluxo de trabalho do humano. Trabalho com um monte de desenvolvedores incríveis de pré-treinamento, e acho que as pessoas enfrentam muitos dos mesmos problemas.

Gostamos de dizer que os LLMs são ferramentas, mas tratamo-los mais como uma bala mágica.

Literalmente, qualquer desenvolvedor pode atestar a satisfação de finalmente depurar um problema complicado. Os LLMs são um grande botão de atalho de dopamina que pode resolver seu problema de uma só vez. Você continua pressionando o botão que tem 1% de chance de consertar tudo? É muito mais agradável do que a alternativa extenuante, pelo menos para mim.

Acho que casos de uso excessivo de LLM podem acontecer porque é fácil otimizar para o prazer percebido em vez do tempo até a solução enquanto se trabalha.

Eu pressionando a tecla tab no cursor por 5 horas em vez de depurar por 1:

Em terceiro lugar, é super fácil distrair-se durante o tempo de espera enquanto os LLMs estão a gerar. A economia de atenção das redes sociais é brutal, e eu acho que as pessoas passam 30 minutos a rolar enquanto "esperam" pela sua geração de 30 segundos.

Tudo o que posso dizer sobre isso é que devemos conhecer as nossas próprias armadilhas e tentar preencher este tempo de geração de LLM de forma produtiva:

- Se a tarefa requer alta concentração, aproveite este tempo para trabalhar em uma subtarefa ou pensar em perguntas de acompanhamento. Mesmo que o modelo responda à sua pergunta de forma direta, o que mais eu não entendo?

- Se a tarefa requer baixa concentração, faça outra pequena tarefa enquanto isso (responder a e-mails/slack, ler ou editar outro parágrafo, etc).

Como sempre, pequenos passos de higiene digital ajudam com isso (bloqueadores de sites, telefone em modo não perturbe, etc). Desculpe ser chato, mas funciona para mim :)

Algumas declarações finais:

- A METR é uma organização maravilhosa para trabalhar, e eles são cientistas competentes. Adorei tanto participar deste estudo quanto ler os seus resultados.

- Não sou um guru de LLM tentando pregar. Pense nisso como eu publicando uma entrada de diário pessoal, e esperando que outros possam beneficiar da minha introspecção.

1,72M

Top

Classificação

Favoritos