Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Le aziende che costruiscono benchmark migliori cresceranno più velocemente delle aziende che costruiscono modelli migliori

L'AI può già risolvere scacchi, esami e contest di programmazione, ma non riesce ancora a prenotare affidabilmente una cena

Il collo di bottiglia è passato dall'intelligenza alla valutazione

27 ago 2025

questo è uno dei migliori post del blog del 2025 da parte del ricercatore di openai @ShunyuYao12.

"siamo all'intervallo dell'AI,"

è un manuale su ciò che conterà di più nella ricerca sull'AI e nell'ecosistema delle startup, e su come prepararsi al meglio per questo.

per decenni, la ricerca sull'AI si è concentrata su algoritmi e nuovi modelli per superare i benchmark.

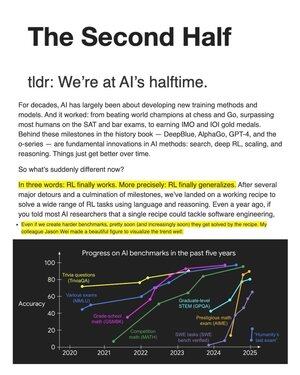

ma qualcosa di importante ha cambiato le regole del gioco: "RL finalmente generalizza."

la "ricetta" funzionante: pre-addestramento massiccio del linguaggio (priori) + scala + ragionamento-come-azione all'interno di un ciclo RL.

il risultato di questa scalata ai benchmark. il gioco cambia: da risolvere problemi a definire i problemi giusti. la valutazione diventa il fulcro.

il benchmark centrale ora è il "problema di utilità". i benchmark non si traducono bene in compiti del mondo reale.

quindi questo è il manuale per il secondo tempo: inventare configurazioni di valutazione legate a una reale utilità; poi applicare la ricetta per vincere secondo queste nuove regole.

nella RL il trio chiave è ambiente, algoritmi e priori. abbiamo trascorso così tanto tempo sui migliori algoritmi, ma gli algoritmi si adattano eccessivamente all'ambiente in cui nascono.

per il "secondo tempo", valutazione = design dell'ambiente: costruire configurazioni più vicine alla realtà (umano-nel-loop, non-IID, sequenziale/con memoria) per guidare una reale utilità, non solo vittorie nei benchmark.

367

Principali

Ranking

Preferiti