Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Selskapene som bygger bedre benchmarks vil vokse raskere enn selskapene som bygger bedre modeller

AI kan allerede løse sjakk-, eksamens- og kodekonkurranser, men kan fortsatt ikke bestille en middagsreservasjon på en pålitelig måte

Flaskehalsen har flyttet seg fra intelligens til evaluering

27. aug. 2025

Dette er et av de beste blogginnleggene i 2025 av OpenAI-forskeren @ShunyuYao12.

"vi er i AIs pause,"

det er en spillebok for hva som vil bety mest i AI-forskning og oppstartsøkosystemet, og hvordan du forbereder deg best mulig på det.

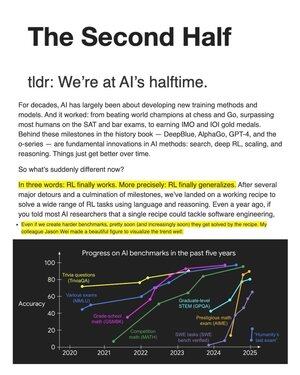

i flere tiår fokuserte AI-forskning på algoritmer og nye modeller for å slå referansene.

men noe viktig har endret spillet: "RL generaliserer endelig."

den fungerende "oppskriften": massiv språktrening (priors) + skala + resonnement-som-handling inne i en RL-sløyfe.

resultatet av denne referanseklatringen. Spillet skifter: fra å løse problemer til å definere de riktige problemene. evaluering blir sentrum.

Kjernemålestokken nå er "nytteproblemet". Benchmarks oversettes egentlig ikke godt til virkelige oppgaver.

Så dette er spilleboken for andre halvdel: Oppfinn evalueringsoppsett knyttet til reell nytte; Bruk deretter oppskriften for å vinne under de nye reglene.

i RL er nøkkeltrioen miljø, algoritmer og priorer. Vi har brukt så mye tid på de beste Algo-ene, men Algo-overpasser til miljøet de er født i.

for "andre halvdel", evaluering = miljødesign: bygg oppsett nærmere virkeligheten (menneske-i-løkken, ikke-IID, sekvensiell/med minne) for å drive reell nytte, ikke bare benchmark-seire.

380

Topp

Rangering

Favoritter